Amazon Web Services (AWS) hat eine Sammlung von Open-Source-Servern auf den Markt gebracht, wobei das Modellkontextprotokoll (MCP) verwendet wird, um die Interaktion mit AWS-Diensten und-Daten zu verbessern, um die Interaktion von AWS-Diensten und-daten zu verbessern. Detailliert in awslabs/mcp Github repository und unter einem Diese Server bieten AI-Agenten eine standardisierte Möglichkeit, auf einen genauen Echtzeit-AWS-Kontext zuzugreifen, die Cloud-Entwicklungs-Workflows zu verbessern und die Codequalität zu verbessern. href=”https://modelcontextProtocol.io/Introduction”target=”_ leer”> Modellkontextprotokoll wurde erstmals im November 2024 durch Anthropic eingeführt. Es befasst sich mit dem allgemeinen Problem von AI-Modellen, die den Zugriff auf notwendige externe Informationen oder Tools fehlten. Wie in der offiziellen MCP-Dokumentation heißt es: „Das Modellkontextprotokoll (MCP) ist ein offenes Protokoll, das eine nahtlose Integration zwischen LLM-Anwendungen und externen Datenquellen und-Tools ermöglicht. Anstatt zahlreiche kundenspezifische Integrationen zu erstellen, können Entwickler MCP-Clients (innerhalb von AI-Assistenten) über HTTP mit MCP-Servern herstellen, die spezifische Funktionen oder Datenzugriffspunkte aufdecken. AWS-Server zielen auf spezifische Cloud-Aufgaben ab

Die anfängliche Version von AWS enthält mehrere Server, die sich auf verschiedene Bereiche konzentrieren:

Core MCP-Server: fungiert als Koordinator für die Verwaltung anderer AWS-MCP-Server. ( docs ) AWS-Dokumentation: Zugriff auf aktuelle AWS-Dokumente über die offizielle Such-API. ( docs ) Amazon-Bedrock-Wissensbasis Abrufen: Ermöglicht das Abfragen von privaten Einsparungen von privaten Einspeisen (RAGURTUGBETRIGTE DER FRESSENPRESPRISE-ENTRISCHEN (RAGUMING VON BEDRISCHEN). Bedrock ist AWSs Managed Service für Foundation-Modelle. (Docs) AWS CDK & AWS Terraform: Offer tools for Infrastructure as Code (IaC), including Checkov integration in the Terraform server for security analysis. ( cdk docs , docs ) Amazon Nova Canvas: Integriert in das eigene Bild-Generation-Modell von Amazon, Teil seiner Nova-Ai-Familie. ( docs ) AWS-Diagramm: Architekturdiagramme über Python-Code. ( docs ) AWS Lambda: lets ai Agents auslösen spezifischen Lambda-Funziktionen als Tools. ( docs )

Die Absicht der Absicht, die Zugriffszugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Zugriffs-Domänen-Domänen-Wissenswissenschaften zu Domänen zu ermöglichen.

Setup-und Ökosystemintegration

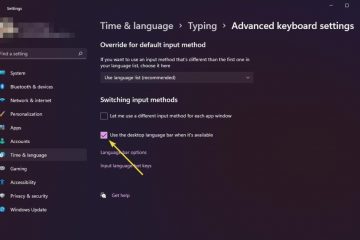

Das Einrichten dieser Server erfordert die Installation des `uv` uv` paket. Anmeldeinformationen. Die Server selbst werden normalerweise mit dem Befehl `uvx` (in dem Pakete in temporären Umgebungen ausgeführt werden) über Pakete auf PYPI ausgeführt. Die Konfiguration erfolgt im Client-Tool, wobei JSON-Dateien wie ~/.AWS/Amazonq/McP.json für die Amazon Q CLI, ~/.cursor/McP.json für die crorsor reditor, oder ~/.Codeor/.-/.-/.-/.-/.Codeor/.Codeor/.-/.-/.-/.-/.-/.-/.-/.-/.-/.-/.-/.-/./. Windsurf. AWS erwähnt auch die Unterstützung für die Claude-Desktop-App und Cline von Anthropic. Entwickler können spezifische Setup-Leitlinien finden und Code-Proben Im Repository. Microsoft integrierte das Protokoll im März 2025 in Azure AI und entwickelte einen offiziellen c# sdk . Microsoft hat auch MCP mit Tools wie dem semantischen Kernel-Framework angeschlossen und vor Tagen am 18. April seine eigenen MCP-Server für Azure-Dienste in der Vorschau an. Während der Standardisierung der Schnittstelle die praktische Verwendung für einige Anwendungen und die Notwendigkeit, dass Entwickler eine robuste Fehlerbehebung und Sicherheit in Bezug auf die Server-Interaktionen implementieren, müssen zwar immer noch die potenzielle HTTP-Latenz beachtet werden. Die Strategie von Amazon erscheint vielfältig und ergänzt diese offene Standardeinführung mit fortgesetzter Entwicklung seiner internen NOVA-AI-Modelle und Tools wie dem Nova ACT SDK.