Microsoft hat Phi-4, sein kompaktes Sprachmodell, als Open-Source-Lösung für die Öffentlichkeit zugänglich gemacht, indem es seine vollständigen Versionen auf Hugging Face unter einer MIT-Lizenz veröffentlicht hat.

Phi-4 wurde erstmals im Dezember 2024 eingeführt Die Azure AI Foundry-Plattform von Microsoft war ursprünglich nur für Forscher unter einer kontrollierten Lizenz verfügbar. Mit der Open-Source-Veröffentlichung stellt Microsoft Forschern und Entwicklern weltweit die Tools zur Verfügung, um das kompakte und dennoch leistungsstarke Modell anzupassen, bereitzustellen und zu kommerzialisieren.

Phi-4: Ein kompaktes Modell mit übergroßen Abmessungen Ergebnisse

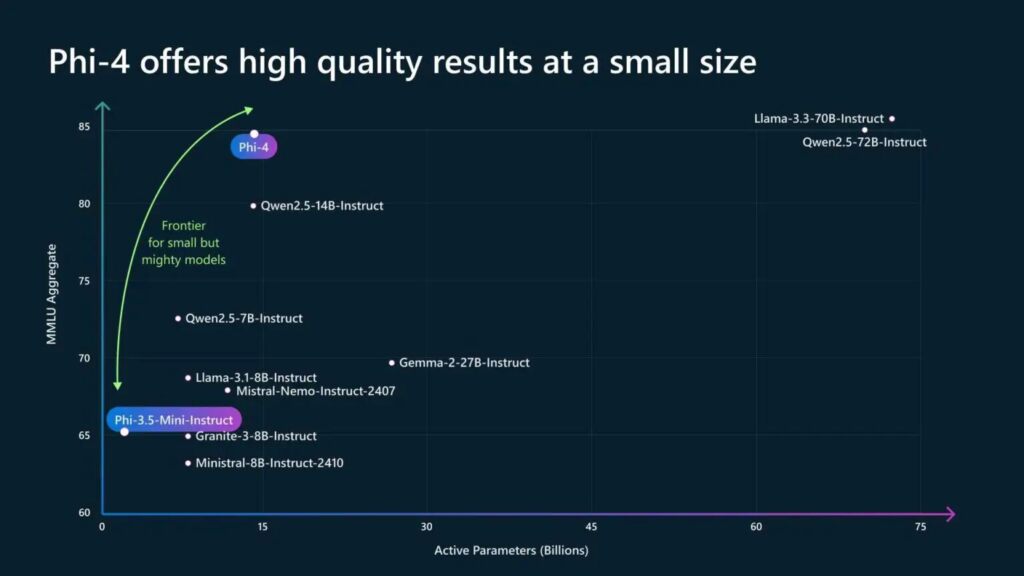

Phi-4 stellt eine Abkehr von der traditionellen KI-Entwicklung dar, bei der die Skalierung häufig als primäre Leistungsmetrik priorisiert wurde. Mit nur 14 Milliarden Parametern liefert Phi-4 Ergebnisse, die mit größeren Gegenstücken wie Googles Gemini Pro 1.5 und OpenAIs GPT-4o mithalten und diese sogar übertreffen.

Quelle: Microsoft

Quelle: Microsoft

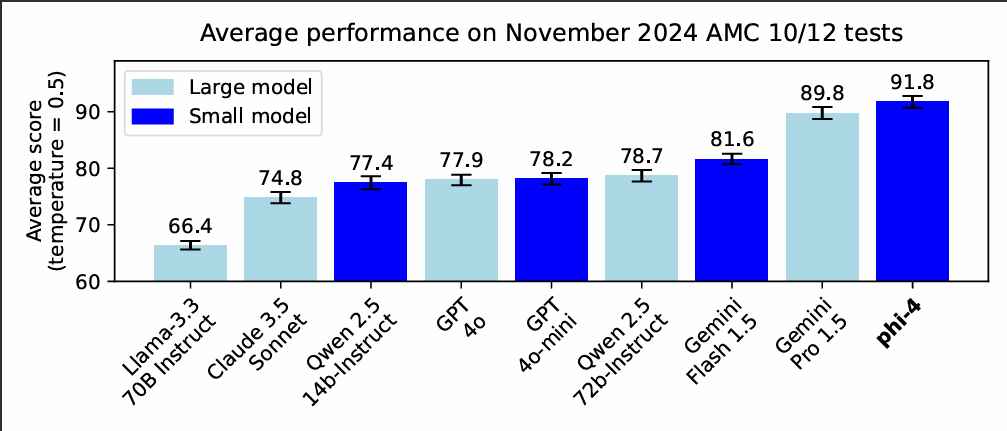

In letzter Zeit Benchmarks erzielte Phi-4 beim American Mathematics Competition (AMC 12) eine beeindruckende Punktzahl von 91,8 und übertraf damit die Punktzahl von Gemini Pro 1.5 von 89,8 und GPT-4os 77,9.

Microsoft demonstrierte die mathematischen Denkfähigkeiten von Phi-4 anhand eines kombinatorischen Problems, bei dem das Modell 431 verschiedene Permutationen für eine hypothetische Rasse mit fünf Schnecken genau berechnete.

Phi-4 übertrifft viel größere Modelle, einschließlich Gemini Pro 1.5, bei mathematischen Wettbewerbsproblemen (Quelle: Microsoft)

Phi-4 übertrifft viel größere Modelle, einschließlich Gemini Pro 1.5, bei mathematischen Wettbewerbsproblemen (Quelle: Microsoft)

Dieses Maß an Präzision unterstreicht sein Potenzial für Bereiche, die logische und mathematische Genauigkeit erfordern, wie z Finanzen, Technik und wissenschaftliche Forschung.

Microsoft erläuterte seine Ziele für Phi-4 in seiner offiziellen Dokumentation: „Phi-4 verschiebt weiterhin die Grenze zwischen Größe und Qualität“, eine Meinung, die von Forschern bestätigt wird, die dies getan haben verglich seine Leistung mit Modellen mit der fünffachen Anzahl an Parametern.

Trainingsmethodik und synthetische Daten

Die Grundlage für den Erfolg von Phi-4 liegt in seinem Training Ansatz. Microsoft nutzte synthetische Datensätze, die Folgendes umfassen: Inhalte im Lehrbuchstil mit Schwerpunkt auf mathematischem Denken, Programmierung und vernünftiger Logik. Diese Datensätze, die insgesamt 9,8 Billionen Token umfassen, wurden durch kuratierte öffentliche Dokumente, akademische Texte und mehrsprachige Daten ergänzt.

„Synthetische Daten dienen nicht als billiger Ersatz für organische Daten, sondern bieten direkte Vorteile“, bemerkte Microsoft In seinem technischen Bericht wird die Kontrolle und Anpassungsfähigkeit hervorgehoben, die er während des Modelltrainings bietet. Dieser Ansatz verringerte auch die Abhängigkeit von Web-Scraping-Inhalten, die oft wegen Qualitätsinkonsistenzen kritisiert werden.

Zur Verbesserung der Um die Argumentation und Ausrichtung des Modells zu verbessern, wandte Microsoft fortschrittliche Post-Training-Techniken wie überwachte Feinabstimmung und direkte Präferenzoptimierung an. Diese Methoden verfeinerten die Fähigkeit von Phi-4, zwischen qualitativ hochwertigen und minderwertigen Ausgaben zu unterscheiden, und steigerten so seine domänenspezifische Genauigkeit weiter Anwendungen.

Open-Source-Verfügbarkeit

Die Entscheidung, Phi-4 als Open-Source zu veröffentlichen, spiegelt Microsofts umfassendere Strategie zur Demokratisierung von KI wider Entwickler können jetzt über Hugging Face, wo die vollständigen Gewichte unter einer MIT-Lizenz verfügbar sind. Shital Shah, Chefingenieur bei Microsoft, kündigte die Veröffentlichung auf >Wir waren völlig erstaunt über die Reaktion auf die Veröffentlichung von Phi-4. Viele Leute hatten uns nach einer Gewichtsfreigabe gefragt.

Nun, nein mehr. Wir veröffentlichen heute das offizielle Phi-4-Modell auf HuggingFace!

Mit MIT-Lizenz!! pic.twitter.com/rcugWBPU4r

– Shital Shah (@sytelus) 8. Januar 2025

Die Open-Source-Version ermöglicht Entwicklern die Anpassung von Phi-4 für spezifische Anwendungen ohne den Rechenaufwand, der normalerweise mit größeren Modellen verbunden ist. Seine dichte, reine Decoder-Architektur, eine Variante des Das Transformer-Modell minimiert den Ressourcenbedarf und macht es auch für Organisationen mit begrenzter Infrastruktur zugänglich.

Ethische Überlegungen und Auswirkungen auf die Branche

Microsofts Einführung von Phi-4 ist ein Highlight sein Engagement für einen verantwortungsvollen KI-Einsatz. Die Azure AI Foundry-Plattform, auf der Phi-4 ursprünglich gehostet wurde, umfasst Sicherheitsmaßnahmen wie Inhaltsfilterung und kontroverse Tests. Diese Maßnahmen sollen Risiken wie Voreingenommenheit, Fehlinformationen und die Generierung schädlicher Inhalte mindern.

Mit der Veröffentlichung von Phi-4 unter einer Open-Source-Lizenz kommt Microsoft auch dem wachsenden Bedarf an Transparenz in der KI-Entwicklung entgegen. Der Schritt steht im Einklang mit Branchentrends, die in Veröffentlichungen wie Metas Llama 3.2 und der Gemma-Serie von Google zu beobachten sind, obwohl die herausragende Leistung des Phi-4 in Benchmarks einen neuen Standard für kompakte Modelle setzt.

Phi-4 stellt die Annahme in Frage, dass größere Modelle sind von Natur aus besser. Sein kompaktes Design reduziert nicht nur die Rechen-und Energiekosten, sondern erweitert auch den Zugang zu erweiterten KI-Funktionen. Diese Effizienz ist besonders wertvoll für mittelständische Organisationen und Forscher, denen die Ressourcen für den Einsatz umfangreicher Modelle fehlen.

Während sich die KI weiterentwickelt, bietet Phi-4 einen Blick in eine Zukunft, in der kleinere, intelligentere Modelle zusammentreffen können Erfüllen Sie die Anforderungen spezieller Aufgaben, ohne Kompromisse bei der Leistung einzugehen.