Anthropic, das für seinen Claude-Chatbot bekannte KI-Labor, hat sich bereit erklärt, Schutzmaßnahmen durchzusetzen und aufrechtzuerhalten, die verhindern, dass seine Modelle urheberrechtlich geschützte Songtexte generieren.

Diese Entscheidung ist Teil einer rechtliche Einigung mit prominenten Musikverlagen, darunter Universal Music Group und Concord Music Group, die dem Unternehmen eine Urheberrechtsverletzung vorwarfen, weil es Songtexte ohne diese Verwendung verwendet hatte Autorisierung in KI-Trainingsdatensätzen.

Genehmigt von U.S. Bezirksrichterin Eumi Lee, die Vereinbarung löst Teile einer von den Verlagen beantragten einstweiligen Verfügung. Es zwingt Anthropic, seine bestehenden „Leitplanken“ gegenüber Claude und ähnlichen Modellen beizubehalten, um die Reproduktion von urheberrechtlich geschütztem Material zu verhindern.

Der Fall markiert einen entscheidenden Wendepunkt in der wachsenden Spannung zwischen KI-Innovation und geistigen Eigentumsrechten.

Die Vorwürfe: Unlizenzierte Nutzung von Songtexten

In der im Oktober 2023 eingeleiteten Klage wird behauptet, dass Anthropic seine KI-Systeme mit Texten aus über 500 Songs trainiert habe, ohne sich Lizenzen wie „Roar“ von Katy Perry zu sichern und Werke von The Rolling Stones und Beyoncé, in denen dem KI-Tool vorgeworfen wird, nahezu wörtliche Reproduktionen dieser Liedtexte zu erzeugen.

Ein Beispiel wird in der beschriebenen Akte aufgeführt Claude produziert eine „nahezu identische Kopie“ von Perry’s Roar. Die Herausgeber argumentierten, dass diese unbefugte Nutzung nicht nur gegen das Urheberrecht verstößt, sondern auch ihre Beziehungen zu Songwritern und anderen Interessengruppen untergräbt.

„Anthropics unlizenzierte Verwendung von urheberrechtlich geschütztem Material schädigt die Beziehungen der Herausgeber zu aktuellen und potenziellen Songwriter-Partnern irreversibel. „ heißt es in der Klage und betont die weitreichenderen Auswirkungen auf das Branchenvertrauen.

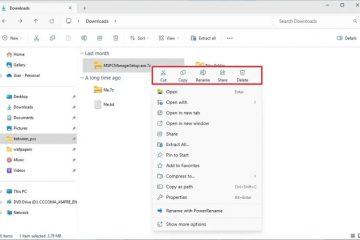

Leitplanken: Wie sie funktionieren und ihre Rolle dabei Compliance

Leitlinien sind technische Maßnahmen zur Begrenzung der KI-Ausgaben, um sicherzustellen, dass Modelle wie Claude kein urheberrechtlich geschütztes oder schädliches Material reproduzieren. Diese Schutzmaßnahmen können Filter umfassen, die bestimmte Ausgaben blockieren, sowie Algorithmen zur Erkennung und Verhinderung wörtliche Wiedergabe von Trainingsdaten und Überwachungsmechanismen für Benutzerinteraktionen mit dem Modell.

Anthropic behauptet, seine aktuellen Leitplanken seien robust und in der Lage, solche Ausgaben zu verhindern. „Wir haben zahlreiche Es gibt Prozesse, die solche Verstöße verhindern sollen. Unsere Entscheidung, dieser Vereinbarung zuzustimmen, steht im Einklang mit diesen Prioritäten Anthropic behält sich das Recht vor, seine Methoden zu optimieren, es kann die Wirksamkeit seiner Schutzmaßnahmen jedoch nicht beeinträchtigen.

Fair Use und rechtliche Präzedenzfälle

Anthropic hat die Verwendung von urheberrechtlich geschütztem Material im Rahmen der „Fair-Use“-Doktrin verteidigt und argumentiert, dass das Training generativer KI-Modelle dies erfordert transformative Anwendung von Daten. In den rechtlichen Unterlagen des Unternehmens heißt es: „Wir freuen uns weiterhin darauf, zu zeigen, dass die Verwendung potenziell urheberrechtlich geschützten Materials beim Training generativer KI-Modelle im Einklang mit dem bestehenden Urheberrecht eine grundsätzlich faire Nutzung darstellt.“

Allerdings ist die Verlage behaupten, dass diese Praxis ihre Arbeit entwertet und bestehende Lizenzmärkte beeinträchtigt. Sie argumentieren, dass KI-Unternehmen etablierte Kanäle für die Lizenzierung umgehen, was zu wirtschaftlichen Schäden und Reputationsschäden für Künstler führt Verlage.

Diese Klage ist die erste, die sich auf Liedtexte in KI-Trainingsdatensätzen konzentriert, aber sie steht im Einklang mit umfassenderen Streitigkeiten. OpenAI wurde mit ähnlichen Vorwürfen wegen der Verwendung von Nachrichtenartikeln konfrontiert, während die New York Times und andere Medien Verkaufsstellen haben Bedenken geäußert, dass KI-generierte Inhalte ihre Arbeit reproduzieren könnten.

Auswirkungen auf die Branche und Zukunftsaussichten

Die Anthropic-Klage verdeutlicht die Herausforderungen beim technologischen Ausgleich Fortschritte beim Schutz des geistigen Eigentums. Da generative KI in Branchen von Unterhaltung bis Journalismus immer wichtiger wird, stehen Unternehmen unter dem Druck, diese rechtlichen und ethischen Komplexitäten zu bewältigen.

Proaktive Lizenzvereinbarungen können einen Weg nach vorne bieten. OpenAI hat bereits mit Verlagen wie TIME und Associated Press zusammengearbeitet, während Microsoft Verträge mit HarperCollins abgeschlossen hat, um seine Sachbuchtitel für KI-Schulungen zu nutzen.

Anthropics Vereinbarung mit Musikverlagen könnte als Vorlage für zukünftige Lösungen dienen. Demonstration der Bedeutung transparenter und durchsetzbarer Compliance-Mechanismen. Da Richter Lee jedoch noch nicht über die umfassendere Frage entschieden hat, ob nicht lizenziertes KI-Training eine faire Nutzung darstellt, könnte der Ausgang des Falles einen Präzedenzfall schaffen.