AWS hat mit der Vorstellung seiner Trainium2-Chips der zweiten Generation und der Einführung von Trn2 UltraServern, die darauf ausgelegt sind, die Grenzen der Leistung von Large Language Models (LLM) zu verschieben, einen bedeutenden Sprung in der KI-Infrastruktur gemacht.

Auf der Re angekündigt Auf der:Invent-Konferenz positionieren diese Entwicklungen AWS als herausragenden Akteur in der sich schnell entwickelnden KI-Landschaft. AWS gab außerdem eine Vorschau auf Trainium3, einen Chip der nächsten Generation, der eine vierfache Leistungssteigerung verspricht und Ende 2025 auf den Markt kommen soll.

David Brown, Vizepräsident für Compute and Networking bei AWS, beschrieb die Bedeutung dieser Innovationen:

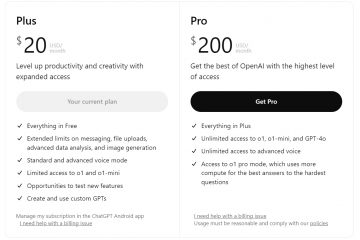

„Trainium2 ist der leistungsstärkste AWS-Chip, der bisher entwickelt wurde.“ Und da Modelle nahezu Billionen von Parametern umfassen, wussten wir, dass Kunden einen neuartigen Ansatz benötigen würden, um diese riesigen Modelle zu trainieren und auszuführen. Die neuen Trn2 UltraServer bieten die schnellste Trainings-und Inferenzleistung auf AWS für die weltweit größten Modelle-Trainium2-AI-Chips-official-scaled.jpg”>

Trainium2: Erschließung beispielloser Rechenleistung

Trainium2-Chips wurden entwickelt, um den steigenden Rechenanforderungen moderner KI-Modelle gerecht zu werden, und bieten bis zu 20,8 Petaflops dichter FP8-Rechenleistung pro Instanz.

Jede EC2 Trn2-Instanz integriert 16 Trainium2-Chips, die über den proprietären NeuronLink von AWS verbunden sind Interconnect, das eine Kommunikation mit geringer Latenz und hoher Bandbreite gewährleistet. Diese Architektur ermöglicht eine nahtlose Skalierbarkeit, die für die Schulung und Bereitstellung umfangreicher Anwendungen von entscheidender Bedeutung ist LLMs.

AWS demonstrierte die Fähigkeiten von Trainium2 mit dem Llama 405B-Modell von Meta, das laut Angaben des Unternehmens „einen dreimal höheren Durchsatz bei der Token-Generierung im Vergleich zu anderen verfügbaren Angeboten großer Cloud-Anbieter“ erzielte.

Diese Verbesserung beschleunigt Aufgaben wie Textgenerierung, Zusammenfassung und Echtzeitinferenz erheblich und erfüllt damit die Anforderungen von Unternehmen, die auf generative KI angewiesen sind.

[eingebettet Inhalt]

UltraServer: Skalierung über Grenzen hinaus

Für Unternehmen, die Billionen-Parameter-Modelle in Angriff nehmen, hat AWS Trn2 UltraServer eingeführt, die 64 Trainium2-Chips kombinieren, um bis zu liefern 83,2 Petaflops spärliche FP8-Leistung.

Die Server ermöglichen schnellere Trainingszeiten und Echtzeit-Inferenz für extrem große KI-Modelle, was einen entscheidenden Fortschritt für Unternehmen darstellt, die dies anstreben stellen hochkomplexe Systeme bereit.

Gadi Hutt, Senior Director bei Annapurna Labs, erklärte die Fähigkeiten der UltraServer:

„Als nächstes durchbrechen wir die [16-Chip-]Grenze und stellen 64 Chips im UltraServer bereit. und das gilt für extrem große Modelle. Wenn Sie also ein Modell mit 7 Milliarden Parametern haben, war das früher groß, aber nicht mehr – oder ein extrem großes Modell, nennen wir es 200 Milliarden oder 400 Milliarden. Sie möchten mit der schnellstmöglichen Latenz bereitstellen. Sie verwenden also den UltraServer Cluster, der Hunderttausende von Trainium2-Chips enthalten wird.

AWS beschreibt ihn als fünfmal leistungsstärker als die aktuellen Systeme von Anthropic und den weltweit größten bisher gemeldeten KI-Rechencluster. unterstreicht das Engagement von AWS, seine Partner mit modernster Technologie auszustatten.

Anthropic, bekannt für sein Claude 3.5 Sonnet LLM, verlässt sich auf die AWS-Infrastruktur, um sich einen Wettbewerbsvorteil gegenüber Konkurrenten wie OpenAI und Google zu verschaffen. AWS hat seinen Wert kürzlich verdoppelt Die Investition in Anthropic beläuft sich auf 8 Milliarden US-Dollar und stärkt damit den strategischen Fokus auf generative KI.

Trainium3: Die Zukunft der KI gestalten Compute

AWS kündigte außerdem Trainium3 an, seinen kommenden Chip, der auf einem Drei-Nanometer-Prozess basiert und eine viermal höhere Leistung als UltraServer verspricht. Trainium3 wird voraussichtlich Ende 2025 auf den Markt kommen und ein noch schnelleres Training und Inferenz für KI-Modelle der nächsten Generation ermöglichen und damit die Führungsposition von AWS im Bereich KI-Computing weiter festigen.

David Brown skizzierte die Vision von AWS für den neuen Chip: „Mit unserem Mit Trainium3-Chips der dritten Generation werden wir es Kunden ermöglichen, größere Modelle schneller zu bauen und bei deren Bereitstellung eine überlegene Echtzeitleistung zu liefern.“

Die Strategie von AWS mit Trainium3 zielt darauf ab, die von Nvidia herauszufordern Dominanz auf dem KI-Hardwaremarkt. Während die kommenden Blackwell-GPUs eine FP8-Leistung von bis zu 720 Petaflops bieten, bieten die integrierten Trainium-Lösungen von AWS eine kostengünstige und skalierbare Alternative, die auf KI-Workloads im Unternehmensmaßstab zugeschnitten ist.

Ökosystemunterstützung: Tools für nahtlose Integration

Zur Ergänzung seiner Hardware-Innovationen bietet AWS das Neuron SDK an, ein Entwicklungs-Toolkit, das für Frameworks wie optimiert ist PyTorch und JAX.

Das SDK enthält Tools für verteiltes Training und Inferenz, sodass Entwickler Trainium-Chips ohne umfangreiche Neukonfiguration nutzen können.

AWS bietet auch vorkonfigurierte Deep Learning AMIs an, um dies sicherzustellen Entwickler können ihre KI-Anwendungen schnell bereitstellen.