Meta Platforms hat Llama 3.3 70B offiziell auf den Markt gebracht, ein neues Mitglied seiner Familie von Llama Large Language Models (LLMs), das darauf abzielt, Recheneffizienz mit hoher Leistung in Einklang zu bringen.

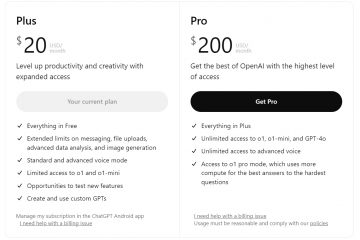

Das Modell bietet eine Funktionalität, die mit vergleichbar ist sein Vorgänger, Llama 3.1 405B, erreicht dies jedoch bei deutlich geringeren Infrastrukturkosten. Ahmad Al-Dahle, Vizepräsident für generative KI bei Meta, hob die Innovation in einem Beitrag auf X hervor.

Wir stellen Llama 3.3 vor – ein neues 70B-Modell, das die Leistung unseres 405B-Modells bietet ist aber einfacher und kosteneffizienter im Betrieb. Durch die Nutzung der neuesten Fortschritte bei Post-Training-Techniken, einschließlich Online-Präferenzoptimierung, verbessert dieses Modell die Kernleistung bei… pic.twitter.com/6oQ7b3Yuzc

– Ahmad Al-Dahle (@Ahmad_Al_Dahle) 6. Dezember 2024

Entwickelt für Aufgaben wie das Befolgen von Anweisungen und natürliche Sprache Verarbeitung und mathematisches Denken, Llama-3.3-70B-Instruct ist jetzt zum Download auf Plattformen wie Hugging Face

Allerdings Die Lizenzbedingungen erfordern eine Sondergenehmigung für Plattformen mit mehr als 700 Millionen monatlichen Nutzern, was Fragen zur Offenheit aufwirft.

Das Modell umfasst fortschrittliche Techniken wie überwachte Feinabstimmung und Reinforcement Learning from Human Feedback (RLHF). Diese Methoden verfeinern seine Fähigkeiten und machen Llama 3.3 anpassbar an verschiedene kommerzielle und Forschungsanwendungen bei gleichzeitiger Wahrung der Kosteneffizienz.

Verwandt: OpenAI führt Reinforcement Fine-Tuning Framework für die KI-Anpassung ein

Gleichgewicht zwischen Zugänglichkeit und Open-Source-Prinzipien

Meta vermarktet seine Llama-Modelle als Open Source, Kritiker argumentieren jedoch, dass eine restriktive Lizenzierung dies untergräbt beanspruchen. Die Open Source Initiative (OSI) hat kürzlich eine Open Source AI Definition (OSAID) eingeführt, um Standards zu klären, die vorschreibt, dass Modelle vollständig zugänglich und modifizierbar sein müssen. Allerdings fallen Lama-Modelle in das, was einige Experten als „offene“ Systeme bezeichnen, die Zugang zu trainierten Parametern bieten, aber kommerzielle Anwendungen einschränken.

Ali Farhadi vom Allen Institute for AI kritisierte den Ansatz. Er argumentierte so KI-Systeme sollten über den teilweisen Zugriff auf trainierte Parameter hinausgehen und stattdessen vollständige Transparenz in ihren Konstruktions-und Trainingsprozessen bieten. Diese Debatte spiegelt breitere Spannungen in der KI-Branche hinsichtlich der Balance zwischen Innovation und Zugänglichkeit wider.

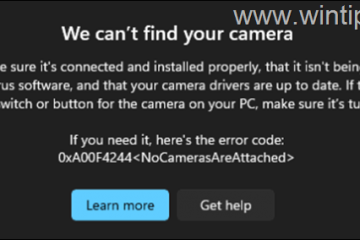

Skalierung der Infrastruktur für Lama 4

Während bei Llama 3.3 die Effizienz im Vordergrund steht, bereitet Meta eine drastische Skalierung seiner Infrastruktur für das kommende Llama 4 vor. Während der Telefonkonferenz zu Metas Ergebnissen für das dritte Quartal gab CEO Mark Zuckerberg bekannt, dass das Unternehmen Llama 4 trainiert ein Cluster von über 100.000 Nvidia H100-GPUs. Dies stellt einen deutlichen Sprung gegenüber den 25.000 GPUs dar, die für Llama 3 verwendet wurden Metas Ziel, an der Spitze der generativen KI-Entwicklung zu bleiben.

Der Energieverbrauch des GPU-Clusters ist bemerkenswert und wird auf 150 Megawatt geschätzt – das Fünffache der Energie, die für El Capitan, den größten Supercomputer in den Vereinigten Staaten, benötigt wird. Trotz Bedenken hinsichtlich der ökologischen Nachhaltigkeit betonte Zuckerberg die Notwendigkeit solcher Investitionen und erklärte, dass Llama 4 die zehnfache Rechenleistung seines Vorgängers erfordern würde.

Verwandt: Meta verwendet OpenAIs GPT-4 als eigene Llama-KI-Modelle sind nicht gut genug

Der enorme Umfang der Infrastruktur von Llama 4 unterstreicht den dualen Ansatz von Meta: die Schaffung hocheffizienter Modelle für verschiedene Anwendungsfälle bei gleichzeitiger erheblicher Investition in groß angelegte generative Modelle KI-Systeme.

Meta ist jedoch nicht allein und baut seine KI-Trainingsinfrastruktur stark aus. Elon Musks xAI verdoppelt derzeit die Kapazität von Colossus, seinem in Memphis ansässigen Supercomputer, auf über 1 Million Nvidia-GPUs. Und Amazon hat kürzlich seine Pläne für seinen Ultracluster bekannt gegeben, der auf den maßgeschneiderten Chips von Amazon basiert und einer der bislang leistungsstärksten KI-Supercomputer der Welt werden soll

Kompakte Modelle treiben Metas Edge-KI-Erweiterung voran

Im Oktober erweiterte Meta seine Llama 3.2-Serie um quantisierte Modelle, die für Edge Computing und mobile Geräte optimiert sind. Die kleineren 1B-und 3B-Parametermodelle wurden dank Technologien wie Quantization-Aware Training ( QAT) und Low-Rank-Adapter (LoRA).

Diese Methoden reduzieren den Speicherbedarf der Modelle um über 40 % und beschleunigen die Verarbeitungsgeschwindigkeit um das bis zu Vierfache.

Metas Partnerschaften mit Qualcomm und MediaTek Bringen Sie diese Funktionen auf Android-Geräte und demonstrieren Sie ihre praktischen Anwendungen. Tests auf Geräten wie dem OnePlus 12 ergaben Latenzverbesserungen und einen geringeren Energieverbrauch, was der wachsenden Nachfrage der Branche nach datenschutzbewussten KI-Lösungen auf dem Gerät entspricht.

Quantisierung, ein Prozess, der die Präzision von Gewichtungen und Aktivierungen verringert in KI-Modellen ermöglicht eine effiziente Bereitstellung auf Geräten mit geringem Stromverbrauch ohne Qualitätseinbußen. Meta führte außerdem SpinQuant ein, eine sekundäre Quantisierungsmethode, die den Einsatz optimiert, ohne dass umfangreiche Trainingsdaten erforderlich sind.

Metas duale Strategie für KI-Führung

Die gleichzeitige Veröffentlichung von Llama 3.3 und die Vorbereitung für Llama 4 spiegeln die doppelte Strategie von Meta wider, die Skalierbarkeit zu verbessern und gleichzeitig mobile und Edge-Anwendungsfälle zu berücksichtigen. Durch die Investition sowohl in riesige GPU-Cluster als auch in kompakte, effiziente Modelle positioniert sich Meta als führend im Bereich der generativen KI-Innovation.

Allerdings gibt es Herausforderungen wie behördliche Kontrolle, Umweltbedenken und Debatten über Open-Source-Prinzipien weiterhin die Entwicklung des Unternehmens prägen.