Apple beschleunigt seine Ambitionen im Bereich der künstlichen Intelligenz (KI), indem es die Trainium2-Chips von AWS in seine KI-Vortrainingsprozesse integriert.

Während der AWS re:Invent-Konferenz am 4. Dezember sprach Benoit Dupin, Senior Director of Machine bei Apple Lernen und KI, diskutiert die ersten Bewertungen des Unternehmens zur AWS-Hardware. „In den frühen Stadien der Evaluierung von Trainium2 rechnen wir mit einer Effizienzsteigerung von bis zu 50 % durch das Vortraining“, sagte Dupin dem Publikum bei einem kurzen Auftritt auf der Bühne.

Die Partnerschaft unterstreicht die Vertiefung der Beziehung zwischen Apple und AWS, wobei der Technologieriese auf Trainium2-basierte UltraServer setzt, um seine KI-Operationen zu skalieren und gleichzeitig Effizienz und Kosten zu optimieren.

Apple und AWS sind langfristig Partner

Apples Nutzung der AWS-Infrastruktur ist nicht neu. Das Unternehmen nutzt seit über einem Jahrzehnt AWS-Chips wie Graviton und Inferentia, um wichtige Produkte zu unterstützen Dienste, darunter Siri, Apple Maps und Apple Music.

Die Fähigkeit von AWS, umfangreiche KI-Workloads zu unterstützen, hat es zu einem wichtigen Partner für Apple gemacht. Wie Dupin es ausdrückte: „Wir haben eine starke Beziehung, und Die Infrastruktur ist sowohl zuverlässig als auch in der Lage, unsere Kunden weltweit zu bedienen.“

Die Aufnahme von Trainium2 in das KI-Toolkit von Apple spiegelt das Engagement beider Unternehmen wider, die Grenzen der KI-Effizienz und Skalierbarkeit zu verschieben.

Trainium2-Chips und UltraServer: Erfüllung der Anforderungen moderner KI

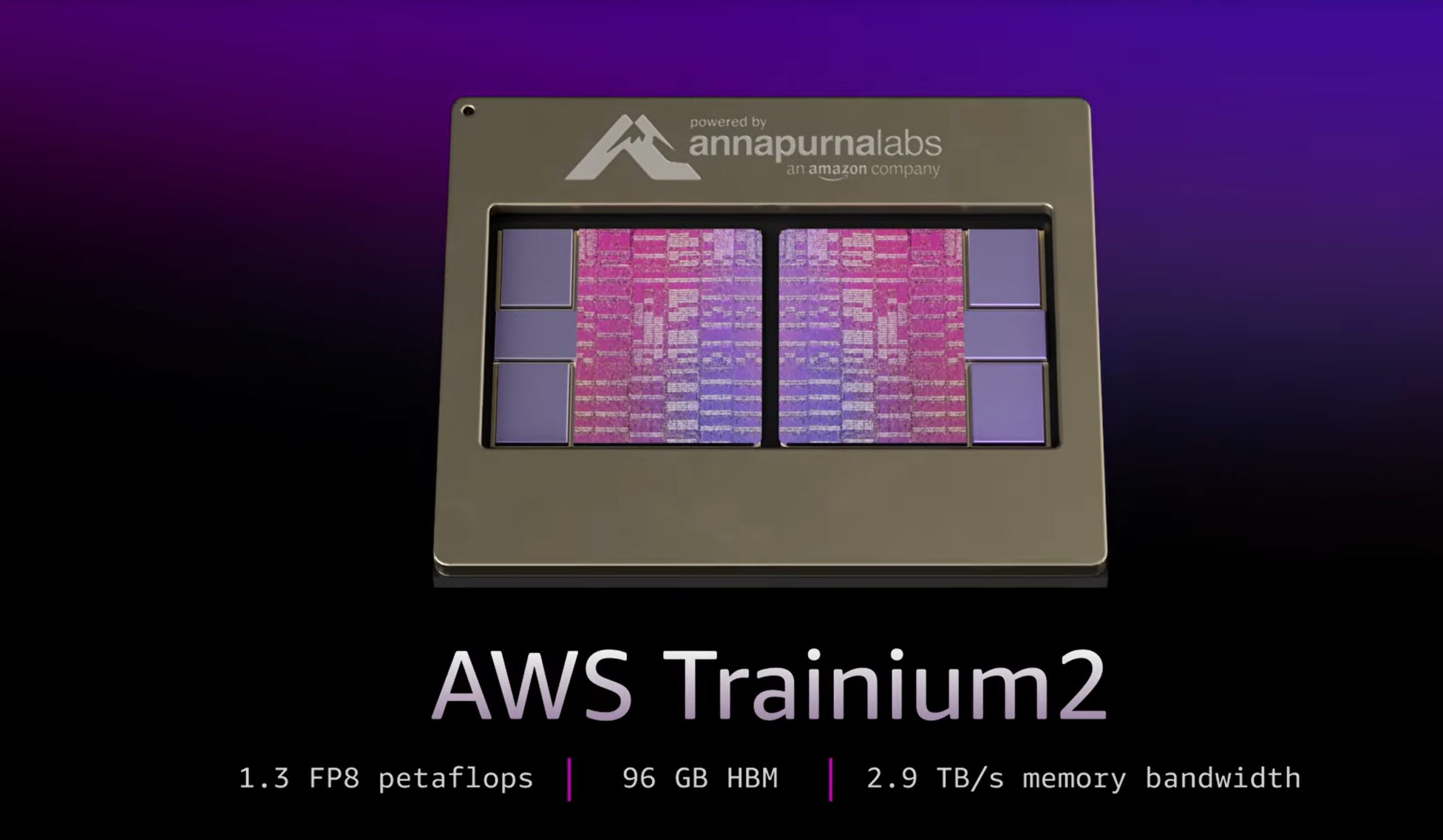

AWS hat gestern seine Trainium2-Chips und Trn2 UltraServer auf den Markt gebracht und damit einen wichtigen Meilenstein in der KI-Hardwareentwicklung markiert. Trainium2-Chips liefern bis zu 20,8 Petaflops dichter FP8-Rechenleistung pro Instanz und sind für die Bewältigung der steigenden Rechenanforderungen von KI-Modellen mit Billionen Parametern ausgelegt.

Die Trn2 UltraServer mit 64 Trainium2-Chips erreichen bis zu 83,2 Petaflops von spärlicher FP8-Leistung. Möglich wird dies durch die proprietäre NeuronLink-Verbindung von AWS, die eine Kommunikation mit geringer Latenz und hoher Bandbreite über verteilte Systeme hinweg gewährleistet.

David Brown, AWS-Vizepräsident für Compute and Networking, betonte das transformative Potenzial von Trainium2: „ Trainium2 ist der bisher leistungsstärkste AWS-Chip. Und da Modelle Billionen von Parametern umfassen, wussten wir, dass Kunden einen neuartigen Ansatz benötigen würden, um diese riesigen Modelle zu trainieren und auszuführen.“

AWS demonstrierte die Fähigkeiten von Trainium2 durch den Einsatz des Llama 405B-Modells von Meta und erreichte eine dreimal höhere Token-Generierung Durchsatz als konkurrierende Angebote anderer Cloud-Anbieter. Dieser Durchbruch erfüllt einen wichtigen Bedarf an schnellerer Textgenerierung, Zusammenfassung und Echtzeitinferenz.

Apple Intelligence und die Multi-Cloud Ansatz

Apples KI-Strategie dreht sich um seine generative KI-Plattform Apple Intelligence, die Funktionen wie die Verarbeitung natürlicher Sprache in Siri, erweiterte Benachrichtigungszusammenfassungen und kreative Tools wie die Emoji-Generierung unterstützt.

Apple Intelligence arbeitet nach einem Hybridmodell und nutzt geräteinterne Berechnungen über seine M-Serie-Chips für Datenschutz und Effizienz, während es sich für komplexe Arbeitslasten auf eine Cloud-Infrastruktur verlässt.

Dieser Multi-Cloud-Ansatz umfasst beides AWS und Google Cloud. Anfang des Jahres bestätigte Apple die Verwendung von Google-TPU-Chips für Trainingskomponenten von Apple Intelligence. Diese diversifizierte Strategie ermöglicht es Apple, spezifische Arbeitslasten basierend auf den Stärken jeder Plattform zu optimieren.

Mit Trainium2 bietet AWS eine kostengünstige Alternative zu Nvidia-GPUs, die es Apple ermöglicht, seine KI-Operationen ohne Leistungseinbußen zu skalieren.

Verwandt: Die KI-Überarbeitung von Apple Siri verschiebt sich auf 2026, da Googles Gemini die Führung übernimmt

Projekt Rainier: AWS Zusammenarbeit mit Anthropic

Zu den umfassenderen KI-Ambitionen von AWS gehört das Project Rainier, eine Partnerschaft mit Anthropic zur Entwicklung eines der weltweit größten KI-Rechencluster. Mit Tausenden von Trainium2-Chips soll Project Rainier eine beispiellose Skalierbarkeit für generative KI bieten.

Anthropic, das Unternehmen hinter dem Sprachmodell Claude 3.5 Sonnet, plant, den Cluster zu nutzen, um sein Modelltraining zu verfünffachen. Die Investition von AWS in Anthropic, die sich nun auf insgesamt 8 Milliarden US-Dollar beläuft, unterstreicht sein Engagement für die Förderung von Innovationen in der KI-Infrastruktur.

Durch die Unterstützung sowohl von Apple als auch von Anthropic demonstriert AWS seine Fähigkeit, verschiedene KI-Arbeitslasten zu bewältigen, von der Vorschulung bis zur realen-Zeitinferenz.

AWS Trainium3 und die Zukunft der KI-Hardware

AWS blickt bereits auf seinen Chip der nächsten Generation, Trainium3 soll Ende 2025 auf den Markt kommen. Trainium3 basiert auf einem Drei-Nanometer-Prozess und verspricht eine vierfache Leistungssteigerung gegenüber Trainium2. Diese Entwicklung wird noch größere KI-Modelle und schnellere Trainingszeiten ermöglichen und damit die Position von AWS als führender Anbieter von KI-Hardware stärken.

Der Ultracluster, ein auf Trainium3 basierender Supercomputer, wird die Fähigkeiten von AWS weiter verbessern. AWS beschreibt es als den weltweit größten KI-Rechencluster, der in der Lage ist, Billionen-Parameter-Modelle mit unübertroffener Effizienz zu verarbeiten.

Diese Fortschritte spiegeln die strategische Vision von AWS wider, die Dominanz von Nvidia auf dem KI-Hardwaremarkt herauszufordern und Unternehmen wie Apple und Anthropische, kosteneffiziente, skalierbare Lösungen, die auf ihre Bedürfnisse zugeschnitten sind.

Der Branchenwandel hin zu kundenspezifischem Silizium

Apples Einführung von AWS Trainium2-Chips sind Teil eines breiteren Branchentrends hin zu maßgeschneidertem Silizium für KI-Workloads. Unternehmen weichen zunehmend von traditionellen GPU-basierten Lösungen ab und setzen auf Hardware, die speziell für KI-Anwendungen entwickelt wurde.

Der integrierte Ansatz von AWS, der Hardware wie Trainium2 mit Tools wie dem Neuron SDK kombiniert, positioniert es als praktikable Alternative zu Nvidia. Durch Investitionen in kundenspezifische Chips treiben Apple und AWS Innovationen in der KI-Infrastruktur voran und ebnen den Weg für effizientere und skalierbarere Lösungen.