SambaNova Systems, ein wichtiger Akteur im Bereich unternehmensorientierter generativer KI, hat einen neuen Leistungsmaßstab gesetzt und einen Durchsatz von 1.000 Token pro Sekunde erreicht unter Verwendung des Parameteranweisungsmodells Llama 3 8B. Diese vom unabhängigen Testunternehmen Artificial Analysis bestätigte Leistung übertrifft den bisherigen Rekord von Groq mit 800 Token pro Sekunde. Der Meilenstein stellt einen bedeutenden Fortschritt in den Fähigkeiten generativer KI-Systeme dar.

Unternehmensanwendungen und Implikationen

Die Erhöhung der Verarbeitungsgeschwindigkeit hat weitreichende Auswirkungen auf verschiedene Unternehmensanwendungen. Zu den Vorteilen zählen schnellere Reaktionszeiten, eine verbesserte Hardwareauslastung und geringere Betriebskosten. Diese Beschleunigung ist besonders vorteilhaft für Anwendungen, die eine geringe Latenz und einen hohen Durchsatz erfordern, wie z. B. KI-Agenten, Verbraucher-KI-Anwendungen und die Interpretation großer Dokumentmengen. George Cameron, Mitbegründer von Artificial Analysis, erzählt VentureBeat stellt das wachsende Tempo des Wettlaufs um KI-Chips dar und hebt die wachsenden Hardwareoptionen hervor, die KI-Entwicklern zur Verfügung stehen. Sein Unternehmen legt Wert auf die reale Leistung dieser Systeme und bringt neue Spannung in geschwindigkeitsabhängige Anwendungsfälle.

🚀 SambaNova hat NVIDIA in einem neuen Geschwindigkeitstest von Artificial Analysis übertroffen. 🚀

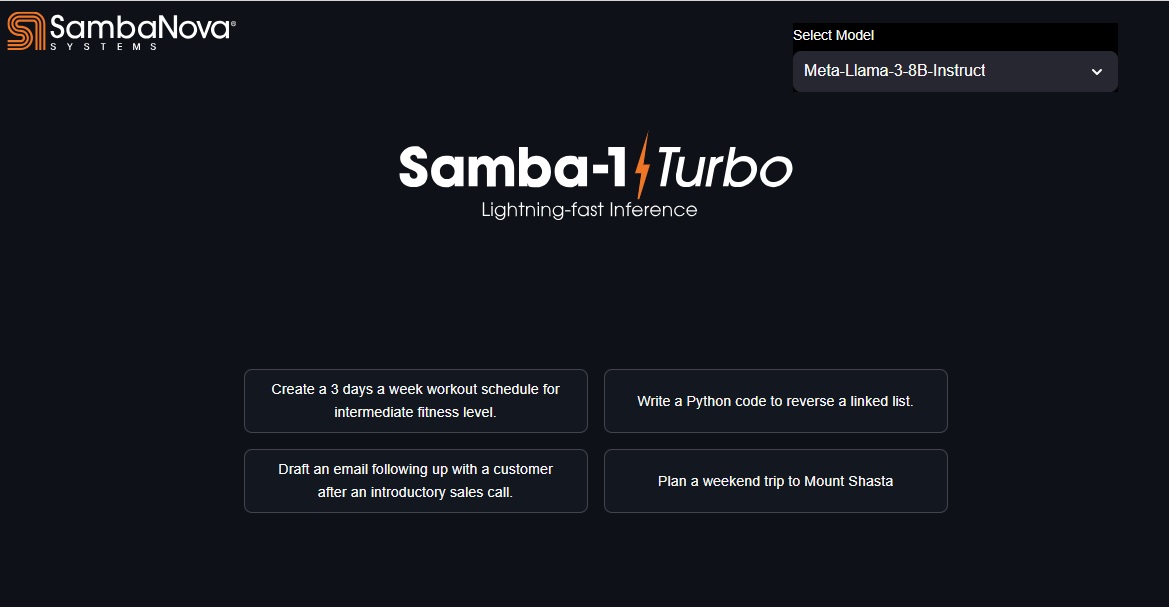

Samba-1 Turbo leistet eine hervorragende Leistung schnell mit 1000 t/s, ein Weltrekord: https://t.co/PmDHWrFGCH.#AI # GenAI #EnterpriseAI #LLM #NLP #AIAreAll #GPUAlternative #EnterpriseScaleAI #AIChips #ChipRace pic.twitter.com/TMtUqyZWpy

– SambaNova Systems (@ SambaNovaAI) 29. Mai 2024

Technologische Fortschritte hinter der Leistung

Im Mittelpunkt des Erfolgs von SambaNova steht die RDU-Technologie (Reconfigurable Dataflow Unit), die es von herkömmlichen KI-Beschleunigern wie den GPUs von Nvidia unterscheidet. RDUs sind spezielle KI-Chips, die sowohl die Trainings-als auch die Inferenzphase der KI-Modellentwicklung unterstützen sollen. Sie zeichnen sich durch die Bewältigung der Workload-Anforderungen von Unternehmen aus, einschließlich der Feinabstimmung von Modellen. Der Software-Stack von SambaNova spielt eine entscheidende Rolle bei der Optimierung der RDU für Leistungssteigerungen und ermöglicht eine iterative Optimierung der Ressourcenzuweisung über verschiedene neuronale Netzwerkschichten hinweg, was zu erheblichen Verbesserungen sowohl der Effizienz als auch der Geschwindigkeit führt.

Die Einführung von Samba-1-Turbo, angetrieben durch den SN40L-Chip, war maßgeblich an der Erreichung dieses Weltrekords beteiligt. Der Samba-1-Turbo verarbeitet 1.000 Token pro Sekunde mit 16-Bit-Präzision und führt das erweiterte Llama-3 Instruct (8B)-Modell aus. Im Gegensatz zu herkömmlichen GPUs, die häufig unter einer begrenzten On-Chip-Speicherkapazität und häufigen Datenübertragungen leiden, verfügt die RDU von SambaNova über einen riesigen Pool an verteiltem On-Chip-Speicher durch ihre Pattern Memory Units (PMUs). Diese PMUs sind in der Nähe der Recheneinheiten positioniert, wodurch die Datenbewegung minimiert und die Effizienz gesteigert wird.

Optimierung der Ausführung neuronaler Netzwerke

Herkömmliche GPUs führen neuronale Netzwerkmodelle in einem aus Kernel-für-Kernel-Methode, die die Latenz erhöht und Recheneinheiten nicht ausreichend auslastet. Im Gegensatz dazu bildet der SambaFlow-Compiler das gesamte neuronale Netzwerkmodell als Datenflussdiagramm auf der RDU-Fabric ab, was eine Pipeline-Datenflussausführung ermöglicht und die Leistung steigert. Die Handhabung großer Modelle auf GPUs erfordert oft eine komplexe Modellparallelität und erfordert spezielle Frameworks und Code. Die RDU-Architektur von SambaNova automatisiert die Daten-und Modellparallelität bei der Zuordnung mehrerer RDUs in einem System, vereinfacht den Prozess und sorgt für optimale Leistung.