Google hat Gemini 2.0 und Gemini 2.0 Flash als das neueste Angebot seiner sich schnell entwickelnden Gemini-Familie für künstliche Intelligenz vorgestellt.

Gemini 2.0 läutet das ein, was die Unternehmensführung das „agentische Zeitalter“ der künstlichen Intelligenz nennt, einen Moment, in dem KI nicht mehr existiert versteht Informationen einfach, kann dieses Verständnis jedoch nutzen, um vorauszuplanen und Maßnahmen zu ergreifen.

Diese Entwicklung baut auf jahrzehntelanger Arbeit bei der Organisation der weltweiten Informationen auf. Sie folgt auch einer Entwicklung, die mit Gemini 1.0 und 1.5 begann, die Pionierarbeit leisteten Multimodalität, sodass KI-Modelle mit Text, Video, Bildern, Audio und Code arbeiten können.

Mit Gemini 2.0 will Google über statische Frage-und-Antwort-Funktionen hinausgehen und Systeme bereitstellen, die in der Lage sind, durch komplexe Szenarien zu navigieren und zu interagieren mit mehreren Tools und autonomeres Arbeiten im Namen der Benutzer unter menschlicher Aufsicht.

Sundar Pichai, CEO von Google und Alphabet, begründete diesen Fortschritt mit der langfristigen Mission des Unternehmens. Er erklärte, dass sich Google seit seiner Gründung darauf konzentriert habe, Informationen zugänglich und nützlich zu machen, und dass KI nun als wichtiger Treiber bei der Verwirklichung dieser Vision fungiere.

„Wenn es bei Gemini 1.0 darum ging, Informationen zu organisieren und zu verstehen, dann ist es bei Gemini 2.0 so.“ geht es darum, es viel nützlicher zu machen. „Ich kann es kaum erwarten zu sehen, was diese nächste Ära bringt“, sagte Pichai. Diese neue Version erscheint nach Monaten des Entwickler-Feedbacks zu früheren Gemini-Modellen und der Integration dieser Modelle in sieben Google-Produkte, die jeweils von über 2 Milliarden Menschen verwendet werden.

Millionen von Entwicklern haben seit letztem Dezember mit Gemini zusammengearbeitet. Das Unternehmen betrachtet Gemini 2.0 als einen großen Fortschritt, der neue agentenbasierte Erfahrungen und umfassendere Produkttransformationen ermöglicht.

Inhaltsverzeichnis:

Das Erreichen der Agenten-Ära

Der Übergang von Gemini 1.0 und 1.5 zu Gemini 2.0 spiegelt den Fokus darauf wider, KI aktiver hilfreich zu machen. Frühere Versionen führten native Multimodalität und einen längeren Kontext ein. Dadurch kann das Modell eine Vielzahl von Eingaben interpretieren.

In der offiziellen Ankündigung heißt es: „Seit dem letzten Dezember, als wir Gemini 1.0 auf den Markt brachten, haben Millionen von Entwicklern Google AI verwendet Studio und Vertex AI bauen mit Gemini in 109 Sprachen auf“, was die breite Attraktivität der Plattform unterstreicht.

Diese Erfahrungen flossen in die Entwicklung von Gemini 2.0 ein, einem Modell, das nicht nur Informationen schneller verarbeitet, sondern auch versteht, was zu tun ist Als nächstes erfahren Sie, wie Sie externe Tools einsetzen und über passives Denken hinausgehen.

[eingebetteter Inhalt]

Fortschritte mit Gemini 2.0 Flash und Deep Forschung

Im Mittelpunkt der Fähigkeiten von Gemini 2.0 steht Gemini 2.0 Flash, ein experimentelles Modell, das die Leistung und Geschwindigkeit von 1.5 Pro verbessert und gleichzeitig multimodale Ausgaben und native Tool-Nutzung liefert.

Es ist Das flexible Design ermöglicht die Generierung von mit Text gemischten Bildern, die Produktion von mehrsprachigem Text-to-Speech-Audio und den nativen Aufruf von Ressourcen wie der Google-Suche, Codeausführung und APIs von Drittanbietern.

„Gemini 2.0 Flash ist nativ Aktionsfunktionen der Benutzeroberfläche sowie andere Verbesserungen wie multimodales Denken, langes Kontextverständnis, Befolgen und Planen komplexer Anweisungen, Aufruf kompositorischer Funktionen, Verwendung nativer Tools und verbesserte Latenz arbeiten alle zusammen, um eine neue Klasse von Agenten zu ermöglichen Erfahrungen“, sagte Google über das Update.

[eingebetteter Inhalt]

Gemini 2.0 Flash Benchmarks

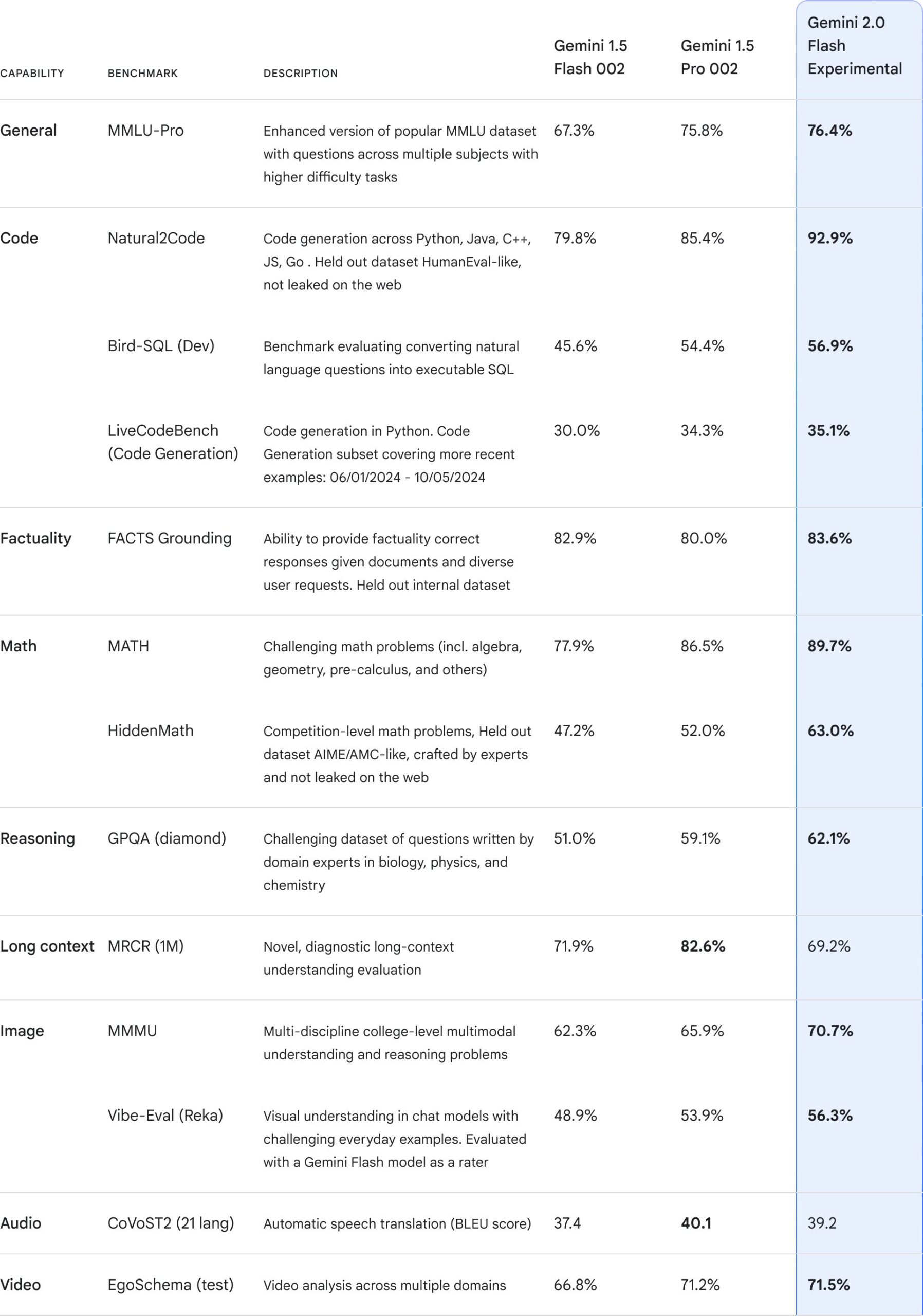

In Benchmark-Ergebnissen angezeigt von Google, Gemini 2.0 Flash Experimental, zeigt im Vergleich zu seinen Vorgängern Gemini 1.5 Flash O02 und Gemini 1.5 Pro O02 insgesamt eine verbesserte Leistung in einer Reihe anspruchsvoller Benchmarks.

Insbesondere ist es erheblich Zuwächse bei codebezogenen Aufgaben wie Natural2Code, wo es 92,9 % gegenüber 85,4 % bei 1.5 Pro und 79,8 % bei 1.5 Flash erreicht, sowie bei schwierigen Mathematik-und Argumentations-Benchmarks, einschließlich HiddenMath, wo es eine Punktzahl von 63,0 % erreicht und damit besser abschneidet 1.5 Pro mit 52,0 %.

Auch im Multimodal übertrifft er seine Vorgänger Verständnis, bessere Ergebnisse bei Bild-und Videotests und Aufrechterhaltung eines starken Vorsprungs in Allgemeinwissen (MMLU-Pro) und Begründungsaufgaben (GPQA).

Obwohl da Es gibt ein paar Bereiche, in denen es sich nicht kontinuierlich verbessert – etwa der lange Kontext MRCR (1M)-Bewertung, wo es hinter den 82,6 % von 1.5 Pro zurückbleibt – die Daten zeigen, dass Gemini 2.0 Flash Experimental im Allgemeinen das stärkste Modell ist und bedeutende Fortschritte bei der Codegenerierung, der komplexen Argumentation und dem multimodalen Verständnis zeigt.

Das neue Multimodale Live-API unterstützt Audio und Video in Echtzeit Streaming-Eingaben, die es Entwicklern ermöglichen, dynamische, kontextbewusste Anwendungen zu erstellen, die fließend auf sich entwickelnde Szenarien reagieren.

Die Fähigkeiten von Gemini 2.0 fließen auch in neue Funktionen ein, die Benutzern die Navigation und Synthese komplexer Informationen erleichtern sollen.

Eine dieser Funktionen ist Deep Research, die jetzt in Gemini Advanced verfügbar ist. Deep Research nutzt das umfassende Kontextverständnis und die Argumentation des Modells, um als Forschungsassistent zu fungieren und komplexe Themen zu erforschen Themen und das Zusammenstellen von Berichten.

Anstatt von Benutzern zu erwarten, dass sie unterschiedliche Quellen durchsuchen, zielt Gemini 2.0 darauf ab, den Prozess zu vereinfachen, indem es als proaktiver Partner fungiert, der sammelt, organisiert und liefert Erkenntnisse auf zusammenhängende Weise.

Transformation der Google-Suche mit verbesserter Argumentation

Der Einfluss von Gemini 2.0 erstreckt sich auf die Kernprodukte von Google, insbesondere auf die Google-Suche. Pichai betonte, wie die KI-Übersichten des Unternehmens eine Milliarde Nutzer erreicht haben, wodurch Menschen völlig neue Arten von Fragen stellen können und dies zu einer der beliebtesten Funktionen in der Suche wird.

„Kein Produkt hat sich mehr verändert.“ KI statt Suche. Unsere KI-Übersichten erreichen jetzt 1 Milliarde Menschen und ermöglichen es ihnen, völlig neue Arten von Fragen zu stellen – was sich schnell zu einer unserer beliebtesten Suchfunktionen überhaupt entwickelt“, sagte er.

Mit den erweiterten Argumentationsfunktionen von Gemini 2.0 KI-Übersichten können jetzt komplexere Themen angehen, mehrstufige mathematische Probleme lösen, multimodale Abfragen bearbeiten und sogar codierungsbezogene Anfragen bearbeiten. Die eingeschränkten Tests dieser erweiterten KI-Übersichten haben begonnen, eine breitere Verfügbarkeit ist für Anfang nächsten Jahres geplant.

Deep Dive: Wie das neue o1-Modell von OpenAI Menschen strategisch täuscht

Leistung mit Trillium-TPUs skalieren

Hinter Gemini 2.0 Die erweiterten Fähigkeiten basieren auf einem Jahrzehnt an Forschungs-und Entwicklungsinvestitionen. Das Modell basiert vollständig auf Trillium, den TPUs der sechsten Generation, die Kunden jetzt für ihre eigenen Projekte zur Verfügung stehen.

Durch die Beibehaltung eines Full-Stack-Ansatzes kann Google Hardware und Software optimal aufeinander abstimmen und so sicherstellen, dass Leistungssteigerungen und schnelle Experimente schnell zu praktischen Verbesserungen führen.

Dieser integrierte Ansatz bedeutet, dass Entwickler von stabilen, skalierbare Infrastruktur, die die neue Ära der Agentenmodelle unterstützt und es ihnen ermöglicht, sich auf die Entwicklung hochwertiger Funktionen und Anwendungen zu konzentrieren, anstatt sich mit der Verwaltung geringer technischer Komplexität zu befassen.

Verwandt: Neues IBM Glasfasermodul kann KI beschleunigen Modellschulung um 300 %

Project Astra: Ein universeller Assistent im Entstehen

Einer der Forschungsprototypen, der die Ambitionen von Gemini 2.0 veranschaulicht, ist Project Astra. vorgestellt auf der Google I/O 2024 und integriert jetzt Gemini 2.0.

Astra soll als universeller Assistent fungieren, der mehrere Sprachen und Akzente versteht, sich Benutzerpräferenzen merkt und Google anruft Suche, Linse und Karten, um kontextrelevante Antworten bereitzustellen.

[eingebetteter Inhalt]

Es kann bis zu 10 Minuten Sitzungsspeicher verarbeiten und ermöglicht so personalisiertere und kontinuierlichere Interaktionen. Vertrauenswürdige Tester haben Astra auf Android-Telefonen verwendet, um Verbesserungen zu steuern, und Google plant, seine Funktionen auf weitere Geräte zu übertragen, einschließlich Prototyp-Brillen.

Durch die Verbindung von multimodalem Verständnis, Tool-Nutzung und Antworten mit geringer Latenz bietet Astra veranschaulicht, wie die Agentenfunktionen von Gemini 2.0 zukünftige KI-Assistenten prägen können, die sich in Echtzeit an Benutzerbedürfnisse und-präferenzen anpassen.

Verwandt: Siris KI-Phantom-Tischbuchungen schaffen A Mess

Project Mariner: Navigieren im Web mit einem Agentenmodell

Gemini 2.0 unterstützt auch Project Mariner, ein früher Forschungsprototyp, der damit experimentiert, wie KI-Agenten direkt in einem Browser funktionieren könnten. Mariner kann die Pixel und Elemente auf einer Webseite verstehen – etwa Text, Code, Bilder und Formulare – und dieses Verständnis nutzen, um Aufgaben zu erledigen.

[eingebetteter Inhalt]

Das ist möglich Daten abrufen, Websites durchsuchen, Formulare ausfüllen und sogar Einkaufswagen zusammenstellen, allerdings ist vor Abschluss des Kaufs eine Benutzerbestätigung erforderlich. Während Mariner noch früh und manchmal langsam bei der Erledigung von Aufgaben ist, schlägt er eine Zukunft vor, in der Agenten Online-Besorgungen und komplexe Arbeitsabläufe erledigen können.

Diese Möglichkeit ist ein konkreter Beweis dafür, wie die Planungs-und Argumentationsfähigkeiten von Gemini 2.0 erweitert werden könnten über Konversation hinaus und in Navigationsunterstützung, Datenextraktion und automatisierte Forschung.

Verwandt: Pariser Startup stellt AI Agent Runner H vor, um OpenAI, Anthropic, Google und Microsoft herauszufordern

Jules: Automatisierung der Softwarewartung für Entwickler

Die Agentenfunktionen erstrecken sich über Jules, einen KI-gestützten Codierungsagenten, der sich direkt in GitHub-Workflows integriert, auf die Softwareentwicklung. Jules kann Entwickleranweisungen interpretieren, Probleme angehen, Korrekturen planen und ausführen und dann auf die menschliche Überprüfung warten, bevor er Änderungen wieder in die Hauptcodebasis einfügt.

Kathy Korevec, Leiterin des Produktmanagements bei Google Labs, beschrieb den Nutzen von Jules: „Es ist sehr gut bei Fehlerbehebungen, kleinen Features und solchen Dingen, man kann es sich fast wie einen Junior-Ingenieur vorstellen, der dort die Leitung übernimmt.“

Sie fügte hinzu: „Das habe ich nicht Werden Sie Softwareentwickler Weil ich jeden Tag davon träume, Fehler zu beheben, war das nicht mein Ziel. Ich möchte wirklich coole, kreative Apps erstellen. Das Schöne an Jules ist, dass ich sagen kann: „Hey, behebe diese Fehler für mich.“ Dieser Ansatz kann Befreien Sie menschliche Entwickler von mühsamer Wartungsarbeit und ermöglichen Sie ihnen, sich auf Kreativität, Innovation und anspruchsvollere Probleme zu konzentrieren.

Verwandt: Cognition.ai bringt seinen Devin AI Software Engineer für 500 US-Dollar auf den Markt/Monat

Agenten im Gaming und in der physischen Welt

Die Tradition von Google DeepMind, KI mit Spielen zu trainieren, wird unter Gemini 2.0 fortgesetzt. Spielumgebungen bieten Modellen eine kontrollierte Bühne zum Erlernen von Planung, Logik und dem Befolgen von Regeln.

Auf Gemini 2.0 basierende Agenten können durch virtuelle Welten navigieren, Anweisungen interpretieren und Vorschläge in Echtzeit machen, was das Gameplay möglicherweise verbessert und erweitert die Horizonte der Spielererfahrungen.

Zusammenarbeit mit Entwicklern wie Supercell hilft bei der Bewertung, wie diese Agenten wirken verhalten sich quer verschiedene Genres, von Strategiespielen wie „Clash of Clans“ bis hin zu Landwirtschaftssimulatoren wie „Hay Day“.

Verwandt: Studie: Minecraft-KI-Charaktere zeigen menschenähnliche kulturelle Dynamik

Da diese Agenten über die Google-Suche auch auf externes Wissen zugreifen können, könnten sie eine Brücke zwischen spielspezifischen Umgebungen und dem breiteren Web schlagen und den Spielern zeitnahe Einblicke und Anleitung bieten.

Experimente erstrecken sich auch auf die Robotik, wo Zwillinge Die räumlichen Denkfähigkeiten von 2.0 könnten eines Tages Agenten in die Lage versetzen, in der physischen Welt zu helfen.

Obwohl noch früh und experimentell, weist das Versprechen einer KI-gesteuerten Unterstützung in greifbaren Umgebungen auf einen Weg hin zu Systemen hin, die sicher interagieren können und hilfreich außerhalb virtueller Umgebungen, möglicherweise bei der Unterstützung realer Aufgaben und Dienste.

[eingebetteter Inhalt]

Verantwortungsvoll bauen und Risiken mindern

Mit zunehmender Breite und Leistungsfähigkeit der Agentenmodelle von Gemini 2.0 wächst auch der Schwerpunkt von Google auf Verantwortung, Sicherheit und Ethik. Das Unternehmen stellt fest, dass diese neuen Technologien neue Fragen zu Sicherheit, Schutz und Verhalten aufwerfen.

Eine interne Verantwortung Während der gesamten Entwicklung werden das Sicherheitskomitee (RSC) und KI-gestützte Red-Teaming-Ansätze angewendet, um Risiken zu identifizieren und zu mindern. Die Komplexität multimodaler Ergebnisse erfordert fortlaufende Sicherheitsbewertungen und Schulungen.

Verwandt: EU-Ökonomen sehen KI als „Marktversagen“; fordern Meilensteinmodell für öffentliche Fonds

Mit Mit Project Astra arbeitet Google daran, den Verlust sensibler Informationen zu verhindern, und stellt mit Project Mariner sicher, dass der Agent Benutzeranweisungen gegenüber böswilligen Eingabeaufforderungsinjektionen respektiert, die in externen Quellen verborgen sind.

Ziel ist es, den menschlichen Benutzer zu behalten die Kontrolle behalten und sie gleichzeitig davor schützen Durch die kontinuierliche Verbesserung von Prozessen, die Konsultation externer Experten und die Durchführung strenger Tests möchte Google ein ausgewogenes Verhältnis zwischen Innovation und Schutz des Benutzervertrauens finden.

Auf dem Weg zu AGI und darüber hinaus

Gemini 2.0 ist ein Meilenstein auf dem Weg zu einer allgemeineren, adaptiven KI – ein Anspruch, der manchmal mit dem Konzept der künstlichen allgemeinen Intelligenz (AGI) in Verbindung gebracht wird.

Obwohl sich Gemini 2.0 und seine Forschungsprototypen noch in der Erkundungsphase befinden, weisen die von Gemini 2.0 und seinen Forschungsprototypen demonstrierten Fähigkeiten auf eine Zukunft hin, in der KI-Agenten immer komplexere Aufgaben bewältigen, sich nahtlos in das tägliche Leben integrieren und Benutzern ermöglichen können, mehr zu erreichen.

Mit jeder Iteration verfeinert Google die Synergie zwischen reiner Rechenfähigkeit, multimodalem Verständnis und Agentenverhalten und legt damit den Grundstein für die kontinuierliche Weiterentwicklung der Art und Weise, wie Menschen mit Maschinen interagieren.

In diesem Sinne Zwillinge 2.0 ist nicht nur eine weitere Modellversion, sondern ein bedeutender Schritt bei der Neugestaltung der Art und Weise, wie Informationen verarbeitet werden, wie Aufgaben erledigt werden und wie KI als vertrauenswürdiger Partner dienen kann.

Von der Verbesserung der Sucherlebnisse für eine Milliarde Benutzer bis hin zu Die heute eingeführten Funktionen ermöglichen eine autonomere Forschung, Entwicklung und Navigation und deuten darauf hin, dass das Agentenzeitalter wirklich neu begonnen hat.