Klick Labs, die Forschungsabteilung von Klick Health mit Sitz in Toronto, hat eine neuartige Methode zur Unterscheidung zwischen menschlichen und KI-generierten Audioclips eingeführt. Diese Entwicklung erfolgt inmitten eines Anstiegs von Deepfake-Inhalten, zu denen KI-produzierte Videos, Audioinhalte und Bilder gehören, die echte Personen nachahmen.

Die Verbreitung von Deepfakes wurde durch das Aufkommen fortschrittlicher KI-Chatbots beschleunigt. hochwertige Sprachgeneratoren und Replikatoren, wie sie von Elevenlabs und Truecaller angeboten werden. Hochkarätige Persönlichkeiten wie Taylor Swift, Präsident Joe Biden und der Papst waren allesamt Ziel dieser raffinierten Fälschungen. Europol hat prognostiziert, dass bis zum Jahr 2026 bis zu 90 % der Online-Inhalte synthetisch generiert werden könnten , eine Meinung, die von der Canadian Security Intelligence Service, der die Situation als erhebliche Bedrohung eingestuft hat.

Die jüngsten Betrugsfälle durch das Klonen von Stimmen haben dies getan unterstrich die Dringlichkeit der Entwicklung zuverlässiger Deepfake-Erkennungsmethoden. Als Reaktion darauf hat Meta verbindliche Kennzeichnungen für KI-generierte Inhalte eingeführt und die Federal Communications Commission hat entschieden, dass Deepfake-Stimmen in Robocalls illegal sind. Politik-und KI-Experten sind besonders besorgt über die mögliche Zunahme der Deepfake-Nutzung im Vorfeld der US-Präsidentschaftswahlen.

Technologische Inspiration und Methodik

Yan Fossat, Senior Vice President of Digital Health Research and Development bei Klick Labs , ließ sich von der Science-Fiction inspirieren, um dieses Problem anzugehen. Unter Bezugnahme auf Filme wie „Terminator“ und „Blade Runner“ stellten sich Fossat und sein Team ein Werkzeug ähnlich der Voight-Kampff-Maschine vor, das physiologische Reaktionen misst, um die Authentizität zu bestimmen. Die Ergebnisse dieses Ansatzes wurden in der Open-Access-Zeitschrift JMIR Biomedical Engineering veröffentlicht und beschreiben die Ergebnisse von Klick Labs im Detail.

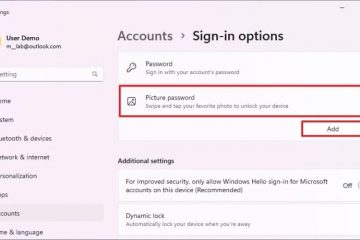

In ihrem Labor in Toronto begannen Fossat und sein Team mit der Stimmanalyse zu experimentieren. Sie sammelten Audioproben von 49 Personen mit unterschiedlichen Akzenten und Hintergründen und generierten mithilfe eines Deepfake-Generators synthetische Clips. Diese Clips wurden dann auf stimmliche Biomarker untersucht – charakteristische Merkmale in Stimmen, die Informationen über die Gesundheit oder Physiologie des Sprechers preisgeben.

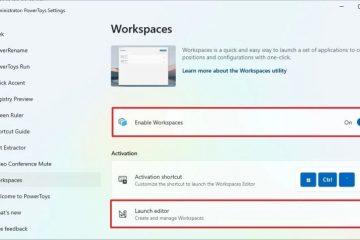

Klick Labs hat 12.000 stimmliche Biomarker identifiziert, aber ihre aktuelle Erkennungsmethode basiert auf fünf spezifischen Markern: Sprache Länge, Variation, Mikropausen, Makropausen und das Verhältnis der Zeit, die mit Sprechen und Pausen verbracht wird. Mikropausen sind kurze Pausen von weniger als einer halben Sekunde, während Makropausen länger sind. Diese Pausen treten auf natürliche Weise in der menschlichen Sprache auf, wenn Menschen atmen oder nach Wörtern suchen.

Herausforderungen und Zukunftsaussichten

Trotz einer Erfolgsquote von 80 % bei der Identifizierung von Deepfakes Fossat ist sich der Herausforderung bewusst, mit der sich schnell entwickelnden KI-Technologie Schritt zu halten. Beispielsweise haben die jüngsten Fortschritte von OpenAI bei der Generierung von Stimm-Deepfakes, die Mikroatemzüge simulieren, die Erkennung komplexer gemacht. Fossat bleibt jedoch optimistisch und weist darauf hin, dass Tausende anderer Biomarker, wie etwa die Herzfrequenz, für zukünftige Erkennungsmethoden genutzt werden könnten.

Die Forschung von Klick Labs geht über die Deepfake-Erkennung hinaus. Sie führen 16 weitere Studien zu stimmlichen Biomarkern und Krankheiten durch, darunter eine Studie, die in Mayo Clinic Proceedings veröffentlicht wurde: Digital Health, das ein KI-Modell demonstrierte, das Typ-2-Diabetes mit hoher Genauigkeit anhand von nur 10 Sekunden Sprachdaten erkennen kann. Diese Forschung wird in Zusammenarbeit mit dem Humber River Hospital in Toronto fortgesetzt und möglicherweise zu telefonbasierten Diagnosetools führen.