NVIDIAs neue Open-Source-Software TensorRT-LLM, deren Veröffentlichung in den kommenden Wochen geplant ist, hat eine deutliche Leistungssteigerung gezeigt. Bei Tests mit dem GPT-J 6B-Modell zeigte das aktualisierte System eine achtfache Leistungssteigerung gegenüber dem A100, ein deutlicher Sprung gegenüber dem vorherigen vierfachen Vorteil. Darüber hinaus übertrafen die mit TensorRT-LLM verbesserten H100s bei der Auswertung auf Metas Llama2 LLM die A100s um den Faktor 4,6, eine deutliche Verbesserung gegenüber dem 2,6-fachen vor dem Update.

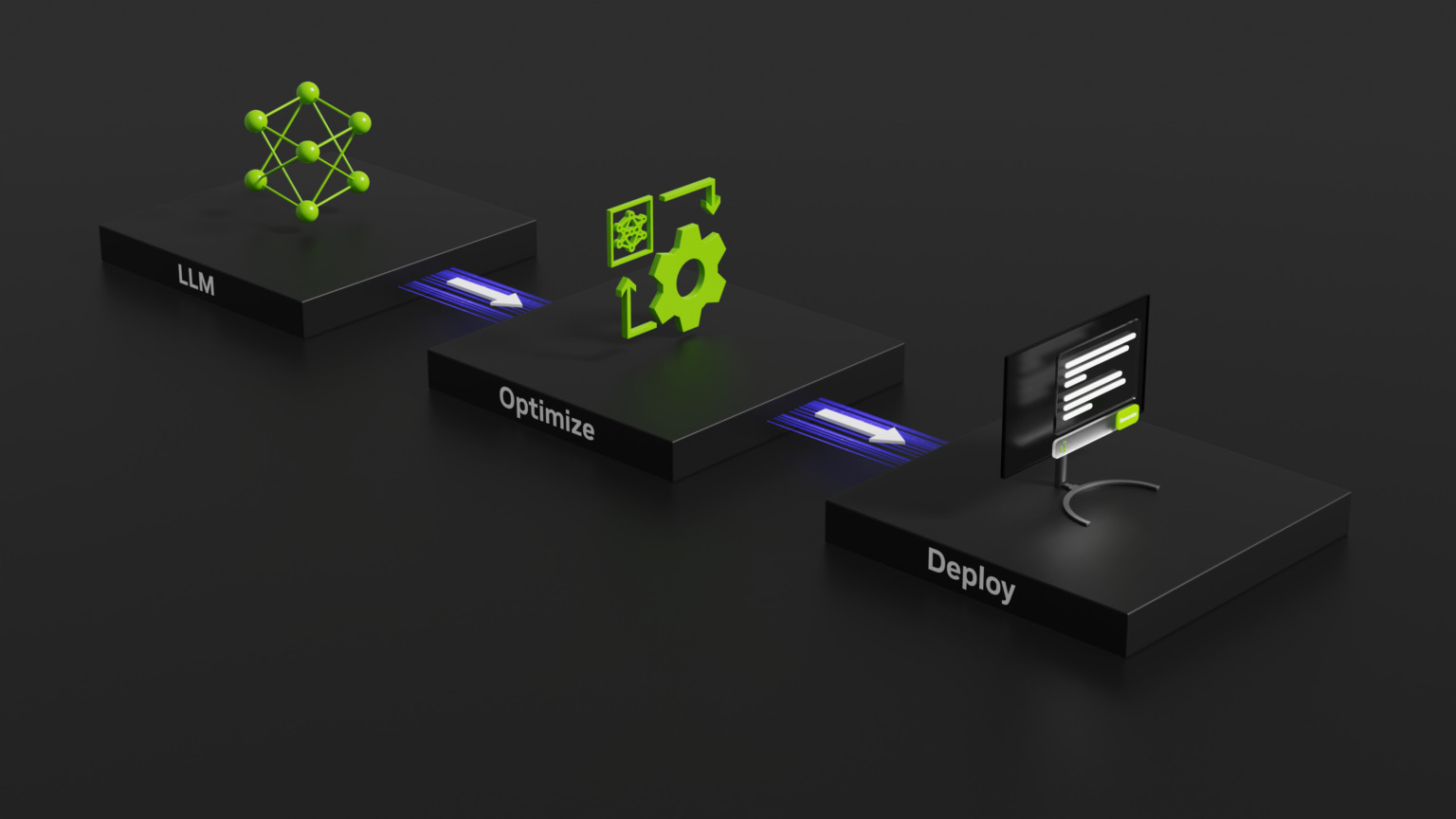

Um die Leistung von zu verbessern Für Large Language Models (LLMs) hat NVIDIA kürzlich TensorRT-LLM eingeführt, eine Open-Source-Bibliothek, die dafür entwickelt wurde Verbessern Sie die Leistung von Large Language Models (LLMs) auf der NVIDIA-Hardware.

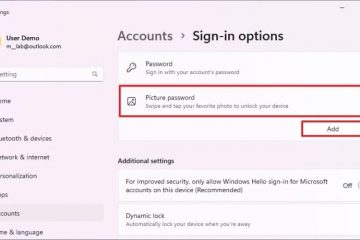

TensorRT-LLM ist eine Open-Source-Bibliothek, die auf NVIDIA Tensor Core-GPUs läuft. Seine Hauptfunktion besteht darin, Entwicklern eine Umgebung zum Experimentieren und Erstellen neuer großer Sprachmodelle zu bieten, die die Grundlage generativer KI-Plattformen wie ChatGPT bilden. Die Software konzentriert sich auf Inferenz, die den Trainingsprozess einer KI verfeinert und dem System hilft, zu verstehen, wie Konzepte verknüpft und Vorhersagen getroffen werden.

Gerade angekündigt – NVIDIA TensorRT-LLM beschleunigt großes Sprachmodell #inference auf NVIDIA H100 Tensor Core GPUs. #LLM https://t.co/jMX0EDxkXJ

– NVIDIA AI-Entwickler (@NVIDIAAIDev) 8. September 2023

Innovative Techniken hinter dem Boost

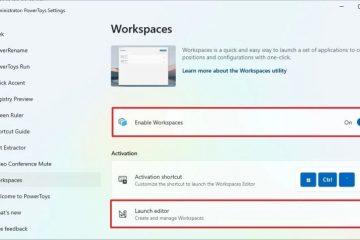

Die Herausforderung bei großen Sprachmodellen (LLMs) liegt darin in ihrer Vielseitigkeit, was es schwierig macht, Anfragen zu stapeln und gleichzeitig auszuführen. NVIDIA und seine Partner haben diese Herausforderung gemeistert, indem sie TensorRT-LLM mit einer fortschrittlichen Planungsmethode namens „In-Flight-Batching“ integriert haben. Dieser innovative Ansatz ermöglicht die Segmentierung der Textgenerierung in mehrere Unteraufgaben.

Im Wesentlichen kann das System dies Verarbeiten Sie neue Stapel aus unterschiedlichen Anforderungen gleichzeitig, anstatt auf den Abschluss eines einzelnen Stapels zu warten. Das TensorRT-LLM umfasst einen TensorRT-Deep-Learning-Compiler, optimierte Kernel, Vor-und Nachverarbeitungsschritte und erleichtert die Kommunikation über mehrere GPUs und Knoten hinweg. Dies führt dazu in beispielloser Leistung auf NVIDIAs GPUs und ermöglicht neuartige Experimente mit großen Sprachmodellen, schnelle Anpassung und Spitzenleistung.

Benchmarking-Exzellenz und Zukunftsaussichten

NVIDIAs GH200 Grace Hopper Superchip, der eine Hopper-GPU mit einer Grace-CPU kombiniert, hat beeindruckende Ergebnisse in den neuesten MLPerf-Branchenbenchmarks gezeigt. Der Superchip führte zusammen mit den H100-GPUs in allen Rechenzentrumstests von MLPerf, einschließlich Computer Vision, Spracherkennung und Medizin Bildgebung und die anspruchsvolleren Aufgaben von LLM-Inferenz-und Empfehlungssystemen. Darüber hinaus hat NVIDIA ein bevorstehendes Software-Update angekündigt, das die KI-Inferenzfähigkeiten seines GH200 Grace Hopper Superchips weiter verbessern wird.

KI ist ein wichtiger Wachstumsbereich für Nvidia und das Unternehmen sieht bereits die Vorteile, die sich daraus ergeben eine führende Rolle im Markt einnehmen. Jüngste Analysen haben ergeben, dass Nvidia mit jeder verkauften H100-Tensor-Core-GPU einen Gewinn von fast 1.000 % erzielt. Finanzielle Einblicke von Raymond James, einem renommierten Finanzdienstleistungsunternehmen, auf Barron’s geteilt, haben die Produktionskosten einer solchen GPU auf rund 3.320 US-Dollar geschätzt. Im krassen Gegensatz dazu schwankt der Verkaufspreis von Nvidia für diese GPUs je nach Bestellvolumen zwischen 25.000 und 30.000 US-Dollar.