OpenAI 週四發布了“青少年安全藍圖”,這是一個旨在保護年輕人工智能用戶的新框架。

此舉是對這家舊金山公司面臨的巨大法律和政府壓力的直接回應。 OpenAI 正在應對聯邦貿易委員會的調查、加州新的聊天機器人法以及將其 ChatGPT 工具與青少年自殘聯繫起來的訴訟。

為了應對危機,該公司提出了五項核心安全原則。其中包括更好的年齡檢測和對未成年人的默認保護。 OpenAI 希望這項積極主動的計劃能夠塑造未來的行業規則並解決日益增長的安全問題。

塑造 AI 安全規範的五點計劃

藍圖是 OpenAI 認為所有人工智能公司都應該採用的五項核心原則。

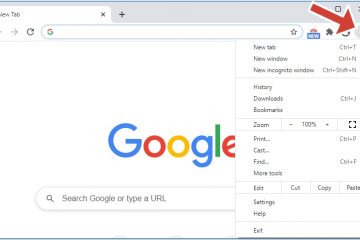

該公司將該文件不僅定位為內部政策,而且作為立法者制定新法規的起點。首先,它要求使用“保護隱私、基於風險的年齡估計工具”來識別平台上的青少年,以提供獨特的、適合年齡的體驗。

正如該公司所說,“我們相信 ChatGPT 應該滿足他們的需求:ChatGPT 對 15 歲青少年的反應方式應該不同於對成年人的反應方式。”

其次,該框架要求制定具體、嚴格的政策,以減輕用戶面臨的風險。 18. 根據藍圖,人工智能係統的設計不應描繪自殺或自殘,並且必須“禁止圖形或沉浸式(即角色扮演)親密和暴力內容。”

這些政策還旨在防止人工智能強化“通過外觀評級、身體比較或限制性飲食指導來強化有害的身體理想和行為。”

第三,OpenAI 倡導默認安全的 U18每當用戶的年齡有疑問時,尤其是未經身份驗證的用戶,都會遇到這種情況。即使這會妨礙成年人使用免費產品,這也會優先考慮安全性。

第四,該藍圖強調在公司最近推出的功能的基礎上,為家庭提供易於使用的家長控制功能。這些控件允許監護人鏈接帳戶、設置“封鎖時間”、管理數據隱私設置,並在青少年的活動表明有自殘意圖時接收警報。

最後,它要求通過嵌入心理健康研究提供的功能來設計福祉。 OpenAI 的文檔將其視為優先事項的根本性轉變。 “對於青少年來說,我們優先考慮安全,而不是隱私和自由。這是一項強大的新技術,我們相信未成年人需要大力保護。”

在監管和法律圍攻下的積極舉措

面對法律和監管審查的浪潮,OpenAI 的藍圖顯然是一種控制敘事的嘗試。該公司目前正在為一名自殺身亡青少年的父母提起的備受矚目的非正常死亡訴訟進行辯護。

該青少年的父親馬修·雷恩 (Matthew Raine) 發出了強有力的譴責,他表示:“作為父母,你無法想像閱讀與一個聊天機器人的對話是什麼感覺,而這個聊天機器人誘使你的孩子自殺。”

該案件引起了公眾的關注,並將公司的安全實踐置於顯微鏡下。

政府壓力從多方面不斷升級。 9 月,美國聯邦貿易委員會針對人工智能伴侶聊天機器人對青少年的影響發起了一項重大調查,目標是 OpenAI 和其他六家科技巨頭。

FTC 主席 Andrew N. Ferguson 將此次調查描述為一種平衡行為:“保護上網兒童是特朗普-萬斯 FTC 的首要任務,促進我們經濟關鍵領域的創新也是如此。”

州和聯邦立法者也在積極採取行動。在加利福尼亞州,州長 Gavin Newsom 於 10 月 13 日將 SB 243 簽署為法律,為人工智能製定了全國首個規則

該法律要求運營商提供反复警報,提醒未成年人他們正在與人工智能交談,阻止危險內容,並為家庭提供起訴不合規開發商的私人訴訟權。

該法案的作者、參議員史蒂夫·帕迪拉(Steve Padilla)此前曾辯稱,“大型科技公司已經一次又一次地證明,不能相信他們會自我監管。”在聯邦層面,由美國參議員組成的兩黨團體於 10 月底提出了《GUARD 法案》。

該法案更進一步,提議徹底禁止人工智能

在其藍圖中,OpenAI 反駁了不作為的說法,強調了其現有的安全措施。該公司指出,僅在 2025 年上半年,它就向當局報告了超過 75,000 條由人工智能生成的兒童性虐待材料的網絡提示。

平衡安全與有爭議的“道德警察”立場

然而,由於 OpenAI 將自己定位為青少年安全領域的領導者,它還必須應對自身相互矛盾的公開聲明和政策。這種安全導向的信息與公司最近的政策轉變形成了鮮明的對比。

就在上個月,首席執行官 Sam Altman 為一項有爭議的決定進行了辯護,該決定允許在 ChatGPT 上顯示年齡限制的色情內容。他反駁了批評,宣稱:“我們不是世界上民選的道德警察。”此舉引起了馬克·庫班等人物的擔憂,讓公司內部產生了一種優先事項相互衝突的感覺。

青少年安全藍圖可以被視為一系列快速舉措中的最新舉措,旨在展示對安全的承諾。 9 月下旬,該公司推出了一套家長控制系統。

僅僅兩週後,該公司宣布成立一個由八名成員組成的專家委員會,就福祉和心理健康提供建議。

這些挑戰並非 OpenAI 所獨有,而是反映了更廣泛的全行業的考慮。像 Meta 這樣的競爭對手也面臨著青少年安全方面的法律危機。華盛頓特區一家法院最近援引了罕見的犯罪欺詐例外條款,裁定 Meta 不得將內部青少年傷害研究隱藏在律師-委託人特權的背後。

法院發現了證據,表明律師建議研究人員改變調查結果以限制責任,從而驗證了舉報人關於“看似合理的推諉”策略的主張。通過發布藍圖,OpenAI 正在戰略性地定義人工智能安全條款,希望在監管機構和法院實施更嚴格的規則之前製定規則。