人工智能不再只是改善語音綜合,而是使機器像真實的人一樣說話。最新的AI語音模型不僅會產生光滑,自然的句子; they introduce hesitation, mispronunciations, and tone variations, mimicking the subtle imperfections of human speech.

Some testers have found this level of realism unsettling, as AI-generated voices now feel indistinguishable from human conversation.

Among the most striking demonstrations of this shift is Sesame AI’s new demo of an upcoming voice assistant, which has raised concerns about how artificial speech is evolving.

Unlike traditional digital voices that aim for perfect clarity, Sesame’s model is designed to introduce speech irregularities, making it feel organic and unscripted.

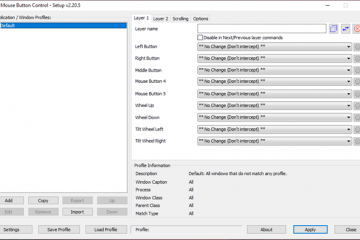

Sesame AI’s Hyper-Realistic Approach

Sesame AI has been pushing the boundaries of synthetic speech by designing AI-generated voices that go beyond traditional text-to-speech systems.

Unlike conventional AI assistants that prioritize clarity and efficiency, Sesame’s voice models are engineered to introduce imperfections that make them sound more natural.這些包括微妙的語音不規則性,例如猶豫,輕微的絆倒,甚至在音調和節奏的變化中,模仿了人類不確定性。

芝麻AI的關鍵創新之一是其對話性語音模型(CSM),它的語音模型,能夠表達對話適應的語音模型,這意味著它可以動態地調整基於用戶輸入的音調和速度。這使AI可以以更真實而不是機械預先錄製的方式做出反應。

該系統旨在實時檢測停頓和中斷,模擬人們在面對面對話中自然調整語音模式。

對話。 sesame.com/research/crossing_the_uncanny_valley_of_voice”> is在一個高級深度學習框架上構建的在真實世界的大量數據集中訓練。與依靠串聯合成或統計參數模型的傳統語音模型不同,芝麻採用基於神經的零攝像語音適應。

這意味著該系統可以生成新的,獨特的聲音,這些聲音可以在不同的對話中保持一致的身份,而不需要進行範圍的流程。這使其與當前的大多數AI語音助手不同,這些助手與以前的交換無關。

使用這種方法,芝麻AI的系統可以在擴展的互動中保持聲音一致性,在隨意和正式之間轉移,根據對話的發展方式通過複製人類如何通過音調,音量和節奏的變化來表達情感由於數據集污染,儘管它在其他語言中的表現還不好。

該模型也無法利用預訓練的語言模型,這是公司計劃更改的事情。在接下來的幾個月中,芝麻AI希望擴大模型大小,將語言支持擴展到20多種語言,並探索整合預訓練的模型以構建更先進的多模式系統。

,而CSM已經產生了自然聽起來的語音,它仍然會與對話流動-諸如轉向,暫停,暫停,暫停,暫停,暫停,暫停和自然對話的鬥爭。這意味著您可以通過sesame ai的互動演示您可以與他們的兩個ai thection the the the the the the the the The The The Big STEP,數據收集,模型培訓和後處理技術的更新。

OpenAI的高級語音模式正在領導

超現實AI語音的途徑已經在製作中是多年來的,但是最近的突破已經加速了

openai 。但是,直到2024年7月,該公司才以表達的實時響應引入其高級語音模式。

伴隨著爭議,當時AI的聲音之一被發現與女演員Scarlett Johansson緊密相似,導致了對語音的響應式的響應,並重複了

Econds,使對話變得無縫。

2024年12月,當OpenAI將實時視頻支持引入高級語音模式時,標誌著一個重大飛躍,使用戶可以向AI顯示對象進行實時互動。在2025年2月,OpenAI使自由層的用戶提供了高級語音模式,儘管有局限性-

同時,OpenAI將其語音功能擴展到了ChatGpt本身之外,將AI語音和圖像擴展到了2025年2月的App App App App App App Applation Apperational Apectional Atemention Aimainsemains <強度<

隨著AI聲音變得越來越先進,主要科技公司正在競爭主導空間。 Microsoft已刪除了對Copilot中AI語音交互的所有限制,使用戶可以自由地訪問其語音助手。

同時,Google的Gemini Live努力匹配OpenAI的自然語音能力,早期用戶反饋突顯了與ChatGpt的流體響應相比,它仍然感覺到機器人的感覺。它的Grok Chatbot並沒有專注於超現實主義,而是具有“無關”的模式,允許其發誓,爭論和進行積極的對話。

此舉引發了關於AI在對話中的行為的爭論,該如何在對話中表現出來,是否應該是中性和有禮貌的,或者是否可以表現出更加明確的個性3>

AI生成的聲音的越來越多的現實性是最大的威脅之一。錯誤的信息和政治欺騙可能會變得更加困難。研究表明,人們更有可能信任人類的聲音,這可能導致與AI的意外情感聯繫,開發人員正在將重點轉移到進一步完善的技術上。

OpenAI有望通過更自定義功能擴展Chatgpt的高級語音模式,從而為用戶提供了對語調,起搏和個性性狀等方面的控制。

。

,儘管這可以增強用戶體驗,但它也引起了新的道德問題。是否應該允許AI生成的聲音與特定的個體無法區分?他們是否應該優化以喚起用戶的情緒?

與此同時,微軟正在繼續使用其副駕駛推進AI聲音,從而整合其生態系統的語音互動。 Google, struggling to close the gap with OpenAI, is working on a major overhaul of Gemini Live to make its speech patterns more natural.

The race to perfect AI-generated conversations is far from over, and competition between major tech firms is expected to intensify as the technology matures.