繼 10 月份推出 M5 芯片之後,Apple 現已發布了該芯片“神經加速器”的架構藍圖,這是一種專用 GPU 組件,旨在挑戰 Nvidia 在本地 AI 工作負載方面的主導地位。

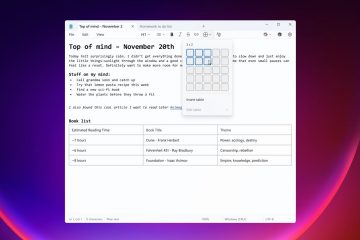

今天的一份新技術報告詳細介紹了該架構,該架構利用更新的 MLX 機器學習框架,與之前的架構相比,“首次令牌時間”(TTFT) 推理速度提高了 4 倍。 M4。

此披露將最初的營銷要點轉變為記錄在案的硬件功能,確認 M5 的 153GB/s 內存帶寬和專用矩陣單元是專門為打破困擾消費設備上大型語言模型 (LLM) 執行的內存瓶頸而設計的。

M5 內部:神經加速器架構

Apple 工程師不再僅僅依賴原始時鐘速度,而是從根本上重新設計了 M5 中的 GPU 核心,以包含專門的“神經加速器”。這些單元是專門為處理支撐現代生成人工智能的密集矩陣乘法運算而設計的。

在 M5 芯片揭曉時,高管們將芯片定位為一次飛躍,但技術細節仍然不透明,直到發布 Apple 官方技術報告。

更新的技術論文澄清了這一點這些加速器專門針對推理的“預填充”階段,即模型處理用戶提示的計算密集型初始步驟。

在發佈時,Apple 硬件技術高級副總裁 Johny Srouji 將該功能定義為結構性轉變,並指出“M5 引領了 Apple 芯片 AI 性能的下一個重大飛躍。隨著 GPU 中神經加速器的引入,M5 為 AI 工作負載帶來了巨大的提升。”

至關重要的是,所有任務的性能提升並不相同。雖然由於新的計算單元,預填充階段的性能顯著提高了 4 倍,但隨後的令牌生成階段仍然受到數據在系統中移動速度的限制。正如官方技術報告中所解釋的:

“在 LLM 推理中,生成第一個令牌是受計算限制的,並充分利用神經加速器。生成後續令牌受內存帶寬限制,而不是受計算能力限制。

在我們在本文中測試的架構中,與 M4 相比,M5 提供了 19-27% 的性能提升,這要歸功於其更大的內存帶寬(M4 為 120GB/s, M5 為 153GB/s,高出 28%)

就內存佔用而言,MacBook Pro 24GB 可以輕鬆容納 8B BF16 精度或 30B MoE 4 位量化,使這兩種架構的推理工作負載保持在 18GB 以下。”

這種差異凸顯了 M5 升級路徑的雙重性質。內存帶寬現在的時鐘頻率為 153GB/s,比 M4 的 120GB/s 提高了 28%,這與觀察到的生成速度 19-27% 的提升直接相關。

對於開發人員來說,這意味著 M5 特別擅長處理複雜的長上下文提示,其中初始處理時間是主要瓶頸。該系統具有 24GB 統一內存容量,能夠完全在設備上執行大量模型,例如 BF16 精度的 8B 參數模型或 4 位量化的 30B 專家混合 (MoE) 模型。

根據 Apple 研究團隊的說法,“神經加速器提供專用矩陣乘法運算,這對於許多機器學習工作負載至關重要,並可在 Apple 上實現更快的模型推理體驗”矽。 “

解鎖矽:MLX 框架演變

除了矽本身之外,軟件故事也不斷發展以匹配硬件的功能。要利用新的神經加速器,開發人員必須更新到 MLX 框架 0.30.0 版,這是 Apple 專為統一內存架構設計的開源數組庫。

文檔表明,要完全支持這些功能需要“macOS 26.2″,該版本號可能指內部即將推出的 macOS 16.2 (Tahoe) beta 的版本或拼寫錯誤。這樣的先決條件強調了操作系統內核和驅動加速器的金屬性能著色器之間的緊密耦合。

通過更新的堆棧,Apple 聲稱“GPU 神經加速器在涉及大型矩陣乘法的 ML 工作負載上與 MLX 相得益彰,與語言模型推理中的首次標記時間的 M4 基線相比,可實現高達 4 倍的加速。 “

開發人員還可以利用 MLX Swift 用於構建在從 macOS 到 iOS 的整個 Apple 生態系統中本機運行的應用程序。跨平台兼容性是一個關鍵的區別因素,允許為 MacBook Pro 編寫的代碼只需進行最少的修改即可部署在 iPad Pro 上。 Apple 的文檔詳細介紹了這種集成:

“MLX 適用於所有 Apple 芯片系統,並且在最新的 macOS Beta 版本中,它現在利用了新款 14 英寸 MacBook Pro 中引入的新型 M5 芯片中的神經加速器。神經加速器提供專用的矩陣乘法運算,這對於許多機器學習工作負載至關重要,並可在 Apple 芯片上實現更快的模型推理體驗。 “

從戰略上講,軟件推送與更廣泛的計劃保持一致,包括 Apple 悄悄支持的 CUDA 後端計劃。通過為 MLX 代碼在 Nvidia 硬件上運行提供“單向橋”,Apple 將其框架定位為一個可行的開發環境,可以根據需要擴展到數據中心集群。

但是,主要重點仍然是本地執行。 Apple Silicon 缺乏外部 GPU 支持意味著開發人員完全依賴於內部統一內存架構,這使得 MLX 框架的效率對於性能至關重要。

“Mac 集群”中斷:挑戰數據中心

雖然單個 M5 芯片提供了強大的本地能力,但開源社區的一項新發展正在挑戰傳統的數據中心模型。 ExoLabs 集群軟件等新的開源工具現在允許用戶通過 Thunderbolt 5 將多個 Mac Studio 連接在一起,創建一個能夠運行大型模型的分佈式推理集群。

這種集群功能可以擴展以支持與新的 Kimi K2 Thinking 模型(1 萬億參數 MoE 架構)一樣大的模型。通過匯集多個 M5 Ultra 或 Max 芯片的統一內存,這些集群可以繞過單個消費類 GPU 的 VRAM 限制。

Apple 研究人員強調了這種方法的效率,並指出“M5 將密集 14B 架構的首次令牌生成時間縮短到 10 秒以內,將 30B MoE 的首次生成時間縮短到 3 秒以內,從而為 MacBook Pro 上的這些架構提供了強大的性能。 “

能效參數是對於研究實驗室和小型企業來說尤其引人注目。四個 Mac Studio 組成的集群功耗不到 500 瓦,只是同類 Nvidia H100 服務器機架所需功率的一小部分。

儘管 Thunderbolt 5 的延遲無法與 Nvidia 專有的 NVLink 互連的速度相匹配,但該設置為需要數據隱私且不能依賴基於雲的推理的組織提供了“主權 AI”解決方案。超級計算級推理的民主化代表了大型模型在超大規模數據中心之外部署方式的重大轉變。