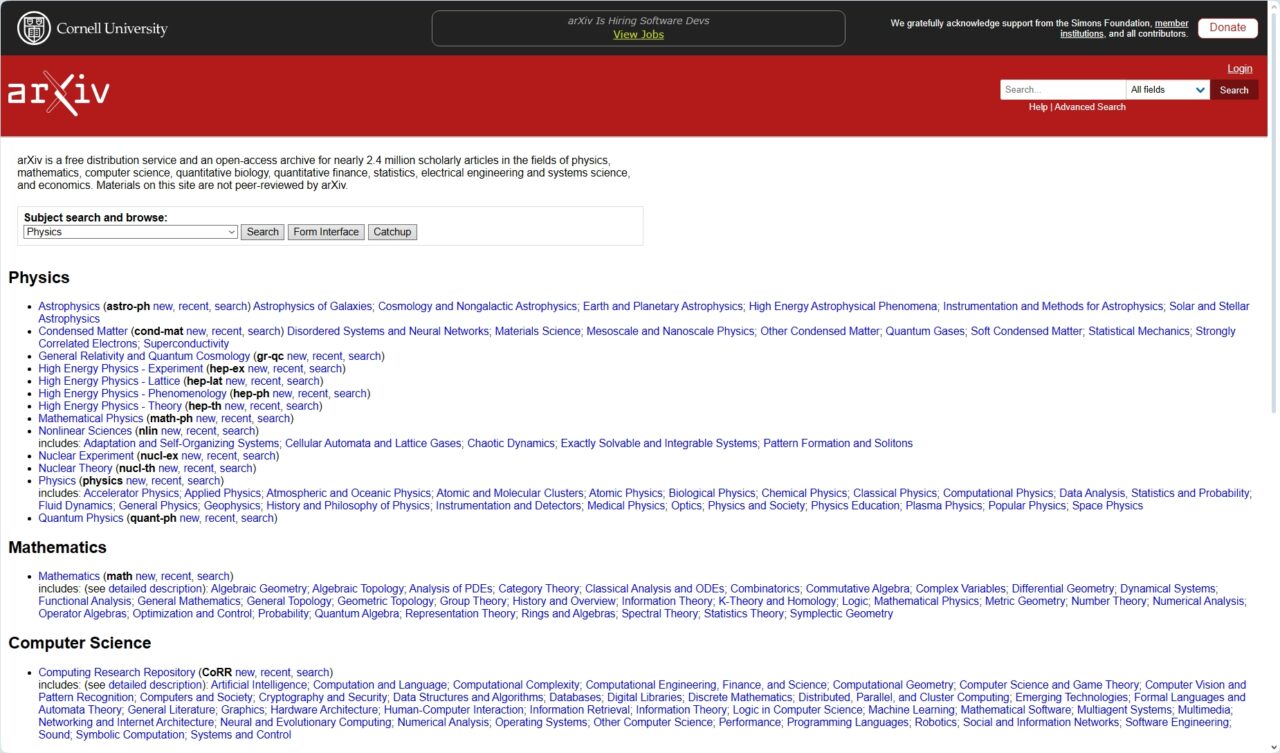

面對大量低質量的人工智能生成內容,學術預印本服務器 arXiv 正在收緊計算機科學論文的提交規則。

在 10 月 31 日的公告中,這個頗具影響力的平台表示,其計算機科學 (CS) 類別將不再接受評論文章或立場文件,除非它們已經在公認的期刊或會議上通過了同行評審。

此舉旨在減輕志願者版主的負擔,並直接面對 arXiv 所說的使用生成人工智能“快速且易於編寫”但往往缺乏實質內容的大量提交內容。

AI 產生的大量“廢話”

為了保障研究質量,arXiv 正直面大型語言模型對學術出版的影響。該平台已被大量提交的文章淹沒,尤其是在快速發展的計算機科學部分。

根據其官方聲明,該網站現在每月收到“數百篇評論文章”。其龐大的數量已經讓平台的審核系統難以管理。

其中許多提交的內容未能達到基本的學術標準。 arXiv 版主發現,“我們收到的大多數評論文章只不過是帶註釋的參考書目,沒有對開放研究問題進行實質性討論。”

此類論文會造成學術噪音,浪費研究人員尋找新穎見解的時間。如此便捷的製作給審查論文的志願專家帶來了巨大的壓力。

正如 arXiv 所解釋的那樣,“生成式人工智能/大型語言模型通過使論文(尤其是不介紹新研究成果的論文)快速且易於撰寫,加劇了這場洪水。”

這種輕鬆內容的激增有可能埋葬合法研究並稀釋平台的價值。

促成這場洪水的複雜工具也在數量和數量上不斷增長。能力。最近的論文,比如一篇描述多智能體人工智能研究助理的論文,展示了能夠自動化從構思到起草的整個學術寫作過程的技術。

這項技術使得生成聽起來合理但最終空洞的文獻評論變得微不足道,加劇了 arXiv 現在試圖解決的問題。要求事先進行同行評審是一個關鍵的過濾器,將最初的質量控制外包給知名期刊和會議。

壓力下的系統

雖然政策變化是新的,但根本問題卻不是。 學術同行評審過程多年來一直在“要么發表,要么滅亡”的文化中苦苦掙扎,這種文化注重數量而不是質量。

京都藥科大學的 Satoshi Tanaka 等專家認為,學術界的同行評審過程“陷入了危機”。

加劇危機的是志願審稿人數量有限,他們被提交的數量所淹沒。這種疲勞造成了人工智能工具(無論好壞)都開始利用的漏洞。

arXiv 以前一直是人工智能和學術誠信爭論的中心。去年,研究人員甚至被發現在論文中嵌入隱藏命令來操縱人工智能驅動的審稿系統,這種做法被稱為提示注入。

通過用白色文本或微型字體隱藏指令,作者試圖欺騙自動化系統給出積極的反饋。該事件突顯了自動化系統是多麼容易被操縱,從而破壞整個審核流程。

arXiv 最近的變化的細微差別甚至引起了混亂,一些媒體最初誤報了新規則的範圍。

不是新政策,而是必要的執行

arXiv 官員援引大量難以管理的提交內容澄清說這一變化更多的是一種強制措施,而不是一項新政策。

評論文章和立場文件從未被正式接受的內容類型,但歷史上,當它們具有高質量和學術興趣時,由版主酌情允許。

最近,在人工智能的推動下,數量激增,使得這種酌情處理方法變得站不住腳。保護這些志願者審核員的時間(預印本系統的基石)至關重要。

arXiv 平台指南規定,人類作者對人工智能工俱生成的任何內容負全部責任,並明確禁止將人工智能列為共同作者。

針對 CS 類別採用這種新的審核實踐是這一原則的邏輯延伸,強化了人類主導的驗證仍然至關重要。整個行業的出版商都在努力解決這個問題,制定了分散的政策。

雖然有些出版商允許有限的人工智能使用,但愛思唯爾等其他出版商已經完全禁止它,理由是“該技術可能會產生不正確、不完整或有偏見的風險”結論。 “

展望未來,該平台表明其他學科可能會出現類似的變化。 arXiv 在其公告中指出,“如果其他類別的法學碩士撰寫的評論文章和立場文件出現類似增長,他們可能會選擇以類似的方式改變其審核實踐……”

如果人工智能生成內容的浪潮繼續蔓延,這一舉措表明潛在的全平台轉變。它將 arXiv 的舉措定位為不是一個孤立的解決方案,而是整個科學界將如何被迫適應生成人工智能的挑戰和誘惑的潛在領頭羊。