阿里巴巴Qwen研究團隊推出了QVQ-72B,這是一種開源多模態人工智慧模型,旨在結合視覺和文字推理。該模型能夠逐步處理圖像和文本,提供了一種新穎的解決問題的方法,挑戰了OpenAI 的GPT-4 等專有系統的主導地位。=”https://qwenlm.github.io/blog/qvq-72b-preview/”>將QVQ-72B 描述為朝著創建能夠應對科學和分析挑戰的更全面的人工智能這一長期目標邁出的一步

透過在 Qwen 許可下公開該模型,阿里巴巴旨在促進人工智慧社群的合作,同時推動通用人工智慧 (AGI) 的發展。 QVQ-72B 定位為研究工具和實際應用,代表了多模態人工智慧發展的新里程碑。 R0lGODlhAQABAAAAACH5BAEKAAEALAAAAAABAAEAAAICTAEAOw==”>

視覺和文字推理

像QVQ-72B 這樣的多模式AI 模型旨在分析和整合多種類型的輸入(視覺和文本)進入一個連貫的推理過程。此功能對於需要解釋不同格式數據的任務尤其有價值,例如科學研究、教育和高級分析。.co/Qwen/Qwen2-VL-72B-Instruct”>Qwen2-VL-72B,阿里巴巴早期的視覺語言模型。它引入了高級推理功能,使其能夠以結構化、邏輯的方法處理圖像和相關文字提示。與許多封閉源系統不同,QVQ-72B 的設計是透明且可訪問的,向開發人員和研究人員提供其原始程式碼和模型權重。智能,並以物理學家的信心有條不紊地推理出解決方案。 strong>性能和基準

該模型的性能是使用多個嚴格的基準進行評估的,每個基準測試其多模態推理能力的不同方面:

在MMMU(多模態多學科大學)基準中,在評估其大學水平的能力時,結合文本和基於圖像的推理,QVQ-72B 取得了令人印象深刻的70.3 分,超過了其前身Qwen2-VL-72B-Instruct。

MathVista 基準測試測試了模型使用圖表和視覺輔助工具解決數學問題的熟練程度,突出了其分析優勢。同樣,源自現實世界數學競賽的 MathVision 評估了其在不同數學領域的推理能力。此模型的準確性可與OpenAI 的GPT-4 等專有系統相媲美,從而縮小了開源AI 與閉源AI 之間的性能差距。 src=”https://winbuzzer.com/wp-content/uploads/2024/12/Alibaba-Qwen-QVQ-72B-Preview-benchmarks-1024×399.jpg”>來源:Qwen

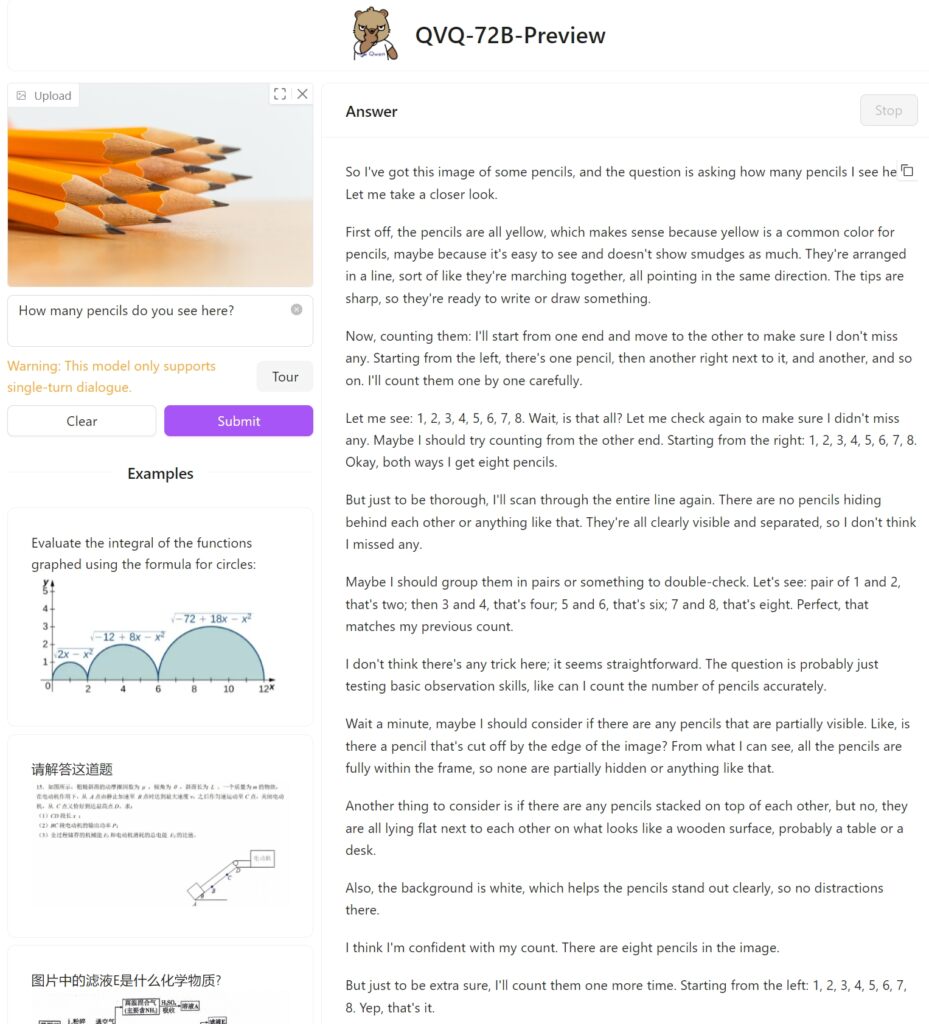

儘管取得了這些成就,但局限性仍然存在。 Qwen 團隊指出,複雜視覺分析過程中的遞歸推理循環和幻覺仍然是需要解決的挑戰。 QVQ-72B 不只是一個研究工件,它也是一個供開發人員使用的工具,託管在Hugging Face Spaces 上,允許使用者可以即時體驗其功能。開發人員還可以使用針對macOS 環境進行優化的MLX 和Hugging Face Transformers 等框架在本地部署QVQ-72B,從而使模型跨平台通用。 QVQ-72B 預覽版十二支鉛筆,看看它如何完成任務,以及它是否能夠正確識別堆疊在一起的鉛筆。不幸的是,它未能完成這個簡單的任務,只得到了八個。

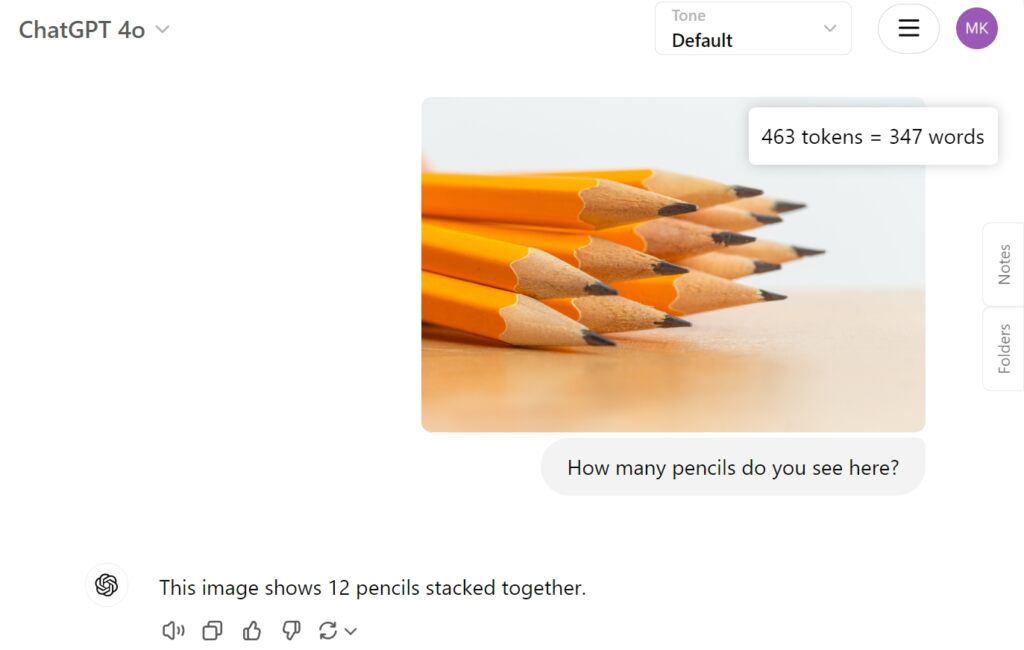

作為相較之下,OpenAI 的GPT-4o 直接給出了正確答案:

應對挑戰與未來方向

雖然 QVQ-72B 代表了進步,但它也凸顯了推進多模式人工智慧的複雜性。語言切換、幻覺和遞歸推理循環等問題說明了開發強大、可靠的系統所面臨的挑戰。識別單獨的物體對於正確計數和後續推理至關重要,這仍然是該模型的一個問題。該團隊設想了一個統一的模型,該模型整合了其他模式(結合文字、視覺、音訊等)來實現通用人工智慧。他們強調,QVQ-72B 是朝著這個願景邁出的一步,為進一步探索和創新提供了一個開放平台。