SambaNova Systems 是專注於企業的生成式AI 領域的主要參與者,它設定了新的性能基準,吞吐量達到每秒1,000 個代幣使用 Llama 3 8B 參數指令模型。這項成果經獨立測試公司人工分析驗證,超越了 Groq 之前保持的每秒 800 個代幣的記錄。這一里程碑代表了生成式人工智慧系統能力的重大進步。 。其好處包括更快的回應時間、提高的硬體利用率和降低的營運成本。這種加速對於需要低延遲和高吞吐量的應用程式尤其有利,例如人工智慧代理、消費者人工智慧應用程式和大容量文件解釋。人工分析共同創辦人喬治‧卡梅倫告訴VentureBeat 專注於人工智慧晶片競賽的不斷發展步伐,並強調人工智慧開發人員可用的不斷擴大的硬體選項。他的公司強調這些系統的實際性能,為依賴速度的用例帶來新的興奮。 🚀

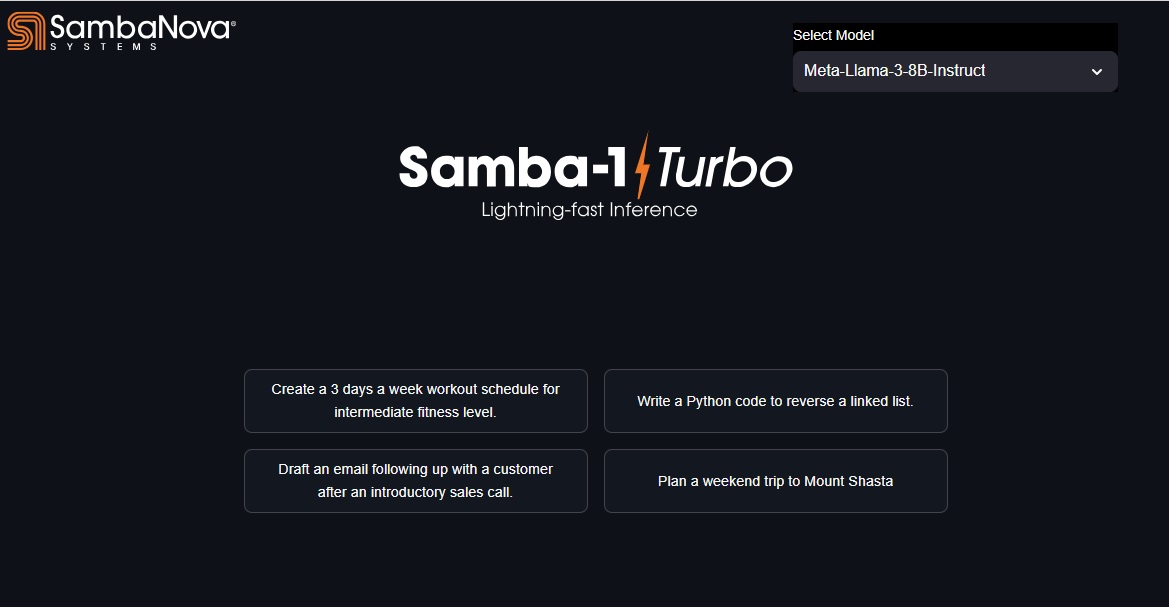

Samba-1 Turbo 表現出色速度高達1000 t/s,世界紀錄:https://t.co/PmDHWrFGCH。.com/hashtag/AI?src=hash&ref_src=twsrc%5Etfw”>#AI # GenAI #EnterpriseAI #LLM #NLP #AIAreAll #GPUAlternative #EnterpriseScaleAI #AIChips #ChipRace pic.twitter.com/TMtUqyZWpy

— SambaNova 系統(@ SambaNovaAI ) 2024 年5 月29 日

成就背後的技術進步

SambaNova 成功的核心在於其可重構資料流單元 (RDU) 技術,該技術使其有別於 Nvidia GPU 等傳統 AI 加速器。 RDU 是專門的 AI 晶片,旨在支援 AI 模型開發的訓練和推理階段。他們擅長處理企業工作負載需求,包括模型微調。 SambaNova 的軟體堆疊在優化 RDU 以獲得性能提升方面發揮著至關重要的作用,允許跨不同神經網路層迭代優化資源分配,從而顯著提高效率和速度。 1-Turbo 採用SN40L 晶片,在實現這一世界紀錄方面發揮了重要作用。 Samba-1-Turbo 每秒以 16 位元精度處理 1,000 個令牌,運行先進的 Llama-3 Instruct (8B) 模型。傳統 GPU 經常受到片上記憶體容量有限且頻繁資料傳輸的困擾,與此不同的是,SambaNova 的 RDU 透過其模式記憶體單元 (PMU) 擁有大量分散式片上記憶體。這些 PMU 靠近運算單元,可最大程度地減少資料移動並提高效率。會增加延遲並未充分利用計算單元。相較之下,SambaFlow 編譯器將整個神經網路模型作為資料流程圖映射到 RDU 結構上,從而實現管線資料流執行並提高效能。在 GPU 上處理大型模型通常需要複雜的模型並行性,需要專門的框架和程式碼。 SambaNova 的RDU 架構在映射系統中的多個RDU 時自動實現資料和模型並行化,從而簡化流程並確保最佳效能。 co/meta-llama/Meta-Llama-3-8B-Instruct”>Meta-Llama-3-8B-Instruct 模型為 Samba-1-Turbo 提供了前所未有的速度和效率。此外,SambaNova 的SambaLingo 套件支援多種語言,包括阿拉伯語、保加利亞語、匈牙利語、俄語、塞爾維亞語(西里爾文)、斯洛維尼亞語、泰語、土耳其語和日語,展示了該系統的多功能性和全球適用性。 Samba-1-Turbo 中硬體和軟體的緊密整合是其成功的關鍵,使企業能夠更輕鬆、更有效率地使用生成式 AI。