Embora tenha alertado publicamente sobre a”irracionalidade”no mercado de IA, a liderança do Google ordenou de forma privada uma expansão agressiva da infraestrutura para dobrar a capacidade de atendimento de IA a cada seis meses.

De acordo com uma apresentação vista pela CNBC esta semana, a diretriz visa um aumento de escala de 1.000 vezes dentro de cinco anos para apoiar a “era da inferência” de computação pesada.

Fornecido pelo vice-presidente de infraestrutura Amin Vahdat, este mandato interno contrasta fortemente com os comentários recentes do CEO Sundar Pichai a uma entrevista com a BBC sobre uma possível bolha.

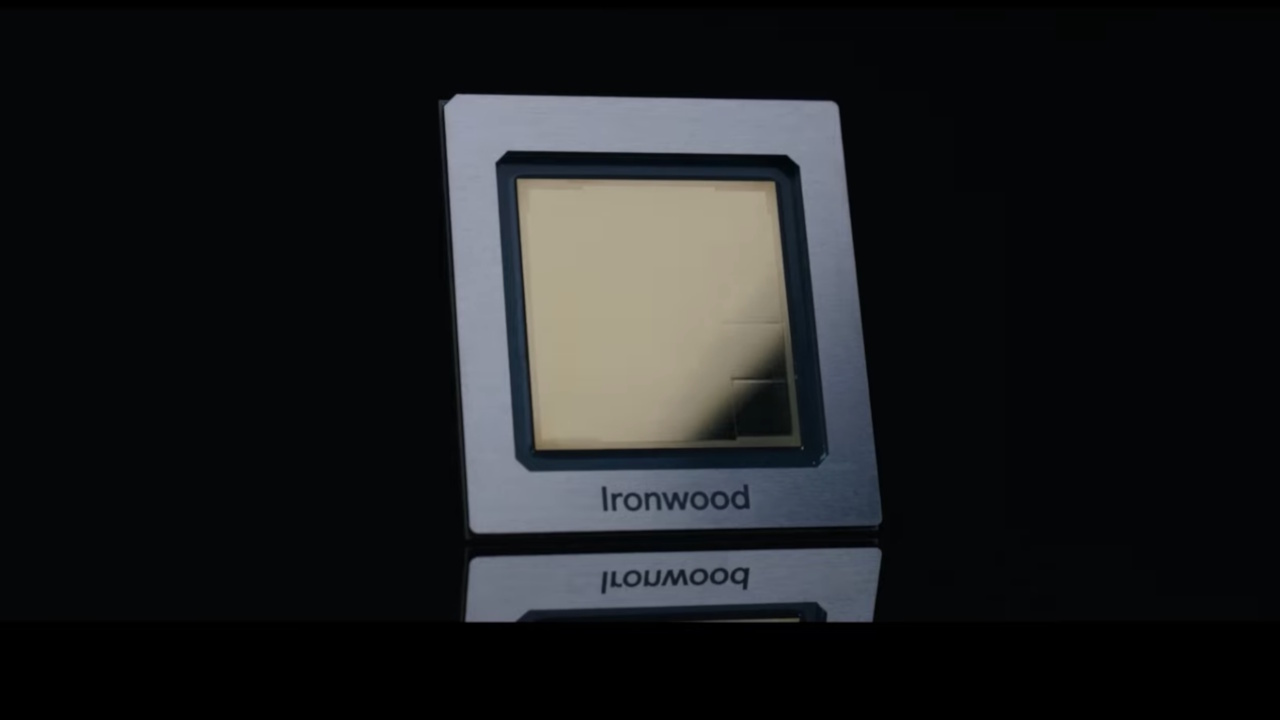

Impulsionada pelo medo existencial de subinvestir, a estratégia depende de silício personalizado, como os chips Ironwood TPU do Google, para evitar que os custos subam em espiral. o crescimento da capacidade.

O Mandato 1.000x: Por dentro da sala de guerra do Google

Os detalhes emergentes da reunião geral de 6 de novembro pintam o retrato de uma empresa operando em condições de guerra.

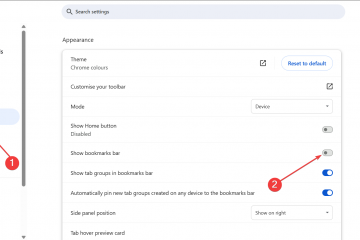

O vice-presidente de infraestrutura, Amin Vahdat, apresentou um roteiro intitulado “Infraestrutura de IA” que estabeleceu os requisitos de crescimento exponencial necessários para acompanhar o ritmo da demanda. Explicitamente, a directiva exige que a Google duplique a sua capacidade de serviço de IA a cada seis meses para manter a sua posição competitiva.

As projecções a longo prazo apontam para um aumento surpreendente de 1.000 vezes na capacidade dentro de apenas quatro a cinco anos. Impulsionar essa aceleração não é o treinamento de modelos, que historicamente consumiu a maior parte dos recursos de computação, mas uma mudança fundamental para a “era da inferência”.

Modelos como o recém-lançado Gemini 3 Pro exigem um poder de computação massivo e contínuo para realizar tarefas de raciocínio e executar código.

Vahdat alertou que “a competição na infraestrutura de IA é a parte mais crítica e também a mais cara da corrida de IA”.

Esse sentimento foi reforçado pelo CEO Sundar Pichai, que citou oportunidades perdidas. com a ferramenta de geração de vídeo da empresa, Veo, devido a limitações de hardware. Pichai admitiu que, apesar do forte crescimento da nuvem, “esses números teriam sido muito melhores se tivéssemos mais computação”. A mensagem da liderança é clara: a principal restrição ao crescimento não é mais a capacidade do software, mas a disponibilidade física da computação.

O escudo do silício: Ironwood, Axion e a armadilha da eficiência

Ampliar a capacidade em 1.000 vezes usando hardware pronto para uso seria financeiramente ruinoso. A estratégia do Google depende de dissociar os ganhos de desempenho dos aumentos lineares de custos. Vahdat descreveu o requisito de engenharia:

“O Google precisa ‘ser capaz de fornecer 1.000 vezes mais capacidade, computação e rede de armazenamento por essencialmente o mesmo custo e, cada vez mais, a mesma potência, o mesmo nível de energia’, disse Vahdat.”

A base dessa expansão massiva é uma realidade econômica simples, mas brutal: a eficiência é o único caminho para a sustentabilidade. A confiança na Ironwood TPU, que entrou em disponibilidade geral recentemente, é fundamental para esta estratégia.

Alegando uma melhoria de desempenho de pico de 10x em relação ao v5p, este chip de sétima geração oferece 2x de desempenho por watt em comparação com a geração Trillium anterior.

Cargas de trabalho de uso geral estão sendo transferidas para as novas CPUs Axion baseadas em Arm para liberar energia e espaço térmico para tarefas de IA. Ao migrar tarefas de computação padrão para processadores mais eficientes, o Google pretende maximizar a energia disponível para suas TPUs que consomem muita energia.

Adotando uma filosofia de “co-design”, os engenheiros integram o software diretamente à arquitetura de hardware. A pesquisa do Google DeepMind informa o design do chip, permitindo à empresa obter ganhos onde o hardware padrão não consegue. Vahdat observou que “não será fácil, mas por meio da colaboração e do co-design chegaremos lá”.

No entanto, a “armadilha da eficiência” está iminente. O paradoxo de Jevons sugere que à medida que a computação se torna mais eficiente, a procura aumentará para consumir o excedente, anulando a poupança de custos. Se o custo da inferência cair, o volume de consultas – impulsionado por fluxos de trabalho de agentes e raciocínio de “pensamento profundo” – deverá explodir, mantendo alto o consumo total de energia.

O Paradoxo da Bolha: Apostar Contra a ‘Irracionalidade’

Em meio ao crescente ceticismo externo em relação ao retorno sobre o investimento (ROI) para IA generativa, essa expansão interna agressiva prossegue.

Em uma entrevista com o BBC, Pichai admitiu que existem “elementos de irracionalidade” na atual avaliação de mercado da IA. Apesar desta cautela pública, a Alphabet elevou a sua previsão de despesas de capital para 2025 para 93 mil milhões de dólares, com um “aumento significativo” planeado para 2026.

Os funcionários desafiaram diretamente a liderança nesta desconexão durante a sessão de perguntas e respostas. Uma pergunta abordou especificamente a tensão entre o aumento dos gastos e o medo de uma correção do mercado:

“Em meio a investimentos significativos em Al e aos rumores do mercado sobre um potencial estouro da bolha de Al, como estamos pensando em garantir a sustentabilidade e a lucratividade a longo prazo se o mercado de Al não amadurecer como esperado?”

A defesa de Pichai repousa no balanço da empresa. Ele argumentou: “Estamos melhor posicionados para resistir, você sabe, a erros do que outras empresas.”

Defensivamente, a lógica postula que o risco de subinvestir – e potencialmente se tornar irrelevante – é existencial, enquanto o superinvestimento é meramente caro. O Google está efetivamente apostando que pode sobreviver aos concorrentes em uma guerra de atrito com uso intensivo de capital.

Realidade do mercado: o dilema do prisioneiro da IA

Coletivamente, as “Quatro Grandes” – Google, Microsoft, Amazon e Meta – deverão gastar mais de US$ 380 bilhões em infraestrutura este ano, de acordo com números citados pela CNBC. O CEO da Nvidia, Jensen Huang, rejeitou explicitamente a narrativa da “bolha” esta semana, citando uma demanda tangível, uma visão contra a qual o Google deve se proteger.

O concorrente OpenAI está enfrentando suas próprias dificuldades. Um memorando interno de Sam Altman que surgiu esta semana sugere que o líder da indústria está cada vez mais a lidar com as realidades económicas da expansão. Isso cria uma abertura para o Google aproveitar sua integração vertical.

Transferir o gargalo da disponibilidade de dados para velocidade e custo de geração de tokens puros é a “Era da Inferência”. A vantagem específica do Google reside em sua pilha de silício personalizada, potencialmente permitindo-lhe resistir melhor a uma guerra de preços esmagadora de margens do que aqueles que dependem exclusivamente de hardware Nvidia.

Lançamentos recentes de produtos, como Gemini 3 Pro e Gemini 3 Pro Image, impulsionam ainda mais essa demanda. Em última análise, o resultado depende se os recursos premium, como”Deep Think”e fluxos de trabalho de agente, podem gerar receita mais rapidamente do que a depreciação do hardware.

Apesar dos custos impressionantes envolvidos, o Google até agora parece comprometido com uma estratégia de”construa e eles virão”.