Meses depois de lançar as ferramentas de resumo baseadas no Gemini, o Google está enfrentando um novo escrutínio sobre como ele alimenta esses modelos de IA. Os relatórios indicam que a empresa ativou silenciosamente”recursos inteligentes”por padrão para usuários fora da Europa, concedendo permissão para verificar e-mails e anexos privados para potencialmente treinar seus sistemas de IA generativos.

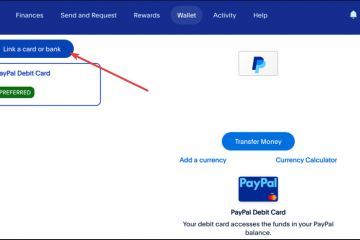

Essa mudança força uma difícil troca: os usuários devem permitir que seus dados sejam usados para melhoria do modelo ou desabilitar totalmente as principais ferramentas de produtividade, como sincronização de calendário e rastreamento de pacotes. sustenta a expansão agressiva da IA do Google.

A opção”silêncio”e a armadilha da utilidade

O YouTuber e blogueiro de tecnologia Dave Jones sinalizou uma mudança significativa nas configurações padrão do Google para usuários não europeus, marcando um afastamento da privacidade anterior normas.

No centro da controvérsia está a configuração”Recursos inteligentes e personalização”, que concede ao Google amplo acesso para verificar conteúdo de e-mail privado, registros de bate-papo e anexos.

Mensagem IMPORTANTE para todos que usam o Gmail.

Você foi automaticamente ATIVADO para permitir que o Gmail acesse todas as suas mensagens privadas e anexos para treinar modelos de IA.

Você precisa desativar manualmente os Recursos Inteligentes no menu Configurações em DOIS locais.Retweetar para que todos saibam. pic.twitter.com/54FKcr4jO2

— Dave Jones (@eevblog) 19 de novembro de 2025

Como Pieter Arntz da Malwarebytes notas, “sob o radar, o Google adicionou recursos que permitem ao Gmail acessar todas as mensagens privadas e anexos para treinar seus modelos de IA”, destacando a falta de alarde que acompanha o mudança.

Ao contrário de iterações anteriores de políticas de uso de dados, esta permissão está explicitamente ligada à “melhoria” dos modelos de IA generativos, levantando preocupações sobre se a correspondência pessoal está sendo usada para treinar modelos fundamentais como o Gemini.

A implementação cria o que os críticos chamam de “armadilha de utilidade”, onde o compartilhamento de dados está inextricavelmente acoplado às principais ferramentas de produtividade. Desativar a configuração de compartilhamento de dados de IA aciona uma série de recursos corrompidos, incluindo a Escrita inteligente, a criação automática de entradas de calendário a partir de e-mails e o rastreamento de pacotes.

Os usuários que tentam proteger seus dados devem passar por um processo complexo de desativação em duas etapas, desativando os “Recursos inteligentes no Gmail, Chat e Meet” e os “Recursos inteligentes no Google Workspace” para cortar totalmente o link de dados. Arntz observa:

“Para desativar totalmente, você deve desativar os’recursos inteligentes’do Gmail em dois locais separados em suas configurações. Não perca nenhum, ou o treinamento de IA pode continuar.”

O design da interface do usuário desencoraja ativamente a desativação, apresentando uma lista de avisos de funcionalidades que serão perdidas, criando um ultimato de”privacidade versus utilidade”.

Essa abordagem contrasta com os controles granulares frequentemente exigidos pelos defensores da privacidade, forçando os usuários a escolher entre uma caixa de entrada funcional e outra privada.

A fome de dados: por que o Google precisa da sua caixa de entrada

A documentação de suporte oficial do Google descreve a base legal para esse processamento, que inclui o “desenvolvimento de novos produtos e recursos”.

A empresa declara que”ao ativar os recursos inteligentes no Gmail, Chat e Meet, você concorda em permitir que o Gmail, o Chat e o Meet usem seu conteúdo e atividade nesses produtos para personalizar sua experiência nesses aplicativos”, enquadrando o acesso aos dados como um componente necessário do contrato de serviço.

“Para melhorar nossos serviços. Se você ativou alguma das configurações de recursos inteligentes, também poderemos processar o conteúdo e a atividade do seu espaço de trabalho para melhorar esses recursos.”

“Processando informações para essa finalidade é necessária para os interesses legítimos do Google e de nossos usuários em: Fornecer, manter e melhorar serviços… Desenvolver novos produtos e recursos… Realizar pesquisas que beneficiem nossos usuários e o público.”

A ambiguidade da”personalização”, que pode incluir modelos locais de”ajuste fino”(para o benefício do usuário) e modelos fundamentais de”treinamento”(para o benefício do Google) continua sendo um ponto crítico de discórdia. Embora o Google afirme que os dados são usados para “melhorar” os recursos, a falta de uma distinção clara deixa aberta a possibilidade de que os dados do usuário contribuam para a inteligência mais ampla do ecossistema Gemini.

Uma “divisão de privacidade” se formou com base na geografia: o Google confirma que essas configurações estão desativadas por padrão no EEE, no Reino Unido, na Suíça e no Japão devido a regulamentações mais rígidas como o GDPR.

“Ao ativar recursos inteligentes no Google Workspace, você concorda em permitir O Google Workspace usa o conteúdo e a atividade do Workspace para personalizar sua experiência no Workspace.”

“Quando você desativa essa configuração, não é possível usar as experiências listadas acima nos produtos do Google Workspace. Para continuar a usar essas experiências, é necessário reativar a configuração.”

Para usuários nos Estados Unidos, sem proteções federais semelhantes, a postura padrão é a inclusão no ecossistema de compartilhamento de dados. A disparidade destaca como a pressão regulatória, e não a benevolência corporativa, dita a postura de privacidade padrão das grandes empresas de tecnologia.

O contexto histórico destaca os riscos de implantação desses modelos em dados privados: o bug de tradução da IA do Google Gmail de julho de 2025 serve como um conto de advertência. Nesse incidente, Gemini traduziu erroneamente e-mails em alemão, transformando um “ás” político em um “burro”, causando danos significativos à reputação dos editores.

Apesar desses riscos, o impulso da indústria sugere que a coleta de dados está se tornando o custo padrão de entrada para serviços gratuitos.

Ron Richards, do podcast Android Faithful, descreveu a tendência mais ampla no início deste ano, dizendo “esse navio partiu. vá embora”, refletindo uma crescente resignação entre os observadores de tecnologia de que a integração da IA é inevitável.

Privacidade como um produto de luxo

Está surgindo uma segmentação de mercado distinta, onde a privacidade está se tornando um recurso premium em vez de um direito padrão. Concorrentes como a Perplexity estão aproveitando isso ao oferecer um plano “Max” de US$ 200/mês que promete explicitamente não treinar modelos com base em dados do usuário.

Isso contrasta fortemente com o modelo gratuito e apoiado por anúncios do Google, que depende da monetização de dados do usuário por meio de anúncios ou treinamento de modelo. Pieter Arntz argumentou que “a falta de consentimento explícito parece um retrocesso para as pessoas que desejam controlar como seus dados pessoais são usados”, apontando para a erosão da agência do usuário diante das configurações padrão.