Quase um mês depois de apresentar o Copilot Actions como a peça central de sua estratégia de “AI PC”, a Microsoft emitiu uma admissão alarmante de que a tecnologia introduz “novos riscos de segurança” capazes de comprometer sistemas inteiros.

Em uma atualização silenciosa para apoiar a documentação que acompanha o lançamento do recurso Insider, a empresa alertou que os invasores podem explorar esses agentes por meio de injeção cruzada (XPIA) para exfiltrar dados ou instalar malware. A divulgação efetivamente transfere a responsabilidade para os usuários, gerando críticas imediatas de pesquisadores de segurança que comparam a vulnerabilidade a macros inseguras do Office.

Após nossa cobertura das ações iniciais do Copilot anunciadas em outubro, onde a Microsoft prometeu um “desbloqueio mágico” perfeito para produtividade, a realidade da implementação se mostrou muito mais complexa.

Embora a empresa continue a comercializar o “AI PC” como um parceiro seguro, a documentação recém-atualizada revela advertências significativas que estavam ausentes na campanha de marketing inicial.

Uma admissão silenciosa de ‘novos riscos de segurança’

Enterrado na documentação de suporte atualizada que acompanha o lançamento de 17 de novembro para o Windows Insiders está um aviso que altera fundamentalmente o perfil de risco do uso IA de agente.

A Microsoft reconheceu explicitamente que “aplicativos de IA de agente apresentam novos riscos de segurança, como injeção de prompt cruzado (XPIA), onde conteúdo malicioso incorporado em elementos de UI ou documentos pode substituir as instruções do agente, levando a ações não intencionais, como exfiltração de dados ou instalação de malware.” Como o agente foi projetado para agir em nome do usuário, ele pode ser induzido a executar comandos que o usuário nunca autorizou.

Além da ameaça de manipulação externa, a documentação também admite que os próprios modelos permanecem propensos a erros.

A Microsoft observa que “os modelos de IA ainda enfrentam limitações funcionais em termos de como se comportam e, ocasionalmente, podem ter alucinações e produzir resultados inesperados”. Essas “limitações funcionais” significam que, mesmo sem interferência maliciosa, o agente pode interpretar mal um comando ou alucinar uma tarefa, potencialmente excluindo arquivos ou enviando e-mails erroneamente.

Crucialmente, a Microsoft enquadrou esses riscos como uma responsabilidade do usuário. Aconselhando os clientes a agirem com cautela, a página de suporte sugere ativar o recurso apenas “se você entender as implicações de segurança descritas nesta página”.

Ao colocar sobre o usuário o ônus de “entender” vetores de ataque complexos como o XPIA, a empresa parece estar se protegendo preventivamente de responsabilidades caso esses recursos experimentais levem a violações de dados ou comprometimento do sistema.

‘Macros no Marvel Superhero Crack’

Ecoing Apesar dos pesadelos de segurança que assolaram as versões anteriores do Office, os especialistas foram rápidos em criticar o modelo de defesa “opt-in”.

Durante décadas, as macros do Office serviram como principal vetor de infecção por malware porque os usuários, motivados pelas necessidades de produtividade, as habilitavam apesar dos avisos de segurança.

Kevin Beaumont, um proeminente pesquisador de segurança, traçou um paralelo direto com essa história, afirmando que o novo recurso são “macros no crack de super-heróis da Marvel”.

Os críticos argumentam que o “controle” que a Microsoft promete é em grande parte ilusório para o usuário médio. Detectar um ataque XPIA em tempo real é tecnicamente impossível para a maioria das pessoas, já que o prompt malicioso é muitas vezes invisível ao olho humano, mas perfeitamente legível para a IA.

Guillaume Rossolini, outro pesquisador de segurança, apontou a futilidade de pedir aos usuários que policiem essas interações, observando“Não vejo como os usuários irão impedir algo do tipo a que estão se referindo, além de não navegar na web, eu acho.”

Reed Mideke caracterizou o aviso como pouco mais do que uma manobra legal. Ele argumentou que a indústria carece de uma solução técnica para injeção imediata.”A solução? Transferir a responsabilidade para o usuário”, escreveu Mideke, observando,”não importa que você não precisaria do chatbot em primeiro lugar se soubesse a resposta.”

Esse ceticismo reflete uma preocupação mais ampla na comunidade de segurança com os recursos”agentic”estão sendo lançados no mercado antes que as vulnerabilidades fundamentais dos Large Language Models (LLMs) tenham sido resolvidas.

Arquitetura e implementação: a realidade do ‘espaço de trabalho do agente’

Apesar da fanfarra em torno da revelação inicial do “AI PC”, a implementação técnica desses agentes é notavelmente cautelosa. De acordo com o blog do desenvolvedor Ignite 2025, o novo “Espaço de trabalho do agente”opera como uma sessão paralela do Windows com autorização de escopo, em vez de do que uma máquina virtual ou sandbox totalmente isolada.

Equilibrando desempenho com segurança, essa escolha de arquitetura fica aquém do isolamento rigoroso que alguns especialistas esperavam.

Para mitigar os riscos recentemente divulgados, a Microsoft restringiu o acesso do sistema de arquivos do agente a seis pastas específicas de perfil de usuário: Documentos, Downloads, Área de Trabalho, Música, Imagens e Vídeos. Projetada para evitar que agentes comprometidos acessem arquivos críticos do sistema, essa limitação visa conter possíveis danos em áreas acessíveis ao usuário.

Navjot Virk, vice-presidente corporativo de experiências do Windows da Microsoft, tentou gerenciar as expectativas durante o anúncio inicial, alertando que “no começo você pode ver o agente cometer alguns erros ou encontrar alguns desafios ao tentar usar alguns aplicativos realmente complexos”.

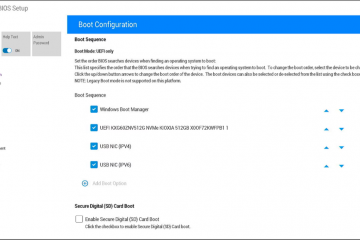

Atualmente, o recurso é lançamento para Windows Insiders no Dev Channel, permanecendo desativado por padrão e exigindo privilégios de administrador para alternar. Sugerindo uma forte consciência de possíveis reações adversas, esta estratégia de implementação provavelmente visa evitar uma repetição do desastre em torno do controverso recurso Recall, que foi retirado depois que os pesquisadores expuseram graves falhas de privacidade.