Menos de quatro meses depois de lançar seu Segment Anything Model 2, focado em vídeo, a Meta lançou o SAM 3 e o SAM 3D, implantando imediatamente os modelos avançados de visão computacional em produtos de consumo como Facebook Marketplace e Instagram.

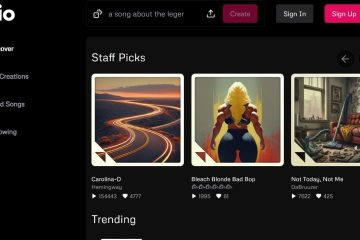

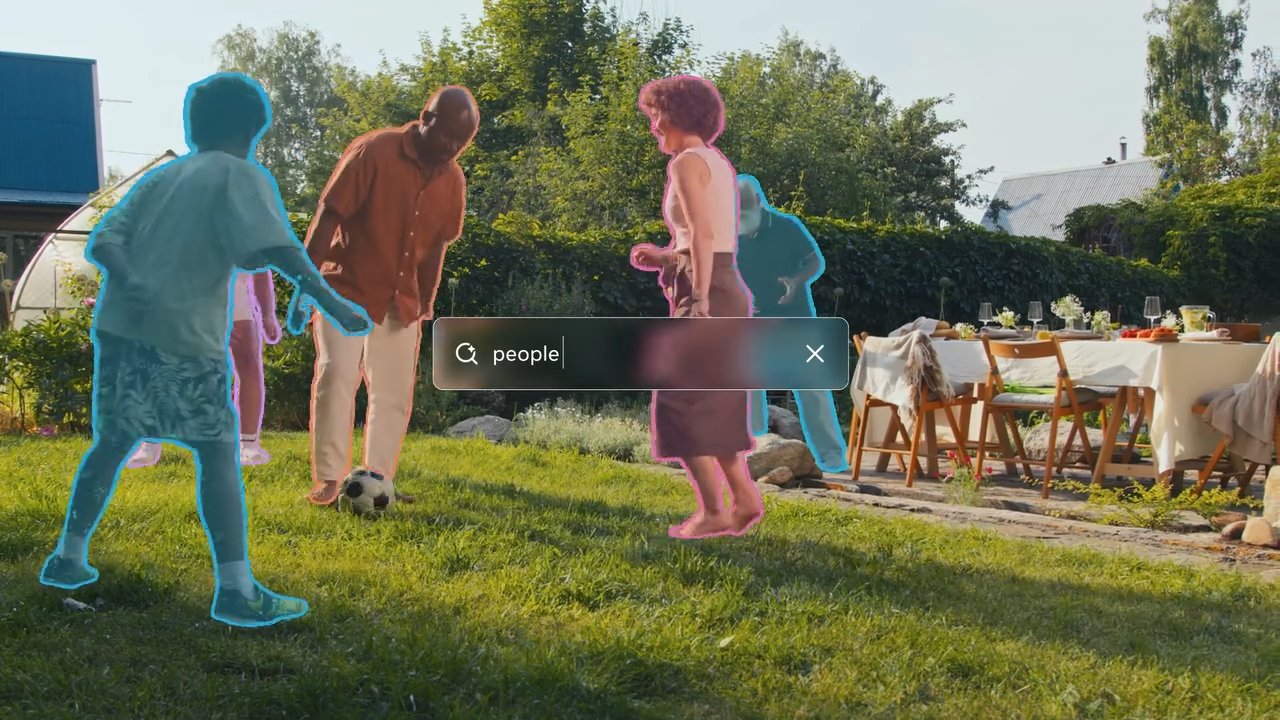

Ambas as ferramentas dão aos computadores uma compreensão muito melhor do que estão vendo. O SAM 3 permite que os usuários digitem uma descrição, como “boné de beisebol vermelho”, e façam com que a IA encontre e destaque instantaneamente cada objeto correspondente em uma foto ou vídeo.

O SAM 3D vai um passo além ao obter uma imagem plana e bidimensional e prever a aparência do objeto de outros ângulos, transformando efetivamente uma foto padrão em um modelo 3D giratório.

Embora as iterações anteriores tenham permanecido em grande parte no domínio da pesquisa, esta atualização marca uma rápida mudança para a utilidade aplicada, potencializando recursos que permitem aos usuários visualizar móveis em suas casas ou aplicar efeitos a objetos específicos em vídeos.

Os novos modelos introduzem a “Segmentação de Conceito Promptável”, permitindo a identificação baseada em texto de todos os objetos correspondentes em uma cena e a reconstrução 3D de alta fidelidade a partir de imagens 2D únicas – recursos que as reivindicações da Meta superam os benchmarks existentes por uma ampla margem.

O lançamento de 2024 do SAM 2 se concentrou fortemente na eficiência da segmentação de vídeo, mas o anúncio de hoje amplia significativamente o escopo para incluir compreensão semântica e geração 3D.

Da pesquisa ao produto: integração imediata

Rompendo com o ciclo tradicional da pesquisa até o produto, a Meta está contornando a típica fase de incubação para integrar o SAM 3 diretamente em seus principais aplicativos.

Os usuários do Facebook Marketplace agora encontrarão um recurso”Ver no quarto”desenvolvido pelo SAM 3D, que permite que compradores em potencial visualizem como os itens de mobiliário ficariam em seus próprios espaços antes de se comprometerem com uma compra.

Esse aplicativo aproveita a capacidade do modelo de reconstruir objetos 3D a partir de um único 2D. imagens, abordando um ponto de atrito comum no comércio on-line.

Simultaneamente, o aplicativo “Edits” do Instagram e o recurso “Vibes” do Meta AI estão utilizando o SAM 3 para permitir efeitos de vídeo precisos e específicos do objeto. Os criadores agora podem aplicar modificações como destaque ou trilhas de movimento a assuntos específicos dentro de um quadro de vídeo, tarefas que antes exigiam máscaras complexas em software de edição profissional.

Visualizar em threads

Ao automatizar esses processos, o Meta visa tornar os efeitos visuais avançados comoditizadores, tornando-os acessíveis como utilitários padrão para usuários casuais.

Para facilitar uma experimentação mais ampla, a empresa lançou o “Segment Anything Playground”, um interface baseada na web que permite ao público testar esses modelos sem conhecimento técnico.

Os usuários podem fazer upload de imagens ou vídeos e solicitar ao sistema descrições de texto para ver os recursos de segmentação em tempo real. Essa estratégia contrasta fortemente com o lançamento do SAM 2, que permaneceu principalmente como uma ferramenta para a comunidade de pesquisa de visão computacional.

A implantação imediata em aplicativos de consumo sugere um pivô estratégico para aproveitar os avanços da IA para retenção e engajamento de usuários em todo o ecossistema social da Meta.

Salto técnico: segmentação de conceito e 3D

SAM 3 introduz um recurso significativo denominado “Segmentação de Conceito Promptável”(PCS). Ao contrário de seus antecessores, que se concentravam na segmentação de objetos únicos com base em avisos visuais, como cliques ou caixas, o SAM 3 pode identificar e mascarar todas as instâncias de um conceito descrito por texto.

Por exemplo, um usuário pode solicitar ao modelo um “boné de beisebol vermelho” e ele segmentará todos os itens correspondentes no quadro. Essa mudança exige que o modelo possua compreensão semântica do texto e recursos precisos de localização.

Para conseguir isso, a arquitetura separa o reconhecimento da localização usando um “token de presença”. Esse mecanismo primeiro determina se um conceito existe dentro do quadro antes que o modelo tente segmentá-lo, reduzindo falsos positivos e melhorando a precisão geral da detecção.

De acordo com a Meta Research Team, “SAM 3 dobra a precisão dos sistemas existentes em PCS de imagem e vídeo e melhora os recursos anteriores do SAM em tarefas de segmentação visual.”

Essa abordagem dupla permite que o modelo lide com consultas complexas, mantendo o alto desempenho em tarefas de segmentação padrão.

Meta Sam 3 segmenta qualquer coisa com conceitos.

Meta Sam 3 segmenta qualquer coisa com conceitos

Na geração 3D, o SAM 3D permite a reconstrução de objetos e cenas a partir de uma única imagem 2D, uma tarefa que tradicionalmente exigia vários pontos de vista ou dados de profundidade. A Meta afirma que este novo modelo supera significativamente os métodos existentes.

Visualização em threads

A equipe da Meta AI observa que “em testes de preferência humana frente a frente, ele atinge uma taxa de vitória de pelo menos 5:1 em relação a outros modelos líderes”. Isto é particularmente relevante para aplicações em realidade aumentada e jogos, onde a geração rápida de ativos é crucial.

As métricas de desempenho divulgadas pela Meta indicam que o SAM 3 é altamente eficiente. A Meta Research Team também afirma que “SAM 3 é executado em 30 milissegundos para uma única imagem com mais de 100 objetos detectados em uma GPU H200″. Essa velocidade é essencial para aplicações em tempo real em dispositivos de consumo, onde a latência pode degradar a experiência do usuário.

Para a reconstrução humana, o SAM 3D Body utiliza um novo formato de código aberto.

“SAM 3D Body… aproveita um novo formato de malha 3D de código aberto chamado Meta Momentum Human Rig (MHR), que oferece melhor interpretabilidade ao separar a estrutura do esqueleto e o formato dos tecidos moles.”

Essa separação permite uma interpretação mais realista e modelos humanos ajustáveis, que podem ter implicações para avatares virtuais e animações.

Apesar desses avanços, o modelo não está isento de limitações. A equipe Meta AI admite que “o SAM 3 se esforça para generalizar para conceitos refinados fora do domínio de maneira ininterrupta, como identificar termos específicos que exigem conhecimento de domínio como ‘plaqueta’.”

Isso sugere que, embora o modelo seja robusto para objetos comuns, ele pode exigir ajuste fino ou dados adicionais para lidar com categorias especializadas ou raras de maneira eficaz.

Mecanismo de dados e benchmarking

Aproveitando um mecanismo de dados híbrido, o Meta conseguiu dimensionar significativamente seus dados de treinamento. A empresa desenvolveu um sistema usando “anotadores de IA” baseados em Llama para verificar máscaras e verificar a exaustividade, uma tarefa que seria proibitivamente lenta apenas para humanos.

Meta explica que “ao delegar certas tarefas a anotadores de IA – modelos que correspondem ou superam a precisão humana – mais do que duplicamos o rendimento em comparação com um pipeline de anotação apenas humano”.

Essa abordagem permitiu a criação do conjunto de dados SA-Co, que contém mais de 4 milhões de conceitos exclusivos. e 52 milhões de máscaras, proporcionando um rico campo de treinamento para os novos modelos.

Juntamente com os modelos, a Meta lançou o benchmark “Segment Anything with Concepts”(SA-Co). Este conjunto de dados apresenta 207.000 conceitos exclusivos projetados para testar capacidades de reconhecimento de vocabulário aberto, empurrando o padrão da indústria para avaliação.

O mecanismo de dados também explora iterativamente “negativos concretos” – frases que não existem em uma imagem, mas são adversárias ao modelo – para melhorar a robustez contra falsos positivos.

Além dos aplicativos de consumo, a tecnologia está encontrando aplicações em pesquisas científicas. Uma parceria com a Conservation X Labs aplicou o SAM 3 ao conjunto de dados SA-FARI, auxiliando no monitoramento automatizado da vida selvagem por meio de segmentação de vídeo. Este caso de uso demonstra a utilidade potencial do modelo no processamento de grandes volumes de dados de vídeo não selecionados para fins de pesquisa.

O lançamento inclui pesos de modelo, código e conjuntos de dados de avaliação, dando continuidade à estratégia da Meta de abrir o código-fonte das principais tecnologias de IA. Ao disponibilizar essas ferramentas, a Meta pretende estabelecer padrões da indústria e incentivar um maior desenvolvimento dentro da comunidade de IA.

O trabalho futuro se concentrará em melhorar a capacidade do modelo de lidar com consultas de raciocínio complexas, combinando SAM 3 com Modelos Multimodais de Grandes Linguagens (MLLMs), potencialmente permitindo interações ainda mais sofisticadas.