A Microsoft aparentemente está desenvolvendo novas ferramentas de software para executar o software de IA da NVIDIA em chips AMD mais baratos, de acordo com comentários de um suposto funcionário que surgiram esta semana.

Reduzir o alto custo das cargas de trabalho de IA, também conhecido como inferência, desafiaria diretamente o domínio de longa data da NVIDIA.

Essas ferramentas supostamente funcionariam convertendo o código da plataforma CUDA proprietária da NVIDIA para o formato ROCm de código aberto da AMD. Se for verdade, a estratégia refletiria uma tendência mais ampla da indústria, à medida que gigantes da tecnologia como a Oracle e a OpenAI aumentam a sua dependência do hardware AMD para fomentar a concorrência.

Uma arma secreta contra o domínio da IA da NVIDIA?

As reivindicações do novo kit de ferramentas se originam de uma transcrição que circula on-line que, embora não confirmada pela Microsoft, parece ser do Third Bridge Forum, uma rede de especialistas respeitável que fornece entrevistas com acesso pago para clientes institucionais.

Nele, um indivíduo anônimo considerado um especialista da Microsoft alega que a empresa está trabalhando ativamente para preencher a lacuna entre o software proprietário da NVIDIA e o hardware de seus concorrentes.

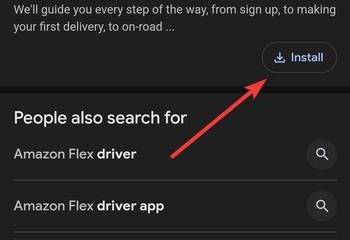

Na transcrição compartilhada via captura de tela no X, o palestrante afirmou a existência de projetos internos projetados para enfrentar esse desafio de frente.

“Nos últimos três a quatro meses, houve muito mais interesse em economizar custos com inferência. Criamos alguns kits de ferramentas para ajudar a converter modelos CUDA em ROCm para que você possa usá-los em um AMD, como um 300X.

Recebemos muitas perguntas sobre qual é o nosso caminho com a AMD, o 400X e o 450X. Estamos trabalhando ativamente com a AMD nisso para ver como maximizar isso. O maior desafio que eu diria que estamos enfrentando agora, especialmente com servidores mais novos, é apenas descobrir a densidade no rack e obter refrigeração líquida no rack.”

Postagem do Alledged Third Bridge Forum (Fonte: @Jukanlosreve/X)

Esse kit de ferramentas funcionaria efetivamente como uma camada de tradução, permitindo que modelos de IA originalmente construídos para o ecossistema da NVIDIA rodassem no hardware da AMD sem exigir uma reescrita completa e cara.

Durante anos, os modelos de IA da NVIDIA foram executados A plataforma CUDA tem sido uma plataforma poderosa e uma gaiola de ouro para desenvolvedores de IA. Como uma plataforma de computação paralela cujas bibliotecas robustas a tornaram o padrão do setor, a CUDA criou um poderoso “fosso” que dificulta a conquista de participação de mercado pelos concorrentes.

Se confirmado, o esforço da Microsoft seria um ataque direto a esse fosso. Embora o ROCm da AMD seja uma alternativa de código aberto capaz, um caminho de conversão confiável permitiria que os clientes do Azure da Microsoft obtivessem os benefícios de custo do hardware AMD sem abandonar o ambiente CUDA familiar.

Opções para executar CUDA com chips AMD já estão disponíveis, como o conjunto de ferramentas GPGPU da SCALE ou o Ferramenta ZLUDA, que intercepta chamadas CUDA. No entanto, a perda de eficiência devido à conversão continua a ser um obstáculo constante que a Microsoft aparentemente quer enfrentar.

Um jogo de poupança de custos para o boom de inferência de IA

Impulsionados pelo aumento das despesas das operações de IA, os gigantes tecnológicos estão agora a perseguir agressivamente medidas de redução de custos. O palestrante na transcrição destacou que a principal motivação por trás do suposto kit de ferramentas é financeira, especialmente para o estágio de inferência da IA, onde modelos treinados são colocados em funcionamento.

À medida que os serviços de IA se expandem para milhões de usuários, a inferência é responsável por uma grande parte dos custos operacionais.

Um interesse crescente na eficiência de custos torna as GPUs com preços mais competitivos da AMD uma alternativa atraente ao hardware de preço premium da NVIDIA, desde que a barreira do software possa ser superada.

Além do software e do chip custos, as restrições dos data centers físicos estão se tornando um gargalo crítico. A fonte na transcrição observou que o desafio fundamental não é mais apenas garantir eletricidade suficiente, mas gerenciá-la de forma eficaz.

Seu foco na densidade de energia e refrigeração líquida destaca as imensas demandas de alojamento de aceleradores de IA de próxima geração.

O esforço de toda a indústria para quebrar o estrangulamento CUDA

A alegada estratégia da Microsoft se alinharia com um esforço significativo em toda a indústria para cultivar uma cadeia de fornecimento de hardware de IA mais competitiva. Para a NVIDIA, cuja liderança de mercado se baseia tanto no seu software como no seu silício, esta tendência representa uma ameaça a longo prazo.

A Oracle, um interveniente-chave na infraestrutura em nuvem, anunciou recentemente uma grande parceria para implementar 50.000 chips AMD AI. Karan Batta, vice-presidente sênior da Oracle Cloud, apontou explicitamente o valor dessa alternativa para cargas de trabalho sensíveis ao custo.

O laboratório líder de pesquisa em IA, OpenAI, também está tomando medidas decisivas para diversificar sua base de computação. Ela firmou um acordo multibilionário definitivo com a AMD para implantar 6 gigawatts de suas GPUs.

Sua parceria inclui uma garantia única para até 160 milhões de ações, o que poderia dar à OpenAI uma participação acionária de aproximadamente 10% na fabricante de chips, alinhando profundamente seus objetivos.

Essa tendência de “coopetição” se estende até mesmo a rivais históricos. A Intel está em negociações para fabricar chips para a AMD, destacando a importância estratégica de uma cadeia de fornecimento diversificada de semicondutores.

Se as afirmações sobre o kit de ferramentas da Microsoft forem precisas, a empresa não está apenas trabalhando para resolver um problema de custos internos, mas também contribuindo para uma evolução mais ampla do mercado. Um kit de ferramentas de conversão bem-sucedido poderia sinalizar um futuro de desenvolvimento de IA independente de hardware, libertando os desenvolvedores da dependência de fornecedores.

Essa mudança potencial marcaria uma nova fase de maturação para toda a indústria de IA, passando de uma frenética apropriação de terras computacionais para um ecossistema mais estratégico e multipolar.