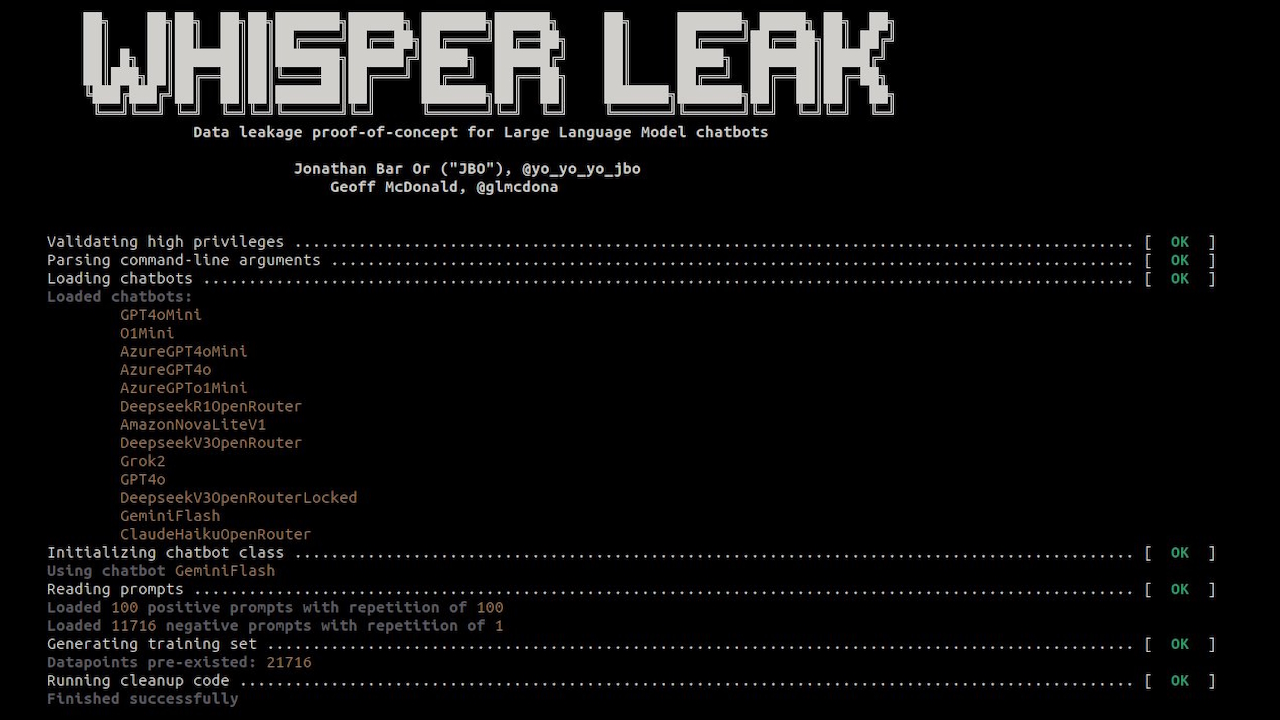

Pesquisadores da Microsoft detalharam um novo ataque de canal lateral chamado “Whisper Leak”, que pode adivinhar o tópico de bate-papos criptografados de IA, expondo um risco fundamental à privacidade em todo o setor de IA.

Em um relatório, a equipe mostrou como os padrões no tamanho e no tempo do tráfego de rede podem revelar o que os usuários estão discutindo, mesmo com criptografia TLS. A falha afeta 28 modelos principais de IA, criando um sério risco de privacidade para usuários em todo o mundo. Um observador em uma rede pode detectar conversas delicadas sobre tópicos jurídicos ou de saúde.

Após um processo de divulgação que começou em junho, grandes provedores como OpenAI e Microsoft começaram a implantar correções, mas o problema aponta para um risco central no streaming de IA.

Como o Whisper Leak Escutas em bate-papos criptografados por IA

A engenhosidade do ataque reside em sua capacidade de funcionar sem quebrar a criptografia TLS subjacente que protege as comunicações on-line. Em vez disso, ele explora os metadados que a criptografia deixa inerentemente expostos.

De acordo com a documentação do projeto, “Whisper Leak é um kit de ferramentas de pesquisa que demonstra como conversas criptografadas e em streaming com modelos de linguagem grande vazam informações imediatas por meio de tamanhos e tempo de pacote.” transmitido para um usuário. Cada tópico, desde análise jurídica até conversa casual, gera texto com vocabulário e estruturas de frases distintas. Esses padrões linguísticos produzem uma “impressão digital” característica no tráfego de rede.

Analisando sequências de tamanhos de pacotes e tempos entre chegadas, os pesquisadores construíram classificadores para reconhecer essas impressões digitais com alta precisão.

O kit de ferramentas público do projeto confirma isso método, que usa modelos de aprendizado de máquina para aprender as assinaturas sutis de diferentes tipos de conversa. Mesmo com conteúdo embaralhado, os padrões de tráfego revelam o assunto da conversa.

Uma falha em todo o setor que afeta 28 modelos principais de IA

O Whisper Leak não é um bug isolado, mas uma vulnerabilidade sistêmica que afeta uma ampla faixa da indústria de IA. A equipe da Microsoft testou 28 LLMs disponíveis comercialmente e descobriu que a maioria era altamente suscetível.

Para muitos modelos, o ataque alcançou uma classificação quase perfeita. Os pesquisadores observaram em uma postagem no blog: “Isso nos diz que as ‘impressões digitais’ digitais únicas deixadas pelas conversas sobre um tópico específico são distintas o suficiente para que nosso bisbilhoteiro alimentado por IA as detecte de forma confiável em um teste controlado.”

Para empresas que dependem de IA para comunicações confidenciais, as descobertas representam um vetor de ameaça novo e desafiador. A pesquisa demonstrou uma precisão alarmante em condições realistas.

Em uma simulação com uma proporção de 10.000 para 1 de ruído de fundo para conversas alvo, o ataque identificou tópicos sensíveis com 100% de precisão para 17 dos 28 modelos, enquanto ainda detectava de 5 a 20% de todas as conversas alvo.

Um adversário de rede passivo, como um ISP, uma agência governamental ou um invasor em uma rede Wi-Fi pública, poderia identificar usuários de maneira confiável. discutir questões confidenciais jurídicas, financeiras ou de saúde.

Esse recurso transforma chats criptografados de IA em uma fonte potencial para vigilância direcionada. Como afirmam os pesquisadores, “Essa vulnerabilidade em todo o setor representa riscos significativos para usuários sob vigilância de rede por ISPs, governos ou adversários locais.”96,0% 59,5% 100,0% microsoft-deepseek-r1 98,6% 98,9% 46,3% 99,9% 99,9% 61,0% 94,8% 95,5% 56,8% 99,9% xai-grok-3-mini-beta 99,1% 98,8% 73,0% 99,9% 99,9% 73,2% 97,2% 97,5% 74,9% 99,9% mistral-pequeno 98,3% 97,6% 60,7% 99,9% 99,8% 65,1% 94,1% 94,3% 61,3% 99,9% groq-llama-4-maverick 99,3% 99,2% 52,9% 99,6% 99,7% 56,4% 93,6% 94,2% 60,4% 99,7% deepseek-deepseek-r1 98,8% 98,6% 46,5% 99,3% 99,4% 62,5% 96,7% 96,9% 65,4% 99,4% alibaba-qwen2.5-plus 98,0% 97,7% 66,3% 99,1% 99,0% 63,5% 97,1% 97,3% 67,4% 99,1% xai-grok-2 99,0% 98,8% 66,9% 98,5% 98,7% 70,1% 93,2% 94,9% 72,9% 99,0% alibaba-qwen2,5-turbo 97,2% 96,8% 71,9% 97,5% 97,6% 71,8% 99,0% 98,9% 71,2% 99,0% openai-o1-mini 97,8% 98,0% 58,7% 98,9% 98,9% 62,1% 97,0% 96,9% 64,6% 98,9% openai-gpt-4o-mini 97,5% 97,8% 76,7% 98,2% 98,3% 75,4% 98,6% 98,6% 72,6% 98,6% deepseek-deepseek-v3-chat 98,3% 98,0% 58,6% 98,1% 98,1% 59,7% 97,6% 97,6% 60,6% 98,3% openai-gpt-4.1-mini 96,8% 96,6% 78,5% 97,3% 98,0% 77,6% 97,4% 97,3% 76,3% 98,0% lambda-llama-3.1-8b-instruir 96,8% 97,5% 59,9% 76,3% 97,8% 68,3% 91,9% 92,5% 59,6% 97,8% lambda-llama-3.1-405b 97,7% 97,5% 62,6% 93,2% 96,6% 66,8% 95,5% 95,6% 62,0% 97,7% groq-llama-4-scout 97,6% 97,3% 60,3% 68,5% 70,0% 64,8% 89,0% 89,6% 57,4% 97,6% openai-gpt-4.1-nano 96,1% 96,8% 77,8% 97,1% 97,1% 75,5% 96,2% 96,4% 77,1% 97,1% microsoft-gpt-4o-mini 93,4% 93,2% 77,8% 88,5% 81,3% 81,8% 91,3% 91,5% 77,2% 93,4% antrópico-claude-3-haiku 90,2% 76,8% 78,7% 91,2% 80,1% 80,0% 87,9% 74,5% 77,9% 91,2% microsoft-gpt-4.1-nano 89,5% 91,0% 84,0% 88,1% 82,4% 85,4% 86,6% 86,9% 80,5% 91,0% microsoft-gpt-4o 89,9% 90,1% 78,0% 87,2% 81,4% 83,0% 87,3% 87,9% 77,7% 90,1% microsoft-gpt-4.1-mini 89,7% 89,4% 75,4% 86,7% 80,4% 78,9% 86,6% 87,3% 76,0% 89,7% google-gemini-2.5-pro 77,1% 74,3% 78,1% 83,1% 76,3% 82,4% 84,0% 78,5% 83,4% 84,0% google-gemini-1.5-flash 81,0% 76,2% 80,2% 82,4% 78,3% 81,6% 83,5% 81,6% 82,8% 83,5% google-gemini-1.5-flash-light 79,9% 74,6% 79,4% 79,7% 75,5% 79,0% 81,9% 77,8% 81,4% 81,9% amazon-nova-pro-v1 46,2% 57,9% 46,6% 77,5% 74,9% 57,3% 60,9% 60,6% 57,6% 77,5% microsoft-phi-3.5-mini-moe-instruct 70,0% 70,0% 75,3% 75,3% 72,1% 76,9% 75,9% 72,5% 74,4% 76,9% amazon-nova-lite-v1 67,6% 68,3% 63,2% 71,2% 70,5% 67,7% 65,8% 65,5% 65,1% 71,2% Média 96,8% 96,8% 70,9% 93,2% 97,1% 71,8% 92,5% 93,3% 69,7% nan%

Desempenho de ataque (AUPRC) em LLMs alvo hospedados pelos provedores especificados e conjuntos de recursos e arquitetura de modelo de ataque. Números mais altos correspondem a uma maior eficácia do ataque de canal lateral. As métricas são calculadas como uma mediana em 5 tentativas, onde uma divisão aleatória é realizada por tentativa. A coluna’Melhor’também é a mediana dos 5 melhores testes dos modelos e conjuntos de recursos usados. (Fonte: Microsoft)

Uma solução difícil: mitigação e respostas inconsistentes dos fornecedores

A Microsoft iniciou um processo de divulgação responsável em junho de 2025, notificando todos os 28 fornecedores afetados. Em novembro, as respostas foram mistas.

Embora provedores como OpenAI, Microsoft, Mistral e xAI tenham tomado medidas para corrigir a falha, o relatório observa que outros fornecedores se recusaram a implementar correções ou permaneceram sem resposta.

Este incidente destaca uma inconsistência preocupante na forma como a indústria lida com novas ameaças nativas de IA. Isso ocorre após a recusa do Google em corrigir uma falha crítica de “contrabando de ASCII” em seus modelos Gemini, que foi classificada como um problema de engenharia social, e não como um bug de segurança. acidentes. A segurança protege você dos adversários.”A distinção é crítica à medida que os agentes de IA se tornam mais autônomos e integrados com dados confidenciais.

Corrigir vazamentos de metadados não é simples. Os investigadores avaliaram várias mitigações, cada uma com compromissos significativos. O preenchimento aleatório de dados, agora implementado por alguns provedores, adiciona ruído aos tamanhos dos pacotes, mas reduz apenas parcialmente o sucesso do ataque.

Outra estratégia, o lote de tokens, agrupa vários tokens antes de enviá-los, obscurecendo padrões individuais. Embora seja eficaz em lotes maiores, isso pode prejudicar a capacidade de resposta em tempo real de um chatbot, impactando a experiência do usuário.

Uma terceira opção, injetar pacotes de “ruído” sintéticos, também pode ofuscar os padrões de tráfego. Essa abordagem, no entanto, aumenta a sobrecarga de largura de banda, um custo significativo para os provedores.

O episódio mostra que, à medida que a IA se torna mais integrada em fluxos de trabalho confidenciais, proteger a privacidade do usuário exige olhar além da criptografia de conteúdo para proteger os próprios padrões de comunicação digital