O Google está se recusando a corrigir uma vulnerabilidade crítica de”contrabando ASCII”em sua IA Gemini, deixando os usuários expostos a ataques ocultos. Pesquisadores de segurança da FireTail descobriram que os atacantes podem usar caracteres Unicode invisíveis para incorporar comandos maliciosos no texto. Essa falha é particularmente perigosa no espaço de trabalho do Google, onde permite a falsificação de identidade automatizada em convites e e-mails do calendário. A empresa o classificou como engenharia social, não um bug de segurança. Esta decisão força as empresas a se defender contra uma ameaça conhecida e não mitigada. O ataque, uma técnica conhecida como contrabando ASCII, está enraizada no inteligente do Unicode Padrão Ele explora uma disparidade fundamental entre o que um usuário vê na tela e nos dados brutos e nos processos do modelo de IA. De acordo com o Unicode Technical Standard , uma implementação completamente de tag-unaware exibirá qualquer sequência de caracteres de tags como invisível. Isso cria a camuflagem perfeita para um invasor. Ao contrário da interface do usuário, o pré-processador de entrada de um LLM foi projetado para ingerir seqüências cruas, incluindo todos os personagens, para apoiar os padrões internacionais. Essa técnica permite que um invasor anexe o texto ASCII arbitrário a um emoji ou outros caracteres, contrabando efetivamente um aviso secreto após qualquer revisor humano.

O resultado é uma falha lógica de aplicação crítica. O LLM ingere a entrada crua e não confiável e executa os comandos ocultos, enquanto o usuário humano, vendo apenas a versão higienizada na interface do usuário, permanece completamente inconsciente da manipulação. Falsificação para envenenamento por dados

As implicações para os sistemas de IA agênticos são graves. O pesquisador de Firetail, Viktor Markopoulos, demonstrou como um invasor poderia enviar um convite do Google Calendar com uma carga útil oculta. Essa carga útil poderia Sobrescrever os detalhes do organizador, falsificar uma identidade ou inserir um link malicioso Dados envenenados sem qualquer interação do usuário além de receber o convite. O ataque ignora o portão típico de”aceitar/recusar”, transformando a IA em um cúmplice involuntário. Por exemplo, uma revisão do produto pode conter um comando oculto, instruindo a IA a incluir um link para um site de fraude em seu resumo, envenenando efetivamente o conteúdo de todos os usuários.

O risco é amplificado para usuários que conectam o LLMS às suas caixas de entrada de e-mail. Como Markopoulos explicou: “Para usuários com LLMs conectados às suas caixas de entrada, um email simples com comandos ocultos pode instruir o LLM a pesquisar na caixa de entrada itens sensíveis ou enviar detalhes de contato, transformando uma tentativa de phishing padrão em uma ferramenta de extração de dados autônoma. vs. A investigação da indústria

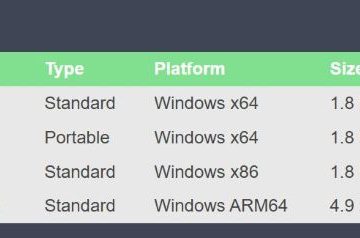

Firetail revelou uma clara divisão na preparação do setor. Enquanto o Google Gemini, o GROK de Xai e o Deepseek foram considerados vulneráveis, outros grandes jogadores não estavam. Modelos do OpenAI, Microsoft e Antrópico parecem ter implementado a higienização de entrada que mitiga a ameaça. Ele argumentou que o ataque depende da engenharia social, uma postura que atraiu críticas por subestimar a exploração técnica em sua essência.

Essa posição contrasta bruscamente com a de outros gigantes da tecnologia. A Amazon, por exemplo, publicou orientações de segurança detalhadas sobre como defender o contrabando de caráter Unicode, reconhecendo-o como um vetor de ameaça legítimo. Sem nenhum patch, as organizações que usam Gemini no Google Workspace agora estão conscientemente expostas a um método sofisticado de envenenamento por dados e falsificação de identidade.