O Google lançou um aprimoramento significativo de economia de custos para sua API de Gemini, introduzindo um cache implícito para seus modelos flash de Gemini 2.5 Pro e Gemini 2.5. Configuração.

Este novo recurso automatizado complementa o mecanismo de cache explícito existente, que Google introduzido pela primeira vez em maio de 2024 . Embora o cache explícito forneça um caminho para reduções de custo garantidas, exige que os desenvolvedores configurem e gerenciem manualmente o conteúdo em cache. Por outro lado, o cache implícito opera sem intervenção direta. O Google afirma que”passa diretamente a economia de custos de cache para os desenvolvedores sem a necessidade de criar um cache explícito”.

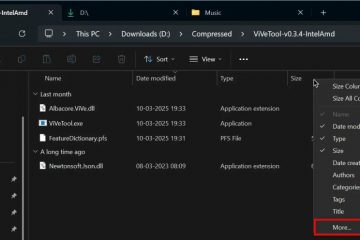

Para otimizar para essas economias automáticas, o Google aconselha os desenvolvedores a estruturar seus avisos, colocando conteúdo estável e comum no início, seguido de elementos variáveis, como perguntas específicas do usuário. Os desenvolvedores que usam os modelos Gemini 2.5 agora verão um `cached_content_token_count` nos metadados de uso da resposta da API, indicando a extensão dos tokens em cache usados e cobrados na taxa reduzida. Cache explícito Compare

O oficial Gemini API Documentação Mais esclarecimentos que implicam o cache é habilitado por defadão e não requerem nenhuma ação de desenvolvimento. Além da estruturação imediata, o envio de solicitações com prefixos semelhantes em sucessão rápida também pode aumentar a probabilidade de um acerto de cache. Esse método permite que os usuários defina conteúdo específico para armazenamento em cache e defina um tempo para viver (TTL)-diminuindo a uma hora se não especificado-o que determina a duração do armazenamento. O faturamento por cache explícito depende do número de tokens em cache e do TTL escolhido. As Google AI for Developers explains, “At certain volumes, using cached tokens is lower cost than passing in the same corpus of tokens repeatedly.”

Contextualizing Cost-Saving Measures in AI

Google’s introduction of implicit caching reflects a broader industry-wide effort to enhance the efficiency and reduce the financial barriers associated with deploying large-scale Modelos de IA.

Outras empresas também estão enfrentando esses desafios de vários ângulos. Por exemplo, a IBM Research revelou recentemente seu modelo BAMBA-9B-V2, uma arquitetura Hybrid Transformer-SSM projetada para atender às demandas computacionais dos transformadores tradicionais, particularmente em relação à redução do cache do KV. Raghu Ganti, da IBM, destacou que, para Bamba, “tudo volta à redução do cache do KV… mais taxa de transferência, menor latência, comprimento de contexto mais longo.”

No reino da eficiência do treinamento, a estrutura Zerosearch da Alibaba oferece um método para treinar LLMs para uma reversão de informações, simulando o mecanismo de busca interações, que oferecem um método para treinar um mecanismo de busca, simulando interações de mecanismos de busca, que href=”https://arxiv.org/html/2505.04588v1″Target=”_ Blank”> artigo científico , pode reduzir os custos de treinamento relacionados à API em até 88%. Essa abordagem, no entanto, requer servidores GPU para a simulação. Este método se concentra na redução dos requisitos de memória do modelo sem alterar a saída, um fator crucial para aplicações em que a precisão do bit-bit é fundamental, evitando assim as “complexidades que alguns usuários finais preferem evitar”com a quantização de perdas. (NAMMS), projetado para aumentar a eficiência do transformador em até 75%. O NAMMS podia dinamicamente os tokens menos críticos do cache KV durante a inferência, particularmente benéfico para gerenciar o Windows de contexto longo. The system utilizes neural networks trained via evolutionary optimization, a method Sakana AI researchers say, “Evolution inherently overcomes the non-differentiability of our memory management operations, which involve binary ‘remember’ or ‘forget’ outcomes,”

While Google claims up to 75% cost savings with its new implicit caching, third-party verification of these figures are currently not yet available , and actual savings could variar dependendo de padrões específicos de uso:

O sistema de cache manual anterior enfrentou críticas por às vezes ser difícil de usar e, ocasionalmente, levando a custos mais altos do que esperados. Apesar dessas considerações, a natureza automatizada do cache implícita é um passo claro para simplificar o gerenciamento de custos para desenvolvedores que se formam com Gêmeos. Opendools descreve a capacidade Como”inovador”, sugerindo que ele poderia pavimentar o caminho mais dinâmico de preços de serviço de AI.