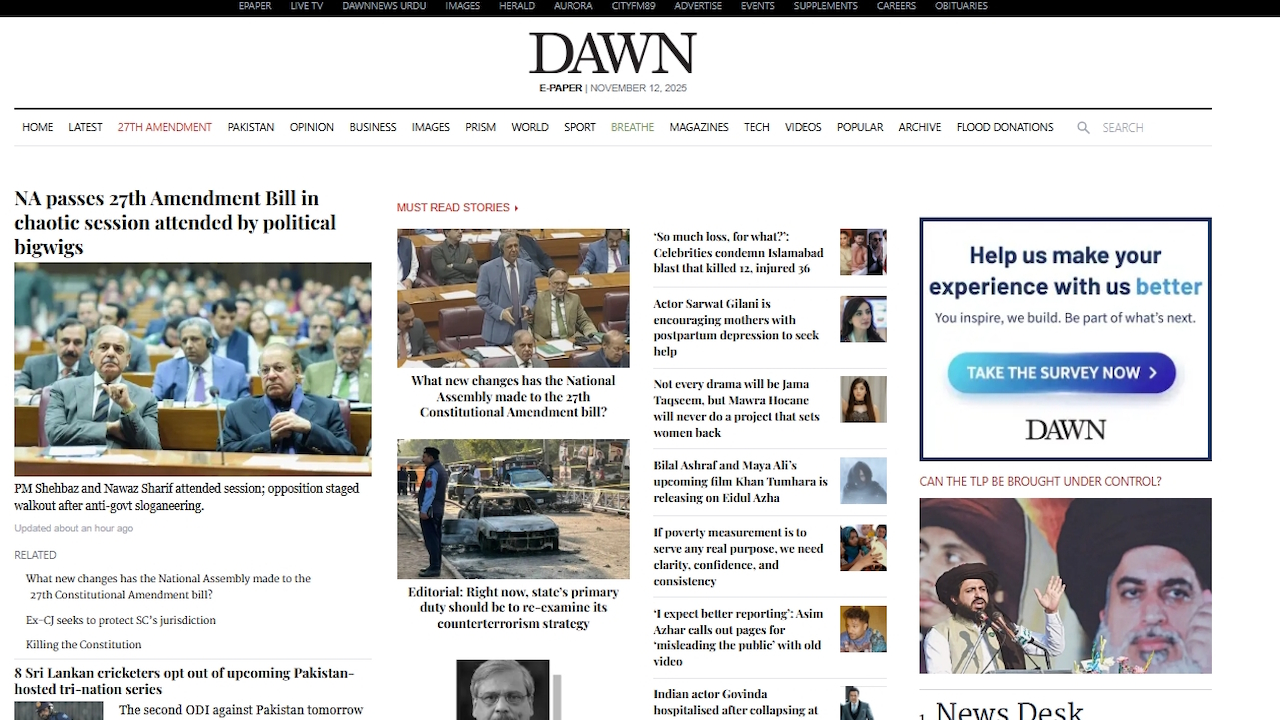

Um jornal paquistanês destacou o problema crescente de resultados não verificados de IA depois de imprimir por engano um texto tagarela de um chatbot. Na sua edição de 12 de novembro, Dawn incluiu uma mensagem gerada por IA para tornar o artigo obviamente gerado “mais rápido”, forçando um pedido público de desculpas por quebrar as suas próprias regras.

Tal erro não é um caso isolado, mas parte de uma tendência mais ampla de falhas de IA. Desde fontes jurídicas falsas utilizadas em tribunal até relatórios governamentais falhos, a pressa em adotar a IA generativa sem uma análise humana cuidadosa está a minar a confiança do público. É uma tendência que cria problemas sérios e reais para grandes instituições.

“Você quer que eu faça isso a seguir?”: a gafe pública de IA de um jornal

O altamente respeitado jornal de língua inglesa do Paquistão, Dawn, publicou um artigo sobre vendas de automóveis que terminou com um pós-escrito bizarro gerado por máquina. Em vez de um parágrafo final, o artigo apresentava uma peça clássica de chatbot.

A IA perguntou ao usuário: “Se você quiser, também posso criar uma versão ainda mais ágil no “estilo de primeira página”, com estatísticas contundentes de uma linha e um texto ousado e pronto para infográfico. layout – perfeito para máximo impacto no leitor. Você quer que eu faça isso a seguir?“

Sei que os jornalistas estão usando IA em seu trabalho, mas isso é um pouco demais!

A mesa de páginas de negócios do Dawn deveria ter editado pelo menos o último parágrafo!

😆😆😆 pic.twitter.com/JWNdHNWvnv

— omar r quraishi (@omar_quraishi) 12 de novembro de 2025

Identificada rapidamente pelos leitores, a gafe se espalhou rapidamente online, forçando o jornal a emitir uma correção e um pedido formal de desculpas. Numa nota anexada à versão online do artigo, o editor admitiu:”Esta reportagem de jornal foi originalmente editada usando IA, o que viola a atual política de IA da Dawn. … Lamentamos a violação da política de IA.“

Uma investigação sobre o incidente está supostamente em andamento. As diretrizes oficiais do jornal proíbem explicitamente o uso de IA para gerar ou editar notícias sem supervisão humana rigorosa.

Embora a gafe da Dawn tenha proporcionado um momento de constrangimento público, ela serve como um símbolo poderoso para uma questão muito mais profunda e com mais consequências. Em todos os setores, a implantação prematura de IA generativa sem supervisão adequada está levando a uma série de falhas de alto perfil, minando os padrões profissionais e a confiança pública.

Um problema sistêmico: quando a IA alucina em campos de alto risco

Em todos os campos profissionais, do direito à saúde pública, as organizações estão descobrindo da maneira mais difícil que grandes modelos de linguagem não são confiáveis para tarefas críticas. Conhecido como alucinação, o fenómeno em que uma IA inventa factos, fontes ou dados com confiança está a revelar-se uma falha persistente e perigosa.

Um exemplo recente e dispendioso vem do mundo da consultoria. A empresa global Deloitte foi forçada a reembolsar 97 mil dólares ao governo australiano depois de se ter descoberto que um relatório de 440 mil dólares que produziu estava repleto de citações fabricadas pela IA. A senadora trabalhista australiana Deborah O’Neill repreendeu duramente, afirmando:”A Deloitte tem um problema de inteligência humana. Isto seria ridículo se não fosse tão lamentável.”

Problemas graves também estão a surgir no sector público. Em julho, surgiram relatos de que a nova IA “Elsa” da Administração de Alimentos e Medicamentos dos EUA, destinada a acelerar a aprovação de medicamentos, estava, em vez disso, fabricando estudos médicos inexistentes. a empresa de IA Anthropic teve que pedir desculpas formalmente a um juiz depois que seu próprio Claude AI inventou uma citação legal usada em um processo judicial.

O jornalismo, em particular, tem visto repetidos casos desse descuido. Em um caso surpreendentemente semelhante ocorrido em outubro, a revista alemã Der Spiegel teve que corrigir um artigo que incluía uma frase perdida gerada por IA oferecendo-se para mudar o tom do texto.

Esses erros não se limitam a fazendas de conteúdo de baixo nível, mas estão aparecendo em meios de comunicação respeitados e estabelecidos, destacando um colapso sistêmico nos fluxos de trabalho editoriais.

Esses não são incidentes isolados. Um estudo internacional de referência coordenado pela BBC e pela European Broadcasting Union (EBU) revelou a natureza sistémica desta falta de fiabilidade.

Depois de avaliar mais de 3.000 respostas, as suas conclusões mostraram que os assistentes de IA produzem erros significativos em 45% das respostas relacionadas com notícias. Como explicou o diretor de mídia da EBU, Jean Philip De Tender,”Esta pesquisa mostra conclusivamente que essas falhas não são incidentes isolados. Elas são sistêmicas, transfronteiriças e multilíngues, e acreditamos que isso põe em risco a confiança pública.”Para plataformas fundamentais como a Wikipédia, as consequências estão se tornando existenciais.

A Wikimedia Foundation relatou recentemente um declínio surpreendente de 8% no tráfego humano, culpando diretamente as ferramentas de pesquisa de IA e os chatbots por desviarem visitantes ao resumir seu conteúdo sem atribuição.

Tal tendência ameaça o modelo da enciclopédia orientado por voluntários. Como alertou o Diretor Sênior de Produto da Wikimedia, Marshall Miller: “Com menos visitas à Wikipédia, menos voluntários podem desenvolver e enriquecer o conteúdo, e menos doadores individuais podem apoiar este trabalho”. uma lição crítica sobre o estado atual da IA. A responsabilidade pelos erros não pode ser transferida para a máquina.

Como observou Cassie Kozyrkov, ex-cientista-chefe de decisões do Google, depois que um bot de suporte para o editor de código Cursor AI inventou uma política falsa da empresa: “Essa bagunça poderia ter sido evitada se os líderes entendessem que (1) a IA comete erros, (2) a IA não pode assumir a responsabilidade por esses erros (então isso recai sobre você) e (3) os usuários odeiam ser enganados por uma máquina que se faz passar por um humano.”

O que aconteceu no Dawn é simplesmente o mais recente lembrete de que, na era da IA, a camada final e indispensável de controle de qualidade continua sendo a supervisão humana diligente.