O Cursor IDE de codificação de IA lançou seu primeiro modelo interno, o Composer, em 29 de outubro. Seu lançamento coincidiu com uma grande atualização da plataforma, o Cursor 2.0.

Priorizando a velocidade, o novo modelo do Composer é considerado pela empresa quatro vezes mais rápido que ferramentas similares.

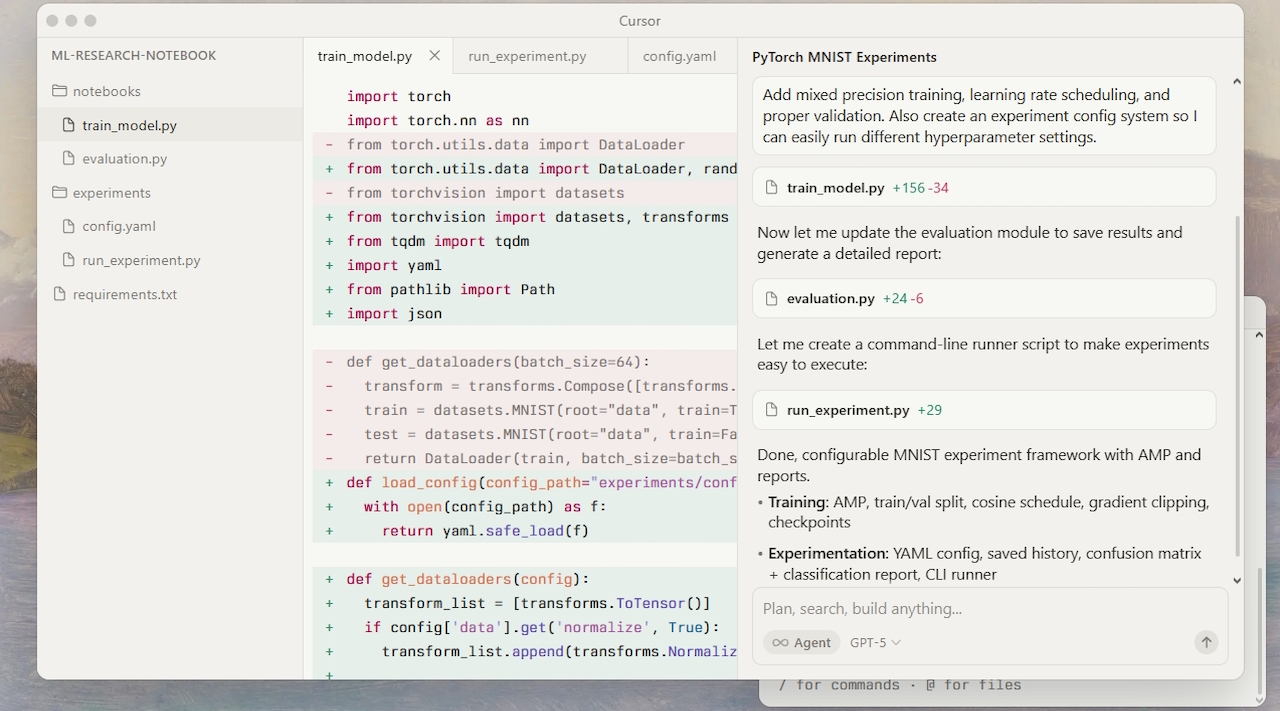

O Cursor 2.0 apresenta uma interface redesenhada para gerenciar vários agentes de IA em paralelo. Os desenvolvedores agora podem comparar resultados de diferentes modelos na mesma tarefa.

Embora o lançamento tenha atraído elogios dos primeiros usuários por seu desempenho, ele também gerou críticas por sua falta de transparência em relação às origens do modelo e ao uso de desempenho privado benchmarks.

Uma necessidade de velocidade: apresentando o modelo Composer

Com o objetivo de manter os desenvolvedores no estado de fluxo, o Cursor posicionou o Composer como um modelo de fronteira criado para codificação interativa e de baixa latência. Cursor o descreve como um modelo de mistura de especialistas (MoE). Foi especializado em engenharia de software por meio de aprendizagem por reforço (RL).

Durante seu treinamento, o modelo teve acesso a ferramentas como pesquisa semântica e foi encarregado de resolver desafios de codificação do mundo real. De acordo com o Cursor, o resultado é um modelo que completa a maioria das curvas de agente em menos de 30 segundos. Esse desempenho o tornaria quatro vezes mais rápido do que concorrentes igualmente inteligentes.

No entanto, essas afirmações de desempenho são baseadas em uma avaliação interna proprietária chamada “Cursor Bench”. Esse benchmark consiste em solicitações reais de agentes dos próprios engenheiros da empresa. A falta de um benchmark público e replicável tornou-se um ponto central de debate após o lançamento.

Apesar do sigilo, a empresa tem sido transparente em relação aos preços. De acordo com sua documentação oficial, o modelo Composer custa US$ 1,25 por milhão de tokens de entrada e US$ 10,00 por milhão de tokens de saída. Ele tem o mesmo preço do GPT-5 e Gemini 2.5 Pro no ambiente Cursor, sinalizando confiança em seus recursos.

Agentes de malabarismo: uma nova interface no Cursor 2.0

Juntamente com o novo modelo, o lançamento do Cursor 2.0 marca uma mudança significativa no design do IDE. Ele passa de um fluxo de trabalho centrado em arquivos para um fluxo de trabalho centrado em agentes. Sua interface atualizada foi criada para executar muitos agentes em paralelo, sem que eles interfiram uns com os outros.

Fortalecendo essa arquitetura multiagente estão árvores de trabalho git ou máquinas remotas. Essas ferramentas criam ambientes isolados para cada agente trabalhar, evitando conflitos.

Usando essa configuração, os desenvolvedores podem atribuir a mesma tarefa complexa a diferentes modelos simultaneamente, por exemplo, pedindo ao Sonnet 4.5 e ao Composer para implementar um recurso.

Os usuários podem então comparar os resultados e escolher a melhor abordagem. Conhecido como “vibe coding”, o fluxo de trabalho está ganhando força como uma forma de aproveitar os pontos fortes distintos de vários modelos de IA. O Google recentemente renovou seu AI Studio com uma filosofia semelhante.

Incluídas na atualização também estão ferramentas para agilizar a revisão e os testes de código, integrando ainda mais a IA ao ciclo de vida de desenvolvimento.

Uma recepção polarizada: elogios e ceticismo da comunidade

Gerando uma onda de discussão, o lançamento duplo dividiu drasticamente as opiniões dentro da comunidade de desenvolvedores. Embora alguns usuários tenham elogiado a capacidade de resposta do novo modelo, outros relataram problemas significativos. Um tópico do Hacker News discutindo o lançamento capturou perfeitamente esse sentimento polarizado.

Por um lado, os primeiros usuários elogiaram o desempenho do novo modelo. Um usuário escreveu:”O Composer fez tudo melhor, não tropeçou onde o Codex falhou e, o mais importante, a velocidade faz uma enorme diferença. É extremamente confortável de usar, parabéns.”

Por outro lado, vários usuários relataram uma experiência inicial frustrante. Um comentou:”Usei o novo sistema hoje à noite e pareceu um downgrade definitivo. Gerei alguns aplicativos básicos que não funcionavam, não consegui lidar com CSS em um ambiente NextJS.”

O ceticismo surgiu rapidamente em plataformas como o Hacker News em relação às afirmações da empresa. As principais críticas centram-se na falta de transparência.

Como um usuário apontou:”A falta de transparência aqui é selvagem. Eles agregam as pontuações dos modelos que eles testam, o que obscurece o desempenho. Eles apenas divulgam resultados em seu próprio benchmark interno que eles não divulgarão.”modelos internos, faz parte de uma tendência mais ampla da indústria. A velocidade e a especialização estão se tornando os principais diferenciais.

Em um comentário, um pesquisador do Cursor ML estruturou a estratégia da empresa, afirmando: “Nossa visão é que agora existe uma quantidade mínima de inteligência necessária para ser produtivo, e se você puder combinar isso com velocidade, isso é incrível.”

Essa filosofia coloca o Composer diretamente contra modelos mais poderosos, mas potencialmente mais lentos, dos principais laboratórios.

Para alguns desenvolvedores, no entanto, a inteligência bruta continua sendo o principal. prioridade. Como observou um usuário:”Talvez eu seja um estranho, mas a qualidade do Sonnet 4.5 é tão baixa quanto estou disposto a ir. A velocidade de geração não é o problema ou a perda de tempo. Ele está lutando para obter o resultado certo.”A estratégia da Cursor a coloca em um mercado extremamente competitivo.

O GitHub revelou recentemente sua própria plataforma multiagente, Agent HQ, que une modelos da OpenAI, Anthropic e Google sob um único plano de controle.

Enquanto isso, provedores individuais como a Anthropic continuam a refinar suas ofertas, como o recém-lançado Claude Code para web.

Ao construir seu próprio modelo, a Cursor está apostando que um sistema totalmente integrado, a experiência de alta velocidade pode conquistar uma base de usuários fiéis, mesmo que isso signifique sacrificar parte da potência bruta dos maiores modelos de fronteira.