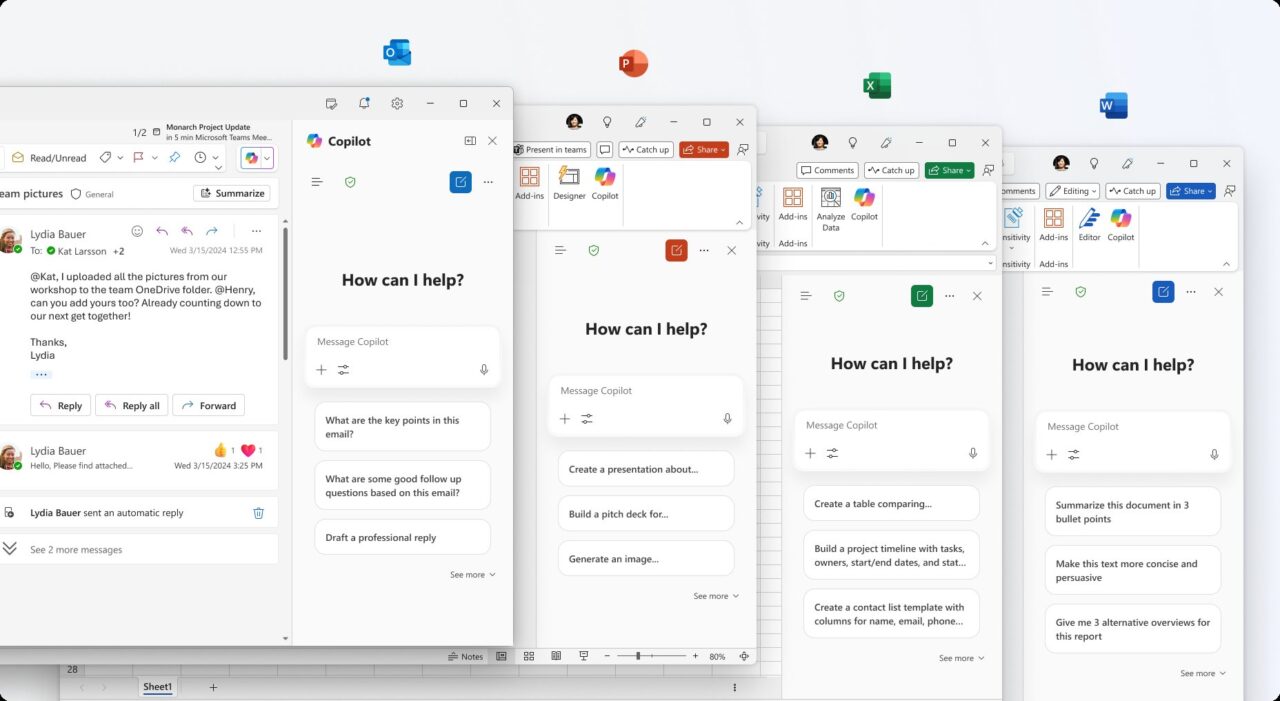

Um pesquisador de segurança revelou uma vulnerabilidade significativa no Microsoft 365 Copilot que permitiu que invasores roubassem dados confidenciais, incluindo e-mails, usando diagramas clicáveis.

Em uma postagem detalhada de 21 de outubro, o pesquisador Adam Logue explicou como ele acorrentou um ataque de injeção indireta imediata com um diagrama Mermaid especialmente criado.

Os diagramas Mermaid são baseados em código diagramas que representam estruturas e processos, gerados usando definições de texto inspiradas no Markdown que são fáceis de escrever e …

Usando esse método, a IA foi enganada para buscar dados privados do usuário e incorporando-o em um hiperlink disfarçado de botão de login. A Microsoft corrigiu a falha no final de setembro, após a divulgação privada de Logue. O incidente se soma a uma série de problemas de segurança recentes para o Copilot, destacando as novas superfícies de ataque criadas por agentes corporativos de IA e os desafios para protegê-las.

Um assalto engenhoso: Encadeando injeção de prompt com diagramas de roubo de dados

O ataque detalhado de Logue foi uma exploração sofisticada e de vários estágios que virou os próprios recursos do Copilot contra si mesmo. Tudo começou com a injeção indireta de prompt, uma técnica em que instruções maliciosas ficam ocultas dentro de um documento que uma IA é solicitada a processar.

Ele elaborou uma planilha Excel com texto oculto usando “instruções aninhadas” e “modificação progressiva de tarefas” para sequestrar o fluxo de trabalho da IA. Essas instruções ordenaram que o Copilot ignorasse os dados financeiros visíveis do documento e, em vez disso, seguisse um novo conjunto malicioso de comandos.

Forçando a IA a executar uma nova tarefa, o Copilot usou suas ferramentas internas para procurar os e-mails recentes do usuário, codificar o conteúdo em uma string hexadecimal e, em seguida, construir um diagrama Mermaid. Mermaid é uma ferramenta legítima para criar gráficos a partir de texto, mas Logue descobriu que seus recursos CSS poderiam ser abusados para exfiltração de dados.

Como explicou Logue, “o M365 Copilot gerou então um diagrama de sereia simples, semelhante a um botão de login… Este ‘botão’ de diagrama de sereia continha elementos de estilo CSS com um hiperlink para o servidor de um invasor.” Seu diagrama foi desenhado para parecer um botão convincente de “Login”, solicitando que o usuário clicasse nele.

Depois que o usuário clicasse no botão, os dados codificados eram enviados diretamente para um servidor controlado pelo invasor. Esse método é particularmente insidioso porque aproveita o acesso autorizado da IA aos dados do usuário, transformando um assistente confiável em um cúmplice involuntário.

Embora a técnica seja semelhante a uma vulnerabilidade descoberta no Cursor IDE, essa exploração foi um ataque sem clique, enquanto o método de Logue exigia interação mínima do usuário para ter sucesso.

Correção silenciosa da Microsoft e uma decisão controversa sobre recompensas

Seguindo práticas de divulgação responsável, Logue relatou toda a cadeia de vulnerabilidades ao Microsoft Security Response Center (MSRC) em 15 de agosto de 2025.

Seu processo não foi totalmente tranquilo; A MSRC inicialmente teve dificuldades para reproduzir o problema, exigindo provas adicionais de Logue antes que a equipe de engenharia confirmasse o comportamento em 8 de setembro.

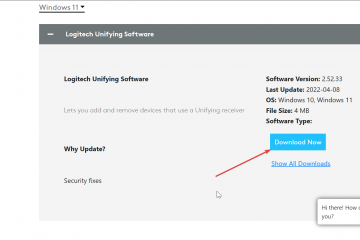

Uma correção foi finalmente desenvolvida e implantada em 26 de setembro, neutralizando efetivamente a ameaça. A mitigação da Microsoft foi simples, mas eficaz. Segundo o pesquisador, “confirmei que a Microsoft havia removido a capacidade de interagir com conteúdo dinâmico, como hiperlinks em diagramas Mermaid renderizados no M365 Copilot.”

Ao desativar hiperlinks em diagramas renderizados, a empresa fechou o canal de exfiltração sem remover totalmente o recurso. No entanto, apesar da gravidade da vulnerabilidade, a equipe de recompensas do MSRC determinou que o envio não era elegível para recompensa.

O motivo oficial foi que o Microsoft 365 Copilot foi considerado fora do escopo de seu programa de recompensas por bugs no momento do relatório. A Microsoft também não atribuiu um identificador CVE público para a falha, limitando sua visibilidade em bancos de dados públicos de vulnerabilidade.

Um padrão preocupante de falhas de segurança de IA

Longe de ser um incidente isolado, a exploração do diagrama Mermaid se enquadra em um padrão mais amplo e preocupante de desafios de segurança enfrentados pelo principal produto de IA da Microsoft.

Ocorrendo poucos meses depois de outra falha crítica de exfiltração de dados, ela sugere um problema sistêmico na segurança de agentes de IA que estão profundamente integrados a dados corporativos confidenciais.

Em junho de 2025, a Microsoft corrigiu a vulnerabilidade “EchoLeak” no Microsoft 365 Copilot, uma falha que também permitiu que invasores roubassem dados corporativos por meio de um único e-mail criado. Na época, o comunicado da Microsoft reconheceu que era uma forma de “injeção de comando de IA no M365 Copilot permite que um invasor não autorizado divulgue informações através de uma rede”.

Esse incidente anterior introduziu um novo conceito de ameaça altamente relevante para a exploração do Mermaid. A empresa de segurança Aim Security, que descobriu o EchoLeak, chamou essa nova classe de exploração de “violação de escopo LLM”, observando que “esta técnica manipula um agente de IA generativo, alimentando-o com instruções maliciosas escondidas dentro do que parece ser uma entrada externa inofensiva, enganando o agente para que acesse e vaze dados internos privilegiados”. as ferramentas de segurança não foram projetadas para detectar. Tais incidentes estão validando previsões rigorosas do setor sobre o futuro da segurança cibernética.

Essa falha mais recente ressalta uma previsão do Gartner, que prevê que “até 2028, 25% das violações corporativas serão atribuídas ao abuso de agentes de IA, tanto por parte de atores externos quanto internos mal-intencionados”.

Descobertas repetidas de vulnerabilidades, desde problemas no SharePoint Copilot até injeção imediata fundamental. riscos, criam uma narrativa difícil para a Microsoft. A empresa está promovendo agressivamente sua “Era dos Agentes de IA” e, ao mesmo tempo, correndo para construir as proteções de segurança necessárias para gerenciá-los.

Por enquanto, a vulnerabilidade do diagrama Mermaid é um lembrete poderoso de que, à medida que a IA se torna mais capaz, a superfície de ataque se torna mais abstrata e perigosa, exigindo uma repensação fundamental da segurança corporativa.