A gigante tecnológica chinesa Alibaba revelou um novo e poderoso sistema que reduz o custo de execução da inteligência artificial em até 82%.

A tecnologia, chamada Aegaeon, aborda um desafio crítico para os provedores de nuvem: como servir com eficiência milhares de modelos especializados de IA que os clientes usam com pouca frequência.

Na pesquisa apresentada no Simpósio sobre Princípios de Sistemas Operacionais (SOSP) em Seul-um dos locais de maior prestígio em ciência da computação-o Alibaba detalhou como o agendamento inteligente da Aegaeon agrupa hardware GPU caro com muito mais eficiência do que os métodos atuais.

Durante um teste de três meses, o sistema permitiu que o Alibaba Cloud atendesse uma vasta coleção de modelos usando apenas 213 GPUs em vez de 1.192, cortando drasticamente os custos operacionais para seu mercado de IA.

A inovação visa diretamente o imenso desperdício inerente à infraestrutura de IA atual. Os dados do próprio Alibaba revelaram um grande desequilíbrio: 17,7% de sua frota de GPUs estava ocupada servindo uma “cauda longa” de modelos de nicho que representavam apenas 1,35% do total de solicitações dos clientes.

Para plataformas em nuvem que hospedam um mercado crescente de diversos modelos, essa ineficiência representa uma despesa operacional enorme e insustentável.

O desenvolvimento da Aegaeon, em coautoria do CTO da Alibaba Cloud, Zhou Jingren, sinaliza um impulso estratégico de alto nível para resolver esse problema.

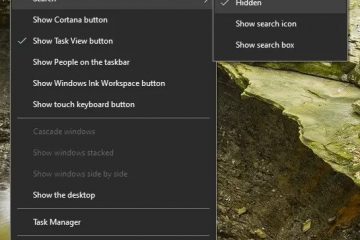

De GPUs ociosas ao agendamento inteligente: o avanço do Aegaeon

Em sua essência, o Aegaeon substitui o escalonamento bruto em nível de solicitação usado por muitos sistemas por um “nível de token” muito mais granular. abordagem de escalonamento automático”.

Os sistemas tradicionais devem esperar que um modelo termine completamente de gerar uma resposta para um usuário. Esse processo trava a GPU, criando um severo “bloqueio inicial”, onde solicitações urgentes para outros modelos ficam presas em uma fila atrás de uma tarefa de longa duração.

A arquitetura do Aegaeon é mais inteligente. Ele pode pausar o processo de um modelo no meio da geração, token por token, para lidar rapidamente com uma solicitação recém-chegada de um modelo diferente no mesmo hardware.

Esse agendamento preventivo permite que uma única GPU atenda com fluidez a vários modelos díspares (até sete por GPU em testes) sem os longos atrasos que violam os objetivos de nível de serviço.

De acordo com o artigo de pesquisa, esse controle refinado é incrivelmente eficaz. Aegaeon emprega uma série de otimizações full-stack, incluindo a reutilização de componentes para acelerar a reinicialização do mecanismo e o gerenciamento explícito de memória para evitar a fragmentação, que juntos reduzem a sobrecarga típica associada ao escalonamento automático em notáveis 97%.

Como resultado, o Alibaba afirma que a Aegaeon pode sustentar taxas de solicitação de 2 a 2,5 vezes mais altas do que soluções alternativas, mudando fundamentalmente a economia de servir um modelo diversificado catalog.

Além da força bruta: como o escalonamento em nível de token resolve o problema de cauda longa da IA

Esse avanço na eficiência operacional é diferente das inovações que reduzem os custos de treinamento em IA. Embora proporcione grandes economias, a estreia da Aegaeon não é uma repetição do momento DeepSeek em janeiro de 2025.

Esse evento viu um artigo da empresa chinesa DeepSeek sugerir métodos de treinamento radicalmente mais baratos, desencadeando uma grande liquidação de ações de tecnologia que atingiu particularmente os fabricantes de GPU como a Nvidia.

Em vez disso, Aegaeon enfrenta o desafio igualmente crítico, embora menos chamativo, de inferência. custos – o preço de realmente *executar* modelos de IA em produção.

Resolver isso é uma necessidade estratégica para o Alibaba. A empresa está adotando uma estratégia agressiva de IA, lançando um fluxo constante de modelos proprietários e de código aberto para tarefas que vão desde codificação até raciocínio multimodal.

Essa mesma estratégia cria a “cauda longa” de modelos especializados que torna o Aegaeon tão valioso. Ao construir uma plataforma eficiente para operá-los, o Alibaba pode tornar seu amplo mercado de IA economicamente viável.

Uma nova frente na corrida armamentista de IA: o impulso de toda a indústria pela eficiência

O foco do Alibaba na programação é uma das várias frentes em uma guerra em todo o setor contra os custos impressionantes da IA.

Com o preço do treinamento e da inferência. Continuando a ser uma barreira importante à adoção generalizada, os principais intervenientes estão a atacar o problema da eficiência de diferentes ângulos, criando um cenário diversificado de inovação onde cada parte da pilha de IA está a ser otimizada.

Uma abordagem popular é redesenhar a própria arquitetura do modelo. Os recentes modelos Granite 4.0 da IBM, por exemplo, usam um design híbrido que combina blocos Transformer com camadas Mamba altamente eficientes. Este método busca eficiência construindo um mecanismo fundamentalmente mais enxuto desde o início, visando a carga computacional principal.

Para o líder do projeto da IBM, Raghu Ganti, “tudo se resume à redução do cache KV… Mais rendimento, menor latência, maior comprimento de contexto.”

Outra estratégia visa a otimização de memória dentro da arquitetura dominante do Transformer. Os modelos de memória de atenção neural (NAMMs) da Sakana AI, com sede em Tóquio, usam algoritmos evolutivos para gerenciar de forma inteligente o cache KV de um modelo, um grande gargalo de memória.

Essa técnica reduz drasticamente o consumo de memória para tarefas que envolvem contextos longos.

Também estão surgindo abordagens mais radicais que desafiam totalmente o paradigma de escalonamento. Pesquisadores revelaram neste verão um modelo de visão semelhante ao cérebro que imita as estruturas neurais humanas para uma eficiência energética superior.

Um de seus coautores, Zejin Lu, explicou o conceito:”Para os humanos, quando você detecta certos objetos, eles têm uma posição típica. Você já sabe que os sapatos geralmente ficam na parte inferior, no chão. O avião está no topo.”

O modelo resultante consome mais de dez vezes menos energia do que uma IA padrão, provando que um design elegante às vezes pode superar a força bruta.

A programação dinâmica do Aegaeon é uma abordagem poderosa e complementar a esses outros métodos. Isso prova que a engenharia de sistemas sofisticada pode gerar economias tão significativas quanto as resultantes de revisões arquitetônicas, garantindo que a revolução da IA possa se tornar uma realidade empresarial sustentável.