A OpenAI criou um novo painel de especialistas para aconselhar sobre segurança de IA. A empresa anunciou o “Conselho de Especialistas em Bem-Estar e IA” de oito pessoas na terça-feira. O grupo ajudará a orientar os aspectos de saúde e bem-estar de ferramentas como ChatGPT e Sora. Esta medida é uma resposta clara à crescente pressão pública e governamental.

Em setembro, a Comissão Federal de Comércio dos EUA iniciou uma grande investigação sobre o efeito da IA sobre os adolescentes. A empresa também enfrenta uma ação judicial que vincula seu chatbot ao suicídio de um adolescente. O novo conselho é o mais recente passo da OpenAI para mostrar que leva essas preocupações de segurança a sério.

Uma resposta direta à pressão regulatória e legal

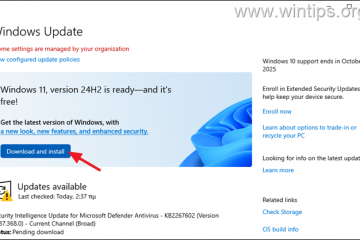

O momento deste anúncio não é coincidência. Seguem-se meses de intenso escrutínio. A investigação abrangente da FTC sobre sete gigantes da tecnologia, incluindo a OpenAI, sinalizou uma nova era de supervisão regulatória para o mercado complementar de IA em rápido crescimento.

O presidente da FTC, Andrew N. Ferguson, enquadrou a investigação como um ato de equilíbrio, afirmando: “proteger as crianças online é uma prioridade máxima para a Trump-Vance FTC, e o mesmo acontece com a promoção da inovação em setores críticos da nossa economia.”Essa ação federal alertou toda a indústria de que a era de operar com poucas grades de proteção havia acabado.

A pressão legal é igualmente intensa. Em agosto, a OpenAI foi alvo de um processo por homicídio culposo movido pelos pais de um adolescente que morreu por suicídio. Seu pai, Matthew Raine, fez uma repreensão poderosa, dizendo: “Como pais, vocês não podem imaginar como é ler uma conversa com um chatbot que preparou seu filho para tirar a própria vida”. Este caso galvanizou a preocupação pública e amplificou os apelos à acção.

Estes eventos fazem parte de um padrão de falhas de segurança que tem afectado a indústria. Meta enfrentou uma crise semelhante após relatos de que sua IA poderia ajudar adolescentes a planejarem automutilação. O incidente levou Jim Steyer, CEO da Common Sense Media, a declarar: “A meta IA é um perigo para os adolescentes e deve ser eliminada imediatamente”.

Uma coalizão de 44 procuradores-gerais estaduais ecoou essa indignação em um carta contundente, escrevendo: “estamos uniformemente revoltados com este aparente desrespeito pelo bem-estar emocional das crianças…” A condenação generalizada dos níveis estadual e federal tem forçou as empresas de tecnologia a reagir.

Conheça o Conselho de Especialistas em Bem-Estar e IA

O novo conselho da OpenAI é uma resposta direta a esses desafios. A a empresa anunciou o “Conselho de Especialistas em Bem-Estar e IA” de oito membros para orientar seu trabalho em produtos como ChatGPT e Sora. Seu mandato formal é aconselhar, fazer perguntas críticas e ajudar a estabelecer como devem ser as interações saudáveis com IA para usuários de todas as idades.

O grupo é composto por figuras importantes da psicologia, psiquiatria e interação humano-computador. Os membros incluem especialistas como o Dr. David Bickham, do Hospital Infantil de Boston, o professor Andrew Przybylski, da Universidade de Oxford, e a Dra. Essas sessões explorarão tópicos complexos, como como a IA deve se comportar em situações sensíveis e quais proteções podem melhor apoiar os usuários. O grupo também explorará como a IA pode contribuir positivamente para o bem-estar.

Isso formaliza um relacionamento que começou no início deste ano. A OpenAI confirmou que consultou informalmente muitos destes especialistas durante o desenvolvimento dos seus controlos parentais recentemente lançados. O feedback deles ajudou especificamente a moldar o tom das notificações de socorro para ser “atencioso e respeitoso tanto com os adolescentes quanto com os membros da família”.

Esses controles, implementados no final de setembro, foram um primeiro passo crítico. O sistema usa um modelo de aceitação mútua e oferece aos responsáveis um painel para definir “horários de silêncio”, desativar o modo de voz e desligar os recursos de memória. Um recurso importante é um sistema de alerta que notifica os pais se uma conversa for sinalizada por conteúdo grave de automutilação após ser avaliada por revisores humanos.

A chefe de bem-estar juvenil da OpenAI, Lauren Haber Jonas, explicou que o objetivo era encontrar um equilíbrio delicado. “Queremos dar aos pais informações suficientes para agirem e conversarem com seus filhos adolescentes, mantendo ao mesmo tempo alguma privacidade dos adolescentes”, observou ela. O conselho agora formalizará essa função consultiva, ajudando a moldar futuros recursos de segurança e políticas de produtos.

Um cálculo de toda a indústria sobre segurança de IA

Os desafios que a OpenAI enfrenta não são únicos. Eles refletem uma avaliação mais ampla e abrangente do impacto psicológico da IA em toda a indústria. Os especialistas há muito alertam sobre os perigos da dependência emocional em chatbots projetados para imitar a conexão humana.

Embora o novo conselho e os controles parentais da OpenAI sejam passos significativos, alguns críticos argumentam que eles não vão longe o suficiente. A natureza opcional dos controles parentais impõe aos responsáveis a responsabilidade de ativá-los.

A OpenAI reconhece que esses são apenas os primeiros passos. A empresa também está desenvolvendo um sistema de previsão de idade de longo prazo para aplicar automaticamente configurações apropriadas para adolescentes por padrão. Por enquanto, a formação do conselho de especialistas sinaliza um compromisso claro em abordar a segurança.