O Google está adotando uma filosofia “menos é mais” com seu último lançamento de IA, lançando o modelo aberto Hyper-Eficiente Gemma 3 270M. Com apenas 270 milhões de parâmetros, esse modelo compacto é projetado para os desenvolvedores criarem aplicativos especializados e ajustados que podem ser executados diretamente em dispositivos como smartphones ou mesmo dentro de um navegador da web. Em vez de depender de sistemas enormes baseados em nuvem, a Gemma 3 270M se concentra na eficiência de energia extrema para tarefas bem definidas, tornando a IA avançada mais acessível para computação no device e borda. Target=”_ Blank”> Expandindo”GemMaverse”de modelos abertos . Segue-se a estréia inicial da série Gemma 3 em março, o lançamento de versões do QAT para GPUs de consumo em abril e o lançamento do primeiro celular Gemma 3n em junho.

Essa estratégia se alinha com uma mudança mais ampla da indústria em direção a pequenos modelos de idiomas (SLMs). Empresas como a Microsoft com sua série PHI, a Mistral IA com seu pequeno modelo 3 e o rosto abraçando com seus modelos SMOLVLM estão investindo fortemente em IA eficiente. Ele ressalta uma tendência crescente da indústria, onde modelos menores e especializados estão se tornando ferramentas essenciais para a implantação prática do mundo real. href=”https://developers.googleblog.com/en/introducting-gemma-3-270m”Target=”_ Blank”> O Google está posicionando Gemma 3 270m Não é como um rival de modelos de espesso geral, mas como uma base de alta qualidade. O anúncio oficial da empresa chama um princípio clássico de engenharia: você não usaria uma marreta para pendurar uma moldura. Este modelo incorpora essa”ferramenta correta para o trabalho”Philosophy , com seu verdadeiro potencial projetado para ser desbloqueado> o Rapid, o TaskEn Fine-Toling. Funções onde a velocidade e a relação custo-benefício são fundamentais. O Google identifica casos de uso ideais, como análise de sentimentos, extração de entidades, roteamento de consultas, escrita criativa, verificações de conformidade e conversão de texto não estruturado em dados estruturados. O objetivo é capacitar os desenvolvedores a construir e implantar vários modelos personalizados, cada um treinado habilmente para uma tarefa diferente, sem os custos proibitivos associados a sistemas maiores.

O poder dessa abordagem especializada já foi demonstrada no mundo real. O Google destaca o trabalho de ML adaptativo com a SK Telecom, onde um modelo Gemma ajustado foi encarregado de moderação multilíngue e matilíngue. Os resultados foram fortes: o modelo especializado não apenas atingiu, mas também superou os sistemas proprietários muito maiores em sua tarefa específica. Essa história de sucesso serve como um plano prático de como os desenvolvedores podem aproveitar a eficiência de Gemma 3 270M. Essa estratégia tem como alvo diretamente a crescente necessidade de IA econômica que pode ser implantada em escala sem incorrer em grandes custos de inferência. O tamanho pequeno do modelo permite a iteração rápida, permitindo que as experiências de ajuste fina sejam concluídas em horas, não dias. Para certos papéis altamente especializados, como NPCs de jogo de interpretação ou bots de diário personalizado, a capacidade do modelo de”esquecer”o conhecimento geral através do excesso de ajuste se torna um recurso, garantindo que ele permaneça focado no laser em sua função designada. Punch, resultado de compensações arquitetônicas deliberadas. Os 270 milhões de parâmetros do modelo são distribuídos não convencionais: 170 milhões substanciais são dedicados à sua camada de incorporação, deixando apenas 100 milhões para os principais blocos de transformadores. Essa opção de design permite diretamente o recurso de destaque do modelo: um enorme vocabulário de 256.000 token.

Este grande vocabulário é a chave para sua capacidade de especialização. Ele permite que o modelo lida com tokens raros, específicos e técnicos com alta fidelidade, tornando-o uma base excepcionalmente forte para ajustes finos em domínios de nicho como lei, medicina ou finanças. Ao entender o jargão específico do setor desde o início, requer menos dados de treinamento para se tornarem um especialista. Isso é complementado por uma janela de contexto respeitável de 32k token, permitindo que ele processe instruções e documentos substanciais. A empresa fica clara que a Gemma 3 270M não foi projetada para casos de uso de conversação abertos e complexos, como um chatbot. Em vez disso, a versão ajustada por instruções é projetada para seguir os prompts e comandos estruturados efetivamente imediatamente, fornecendo uma base confiável para uma personalização adicional.

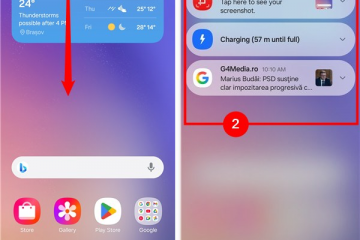

Esse design robusto é validado por seu desempenho nos benchmarks da indústria. No teste Ifeval, que mede a capacidade de um modelo de seguir instruções verificáveis, a Gemma 3 270M atinge uma pontuação de 51,2 %. Essa pontuação é maior do que outros modelos leves que possuem mais parâmetros, mostrando que ela dá um soco bem acima do seu peso. Embora previsivelmente fique aquém dos modelos de parâmetros de bilhão, seu desempenho é notavelmente competitivo para seu tamanho fracionário. Os testes internos em um Pixel 9 PRO mostraram um modelo desconhecido INT4 usou apenas 0,75% da bateria do dispositivo para 25 conversas, tornando-a modelo Gemma mais eficiente em termos de energia do Google até o momento. Ele também garante a privacidade do usuário, pois as informações confidenciais podem ser processadas localmente sem nunca ser enviado para a nuvem. Isso permite que os desenvolvedores executem os modelos com precisão INT4 com degradação mínima de desempenho, um recurso crucial para implantar em hardware restrito a recursos.

Para desenvolvedores, Gemma 3 270M é disponível agora através de plataformas populares como o Hugging Face , ollama e kaggle. Essa ampla acessibilidade, elogiada por desenvolvedores como Simon Willison, que chamou um lançamento anterior de Gemma”o lançamento mais abrangente do dia que eu já vi para qualquer modelo”, é a chave para promover um ecossistema vibrante em torno dessas ferramentas de IA menores e mais práticas.