Meta entrou no mercado de assistente de AI dedicado, liberando sua autônomo meta ai ai ai ai ai Aplicativo Este aplicativo desafia diretamente players estabelecidos como o ChatGPT, alavancando os modelos Llama 4 Language da Meta, anunciados no início de abril. Ai.”As interações principais acontecem por texto ou voz, com a IA capaz de extrair resultados na Web em tempo real e gerar imagens. respostas. Usuários nos EUA, Canadá, Austrália e Nova Zelândia também podem testar uma beta opt-in “Fulllm-s-full-DupL-dialogue-gents/”Target),”_blain”. O discurso sobreposto, embora essa versão de demonstração atualmente opere sem conectividade na Web e possa exibir falhas. Uma alternância permite que os usuários defina a voz como o método de interação padrão ao abrir o aplicativo. publicamente.

Essas interações compartilhadas podem ser apreciadas, comentadas ou remixadas para uso pessoal. De acordo com o vice-presidente de produto da Meta, Connor Hayes, o feed pretende”desmistificar a IA”e mostrar”as pessoas o que elas podem fazer com ele”. A meta enfatiza que o compartilhamento de conteúdo do Feed Discover requer ação explícita do usuário. O assistente pode Utilizar informações do Facebook e do Instagram conectados por meio do centro, juntamente com o uso de dados <. Alinhe-se ao objetivo anteriormente declarado da Meta de"construir em direção a um assistente mais inteligente e personalizado". Os usuários mantêm a capacidade de informar os detalhes específicos da IA a serem lembrados. Embora a Meta já integrasse a Meta AI nas barras de pesquisa em suas plataformas, atingindo"quase"um bilhão de usuários dessa maneira, Hayes admitiu que um aplicativo independente oferece a"maneira mais intuitiva de interagir com um assistente de IA agora"

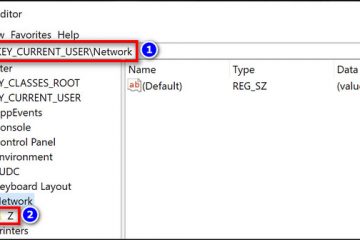

conectar o hardware e o software em Ai App 4

Óculos Smart Meta, absorvendo as funções do META VIEW APP . Configurações e mídia para os usuários de óculos existentes são transportados automaticamente para uma nova guia”Dispositivos”. A interação também pode fluir entre o aplicativo e a versão da Web. However, Meta notes a current limitation: “[you] cannot start in the app or on the web and pick up where you left off on your glasses.”

This hardware link follows an April 24th update that rolled out expanded AI features for the glasses, including global availability for live translation and wider access to the “Look and ask”visual AI, all now managed through the central Meta AI app.

The Llama 4 models A base do aplicativo utiliza técnicas como a arquitetura de mistura de especialistas (MOE)-ativando apenas as peças do modelo necessárias por tarefa-para eficiência e apresentam manuseio nativo de vários tipos de dados, como texto e imagens. O desenvolvimento desses modelos tem intensidade de recursos comprovada; Surgiram relatos de que a Meta abordou a Microsoft e a Amazon buscando o co-financiamento para o desenvolvimento da llama. Os documentos judiciais revelaram mensagens internas, com um engenheiro escrevendo:”Torrenting de um laptop corporativo [de propriedade meta] não parece certo”. Ele declarou uma meta para o llama 4 envolve combater tendências políticas percebidas, dizendo:”É sabido que todos os principais LLMs tiveram problemas com viés-especificamente, eles historicamente se inclinaram à esquerda quando se trata de debate os tópicos políticos e sociais. Programa de verificação de fatos de terceiros. O chefe de política global Joel Kaplan atribuiu que mudam parcialmente a erros de moderação, observando que as revisões internas sugeriram “uma a duas em cada 10 dessas ações pode ter sido erros.”

Competível, a meta atuou para manter os usuários dentro de seu ecossystem de IA, preenchendo a Apple. irregular; A estréia européia do chatbot integrado em março de 2025 veio com restrições à geração de imagens e personalização devido às regras de privacidade do GDPR, sugerindo possíveis variações regionais para os novos recursos do aplicativo independente.