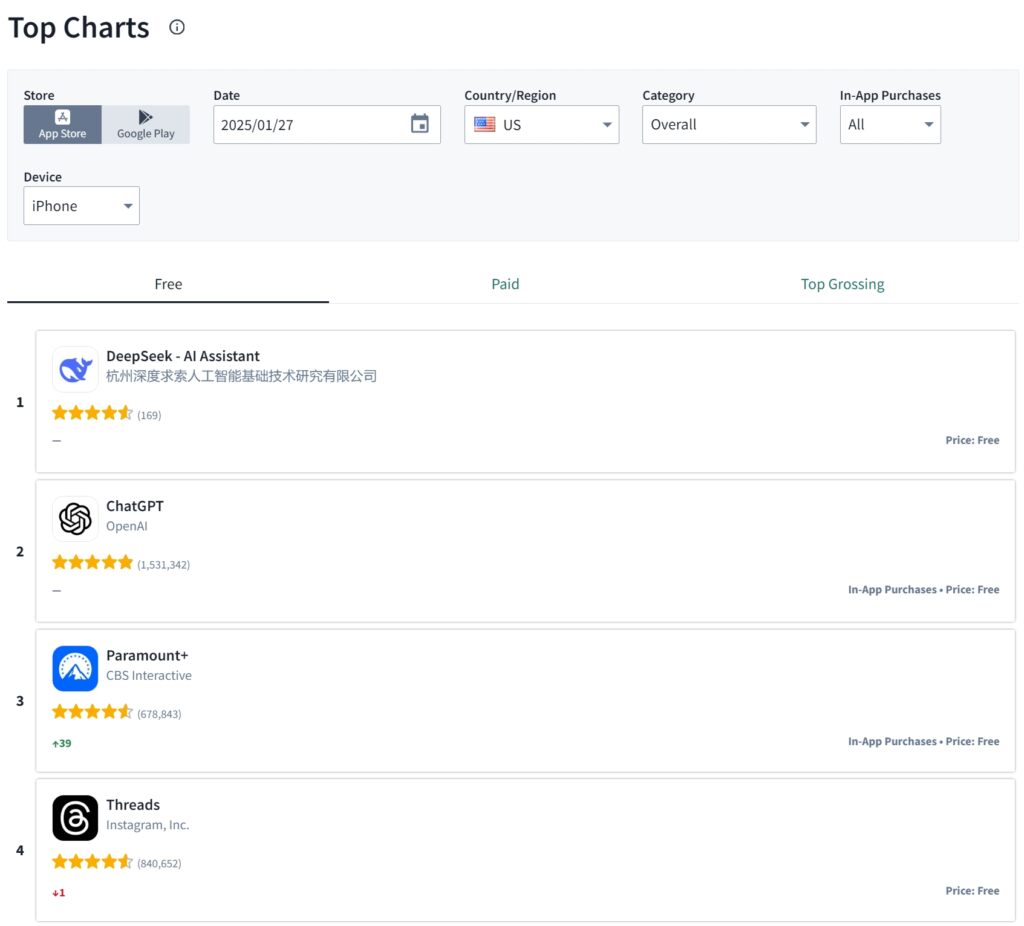

DeepSeek, uma startup chinesa de inteligência artificial, conquistou o primeiro lugar na App Store da Apple nos EUA no fim de semana passado, ultrapassando o ChatGPT da OpenAI em downloads.

O marco ocorre após o lançamento, em 20 de janeiro, do principal modelo de raciocínio da DeepSeek, R1, que rapidamente ganhou reconhecimento por sua capacidade de rivalizar com sistemas avançados de IA enquanto opera com uma fração dos recursos normalmente necessários.

>  Fonte: Sensor Tower

Fonte: Sensor Tower

O DeepSeek R1 oferece desempenho de ponta, ao mesmo tempo que é censurado de acordo com as regras do PCC.

O rápido crescimento do aplicativo com tecnologia R1 reflete a engenharia inovadora da DeepSeek e o uso estratégico de GPUs Nvidia H800, cuja exportação é restrita para a China devido às sanções dos EUA.

Relacionado: Por que as sanções dos EUA podem ter dificuldades para conter o crescimento tecnológico da China

Ao desenvolver métodos de treinamento eficientes, a empresa sediada em Hangzhou demonstrou que o avanço da IA é possível mesmo sob restrições geopolíticas. Este desenvolvimento desafia a percepção do domínio dos EUA na inteligência artificial e levanta questões sobre a eficácia das restrições à exportação destinadas a reduzir as capacidades tecnológicas da China.

Construindo IA sob Restrições: Uma Abordagem Engenhosa

O modelo R1 da DeepSeek foi treinado usando apenas 2.048 GPUs Nvidia H800 a um custo total inferior a US$ 6 milhões, de acordo com um artigo de pesquisa que a empresa divulgou em dezembro. 2024.

Essas GPUs são versões intencionalmente aceleradas dos chips H100 usados por empresas norte-americanas como OpenAI e Meta. Apesar das limitações de hardware, os engenheiros da DeepSeek desenvolveram novas técnicas de otimização que permitiram ao R1 alcançar resultados comparáveis aos modelos treinados em infraestrutura muito mais poderosa.

O fundador Liang Wenfeng, ex-gerente de fundos de hedge, explicou a abordagem da empresa durante uma reunião. entrevista com 36Kr. “Precisamos consumir quatro vezes mais capacidade de computação para obter o mesmo efeito”,

Relacionado: DeepSeek AI Open Sources Série VL2 de modelos de linguagem de visão

Liang disse: “O que precisamos fazer é diminuir continuamente essas lacunas”. A visão de Liang em armazenar GPUs Nvidia antes que as restrições dos EUA entrassem em vigor foi um fator crítico na capacidade da empresa de inovar sob circunstâncias desafiadoras.

Os engenheiros da DeepSeek também se concentraram em reduzir o uso de memória e a sobrecarga computacional, permitindo alta precisão apesar das restrições de hardware.. Dimitris Papailiopoulos, pesquisador principal do laboratório AI Frontiers da Microsoft, destacou a eficiência do design do R1.

“Eles buscavam respostas precisas em vez de detalhar cada etapa lógica, reduzindo significativamente o tempo de computação e mantendo um alto nível de eficácia”, disse ele ao MIT Technology Review.

Desempenho Benchmarks e reconhecimento da indústria

O desempenho do R1 tem sido particularmente forte em benchmarks técnicos, obtendo pontuações de 97,3% no MATH-500 e 79,8% no AIME 2024. Esses resultados colocam o R1 ao lado da série o1 da OpenAI, demonstrando que o modelo de eficiência de recursos do DeepSeek pode competir com os líderes do setor.

Além de seu modelo principal, o DeepSeek também lançou versões menores do R1 capazes de rodar em dispositivos de consumo. hardware de alta qualidade. Essa acessibilidade ampliou o apelo do modelo entre desenvolvedores, educadores e amadores. Nas redes sociais, os usuários compartilharam exemplos de R1 lidando com tarefas complexas, como desenvolvimento web, codificação e matemática avançada. solução de problemas.

Relacionado: Mistral AI estreia Pixtral 12B para processamento de texto e imagem

As conquistas da DeepSeek atraíram elogios de figuras proeminentes no campo da IA. Yann LeCun, Cientista Chefe de IA da Meta, enfatizou o papel da colaboração de código aberto no sucesso do DeepSeek. ““DeepSeek lucrou com pesquisa aberta e código aberto (por exemplo, PyTorch e Llama da Meta). Eles tiveram novas ideias e as construíram com base no trabalho de outras pessoas.”LeCun escreveu no LinkedIn. Como seu trabalho é publicado e de código aberto, todos podem lucrar com ele. Esse é o poder da pesquisa aberta e do código aberto.”

Da mesma forma, Marc Andreessen, cofundador da Andreessen Horowitz, descreveu o R1 como “um dos avanços mais surpreendentes que já vi”. Esses endossos destacam o impacto global da abordagem engenhosa da DeepSeek para IA. desenvolvimento.

Acessibilidade e espírito de código aberto

Ao contrário de plataformas proprietárias como ChatGPT da OpenAI, DeepSeek adotou uma filosofia de código aberto que a empresa criou. os pesos, receitas de treinamento e documentação do modelo R1 disponíveis publicamente, permitindo que desenvolvedores em todo o mundo repliquem ou desenvolvam seu trabalho. Essa transparência destacou o DeepSeek em um setor frequentemente caracterizado pelo sigilo.

O preço acessível também tem sido um fator chave na popularidade do R1. O aplicativo é gratuito e o acesso à API tem um preço significativamente mais baixo do que as ofertas dos concorrentes. Essas estratégias de preços, combinadas com os recursos robustos do modelo, tornaram o DeepSeek uma opção atraente para indivíduos e empresas.

Relacionado: LLaMA AI Under Fire – What Meta Isn’t Telling Você sobre modelos de “código aberto”

Implicações geopolíticas do sucesso do DeepSeek

A ascensão do DeepSeek ocorre em um momento de maior tensões geopolíticas entre os Estados Unidos e a China, particularmente no domínio da inteligência artificial

Desde 2021, a administração Biden ampliou as restrições à exportação de chips avançados para a China, com o objetivo de limitar a capacidade de desenvolvimento do país. tecnologias competitivas de IA. No entanto, as conquistas da DeepSeek sugerem que tais medidas podem não impedir totalmente a inovação.

O sucesso da empresa gerou debates nos círculos tecnológicos dos EUA sobre as consequências indesejadas dos controles de exportação. os executivos argumentam que estas restrições podem estar a impulsionar a inovação engenhosa entre as empresas chinesas. A estratégia de Liang de armazenar GPUs e focar na eficiência provou que as restrições podem estimular a solução criativa de problemas, em vez de sufocá-la completamente.

Relacionado: Novas regras de exportação de chips de IA dos EUA enfrentam reação negativa da indústria por Nvidia e outros

Um movimento mais amplo na IA chinesa

A abordagem de código aberto da DeepSeek se alinha com uma tendência mais ampla no setor de IA da China. Outras empresas, incluindo Alibaba Cloud e 01.AI de Kai-Fu Lee, também priorizaram iniciativas de código aberto nos últimos anos. Liang descreveu a necessidade de abordar o que ele chama de “lacuna de eficiência” entre os empreendimentos de IA chineses e ocidentais, explicando que as empresas locais muitas vezes exigem o dobro dos recursos para alcançar resultados comparáveis.

Relacionado: Alibaba Qwen lança modelo de IA de raciocínio multimodal QVQ-72B-Preview

Em julho de 2024, Liang declarou: “Estimamos que os melhores modelos nacionais e estrangeiros podem ter uma lacuna de uma vez na estrutura do modelo e dinâmica de treinamento. Só por esse motivo, precisamos consumir o dobro da capacidade de computação para obter o mesmo efeito. Além disso, também pode haver uma lacuna de uma vez na eficiência dos dados, ou seja, precisamos consumir o dobro. muitos dados de treinamento e poder de computação para alcançar o mesmo efeito. Juntos, precisamos consumir quatro vezes mais poder de computação. O que precisamos fazer é reduzir continuamente essas lacunas.

Sua liderança conquistou o reconhecimento da DeepSeek tanto na China quanto internacionalmente. Em 2024, ele foi convidado para reuniões de alto nível com autoridades chinesas para discutir estratégias para o avanço das capacidades de IA do país.

Desafios e oportunidades futuras

As A DeepSeek continua a refinar seus modelos, a empresa enfrenta oportunidades e desafios. Embora suas conquistas tenham provado a viabilidade de uma IA eficiente em termos de recursos, permanecem dúvidas sobre se tais abordagens podem ser escalonadas para competir com os investimentos maciços de gigantes da tecnologia como OpenAI e Meta.

Em uma postagem após o lançamento do DeepSeek R1 , Mark Zuckerberg, CEO da Meta, destacou a importância de investimentos em grande escala na infraestrutura de IA, dizendo “Este será um ano decisivo para a IA. Em 2025, espero que a Meta AI seja o principal assistente atendendo a mais de 1 bilhão de pessoas, o Llama 4 se torne o principal modelo de última geração e construiremos um engenheiro de IA que começará a contribuir com quantidades cada vez maiores de código aos nossos esforços de P&D. Para impulsionar isso, a Meta está construindo um datacenter de 2 GW+ que é tão grande que cobriria uma parte significativa de Manhattan.

Colocaremos on-line cerca de 1 GW de computação em 25 e terminaremos o ano com mais de 1,3 milhão de GPUs. Planejamos investir US$ 60-65 bilhões em investimentos este ano, ao mesmo tempo em que aumentamos significativamente nossas equipes de IA, e temos o capital para continuar investindo nos próximos anos. Este é um esforço enorme e, nos próximos anos, impulsionará nossos principais produtos e negócios, desbloqueará inovações históricas e ampliará a liderança tecnológica americana. Vamos construir!”

Por enquanto, o sucesso da DeepSeek com R1 demonstrou que a inovação não é domínio exclusivo dos participantes mais bem financiados. Ao priorizar eficiência, transparência e acessibilidade, a empresa fez um impacto duradouro na indústria global de IA.