A Hugging Face revelou dois modelos leves de IA, SmolVLM-256M-Instruct e SmolVLM-500M-Instruct, com o objetivo de redefinir como a IA pode funcionar em dispositivos com poder computacional limitado.

Os modelos, usando 256 milhões e 500 milhões de parâmetros respectivamente, são projetados para enfrentar os desafios enfrentados pelos desenvolvedores que trabalham com hardware restrito ou análise de dados em grande escala com custo mínimo.

O lançamento representa um avanço em eficiência e acessibilidade para processamento de IA. Os modelos SmolVLM oferecem recursos multimodais avançados, permitindo tarefas como descrição de imagens, análise de vídeos curtos e resposta a perguntas sobre PDFs ou gráficos científicos.

Como Hugging Face explica: “O SmolVLM torna mais rápido e barato criar arquivos pesquisáveis bancos de dados, com velocidades que rivalizam com modelos 10 vezes maiores.”

Redefinindo IA multimodal com modelos menores

SmolVLM-256M-Instruir e SmolVLM-500M-Instruct são projetados para maximizar o desempenho e minimizar o consumo de recursos. Modelos multimodais como esses processam e interpretam. múltiplas formas de dados, como texto e imagens, simultaneamente, tornando-os versáteis para diversas aplicações.

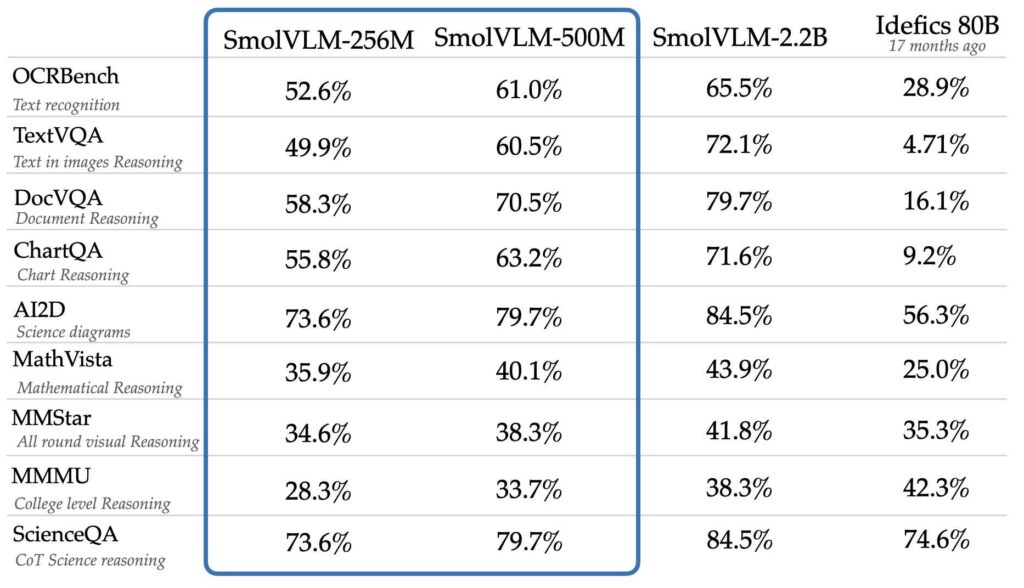

Apesar do tamanho reduzido, os modelos alcançam desempenho. níveis comparáveis ou melhores do que modelos muito maiores, como Idefics 80B, de acordo com benchmarks como AI2D, que avalia a capacidade de compreender e raciocinar com diagramas científicos.

Idefics 80B é uma reprodução de acesso aberto de Modelo de linguagem visual Flamingo de código fechado da DeepMind, desenvolvido por Hugging Face, que pode processar imagens e entradas de texto.

Fonte: Hugging Face

Fonte: Hugging Face

O desenvolvimento desses modelos contou com dois conjuntos de dados proprietários: The Cauldron e Docmatix. O Caldeirão é uma coleção com curadoria de 50 conjuntos de dados de imagem e texto de alta qualidade que enfatiza o aprendizado multimodal, enquanto o Docmatix é adaptado para compreensão de documentos, combinando arquivos digitalizados com legendas detalhadas para melhorar a compreensão.

A equipe M4 da Hugging Face, conhecida por sua experiência em IA multimodal, liderou a criação desses conjuntos de dados.

Em seu anúncio, a Hugging Face enfatizou a importância de tornar a IA mais acessível. “Os desenvolvedores nos disseram que precisavam de modelos para laptops ou até mesmo navegadores, e esse feedback impulsionou a criação desses modelos”, afirmou a equipe. Esses modelos abordam limitações práticas que muitos desenvolvedores enfrentam, especialmente quando trabalham com dispositivos de consumo ou operações conscientes do orçamento.

Inovações técnicas em modelos SmolVLM

Um fator crítico para o sucesso dos modelos está em seu design subjacente. O Hugging Face tomou decisões estratégicas para aumentar a eficiência e o desempenho. precisão. Uma dessas decisões foi a adoção de um codificador de visão menor, SigLIP base patch-16/512, em vez do maior SigLIP 400M SO usado em modelos anteriores como SmolVLM 2B.

Este codificador menor processa imagens em resoluções mais altas sem aumentar significativamente a sobrecarga computacional.

Outra inovação envolve a tokenização, um processo chave em modelos de IA onde os dados são divididos em unidades menores ( tokens) para análise. Ao otimizar a forma como os tokens de imagem são processados, o Hugging Face reduziu a redundância e melhorou a capacidade dos modelos de lidar com dados complexos.

Por exemplo, separadores de subimagem, anteriormente mapeados para vários tokens, agora são representados por um único token, melhorando a estabilidade do treinamento e a qualidade da inferência. “Com o SmolVLM, estamos redefinindo o que modelos menores de IA podem alcançar”, explicou a equipe em seu anúncio.

Essas opções de design permitem que os modelos SmolVLM codifiquem imagens a uma taxa de 4.096 pixels por token, um valor significativo. melhoria em relação aos 1.820 pixels por token vistos nas versões anteriores. O resultado é uma compreensão visual mais nítida e velocidades de processamento mais rápidas.

Perspectiva SmolVLM para. Aplicativos

Os benefícios práticos do SmolVLM vão além dos casos de uso típicos de IA. Os desenvolvedores podem integrar esses modelos perfeitamente aos fluxos de trabalho existentes usando ferramentas como Transformers, MLX e ONNX. pontos de verificação ajustados para ambos os modelos, permitindo fácil personalização para tarefas específicas.

Os modelos são particularmente adequados para análise e recuperação de documentos. Em colaboração com a IBM, o Hugging Face foi aplicado. SmolVLM-256M ao seu sistema de documentação, demonstrando seu potencial na automatização de fluxos de trabalho e na extração de insights de arquivos digitalizados. Os primeiros resultados desta parceria mostraram-se promissores, destacando a versatilidade do modelo.

Além disso, os modelos SmolVLM estão disponíveis sob uma Apache Licença 2.0, garantindo acesso aberto para desenvolvedores em todo o mundo. Este compromisso com o desenvolvimento de código aberto está alinhado com a missão da Hugging Face de democratizar a IA, permitindo que mais organizações adotem tecnologias avançadas sem enfrentar custos proibitivos.

Equilibrar custo e desempenho

A introdução do SmolVLM-256M e do SmolVLM-500M completa a família SmolVLM, que agora inclui uma gama completa de modelos de linguagem de visão menores projetados para diversas aplicações.

Esses modelos são particularmente eficazes para ambientes com recursos limitados, como laptops de consumo ou aplicativos baseados em navegador. A variante 256M, como o menor modelo de linguagem Vision já lançado, se destaca por sua capacidade de oferecer desempenho robusto em dispositivos com menos de 1 GB de RAM.

A Hugging Face prevê que o SmolVLM se tornará uma solução prática para desenvolvedores que lidam com grandes-escalar o processamento de dados dentro do orçamento.