A Nvidia anunciou um conjunto de ferramentas para atender à crescente necessidade de confiança, segurança e confiabilidade em sistemas de IA de agentes.

Conhecidos como Nvidia Inference Microservices (NIMs), as novas ofertas são projetados para ajudar as empresas a implantar aplicativos de IA que cumpram as diretrizes de segurança e evitem resultados indesejados.

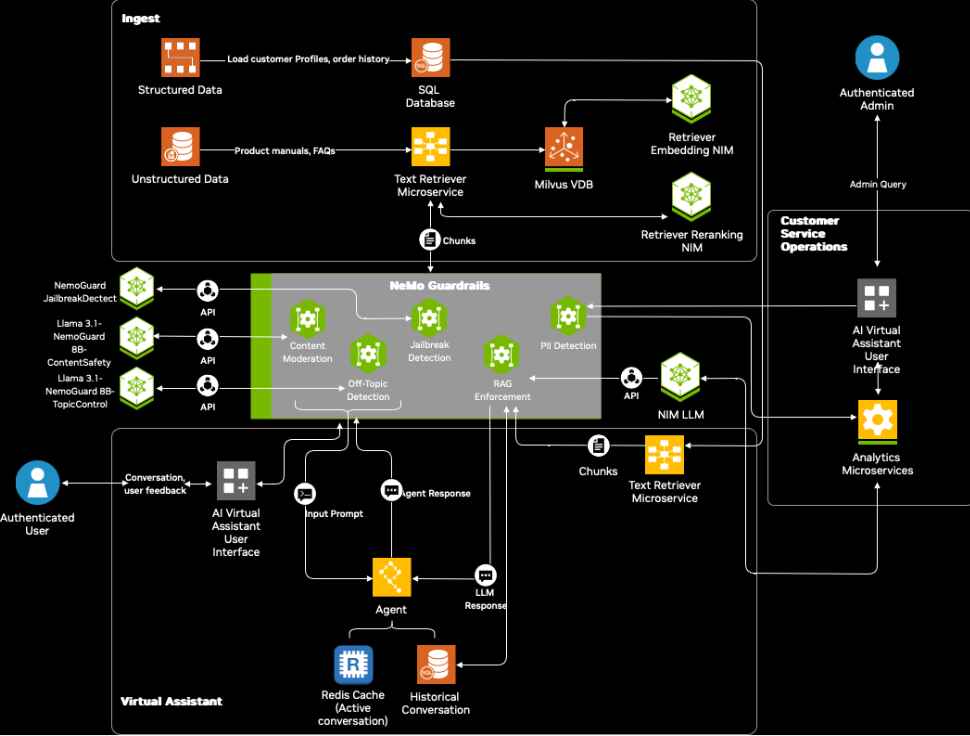

Como parte da estrutura NeMo Guardrails, esses microsserviços fornecem soluções especializadas para moderar conteúdo, manter limites de conversação e detecção de tentativas de contornar as salvaguardas.

Kari Briski, vice-presidente de modelos empresariais de IA da Nvidia, enfatizou a importância de garantir a segurança da IA nas aplicações atuais. “Os agentes de IA estão transformando rapidamente os setores ao automatizar as interações, mas garantir sua segurança e confiabilidade é fundamental”, afirmou ela no anúncio oficial.

[conteúdo incorporado]

Enfrentando os desafios de segurança de IA com microsserviços especializados

A Agentic AI, uma forma de inteligência artificial que executa tarefas de forma autônoma, tem sido cada vez mais adotada em setores como varejo, saúde e automotivo

Embora esses sistemas aumentem a eficiência. e envolvimento do cliente, eles também levantam preocupações sobre resultados prejudiciais, privacidade de dados e vulnerabilidades adversárias. Os NIMs da Nvidia visam mitigar esses riscos com três soluções direcionadas:

O Content Safety NIM, treinado no conjunto de dados proprietário Aegis Content Safety Dataset, foi projetado para detectar e bloquear conteúdo inadequado ou prejudicial resultados de sistemas de IA Este conjunto de dados, que consiste em mais de 35.000 amostras anotadas por humanos, permite que os modelos identifiquem e respondam ao conteúdo tóxico de forma eficaz.

Relacionado: NVIDIA avança Agentic AI com modelos Llama e Cosmos Nemotron

A Nvidia planeja disponibilizar publicamente o conjunto de dados por meio do Hugging Face ainda este ano, expandindo sua acessibilidade para desenvolvedores e pesquisadores.

O Topic Control NIM garante que as interações geradas por IA permaneçam dentro dos limites definidos, evitando que os sistemas se desloquem em tópicos irrelevantes ou não autorizados. Essa ferramenta é particularmente útil em cenários de atendimento ao cliente onde respostas consistentes e contextualmente relevantes são essenciais.

O Jailbreak Detection NIM aborda a crescente preocupação com ataques adversários. Ao analisar as entradas em um conjunto de dados de 17.000 tentativas conhecidas de jailbreak, o microsserviço identifica e bloqueia prompts maliciosos projetados para substituir as proteções do sistema.

Fluxograma de assistentes virtuais inteligentes de IA seguros para atendimento ao cliente com NeMo Guardrails (Imagem: Nvidia) Briski destacou a eficiência dessas ferramentas, afirmando: “Modelos pequenos como os de a coleção NeMo Guardrails fornece menor latência, permitindo integração perfeita em ambientes com recursos limitados, como armazéns ou hospitais.”

Fluxograma de assistentes virtuais inteligentes de IA seguros para atendimento ao cliente com NeMo Guardrails (Imagem: Nvidia) Briski destacou a eficiência dessas ferramentas, afirmando: “Modelos pequenos como os de a coleção NeMo Guardrails fornece menor latência, permitindo integração perfeita em ambientes com recursos limitados, como armazéns ou hospitais.”

Equilibrando segurança e desempenho de IA

A O aspecto crítico da abordagem da Nvidia é equilibrar a necessidade de segurança com a demanda por alto desempenho. A Nvidia diz que os primeiros testes indicam como os novos microsserviços adicionam apenas cerca de meio segundo de latência, ao mesmo tempo que melhoram as medidas de segurança em 50%.

Relacionado: NVIDIA revela modelo de IA Fugatto para música, vozes e efeitos sonoros

Esse nível de otimização aborda uma das preocupações mais comuns em IA corporativa —garantindo tempos de resposta rápidos sem comprometer a segurança.

“Dependendo da interação do usuário, muitos LLMs ou interações diferentes podem ser feitos, e você precisa proteger cada uma delas”, disse Kari Briski.

Casos de uso empresarial e adoção pela indústria

Várias grandes empresas já incorporaram o NeMo Guardrails em seus fluxos de trabalho de IA para aumentar a segurança e a confiabilidade. , usa essas ferramentas para melhorar as interações com os clientes e garantir a precisão das respostas geradas por IA

Cerence AI, líder em IA automotiva, aproveita os microsserviços para potencializar tecnologias de assistente no carro. “O NeMo Guardrails nos ajuda a fornecer respostas confiáveis, conscientes e livres de alucinações, protegendo nossos modelos contra resultados prejudiciais”, explicou Nils Schanz, vice-presidente executivo de produto e tecnologia da Cerence AI.

Relacionado: Microsoft corta pedidos de GB200 da Nvidia e prioriza GB300 em meio a atrasos na produção

Além disso, empresas como Amdocs e Taskus estão utilizando essas ferramentas para criar produtos mais seguros e mais sistemas de IA confiáveis para envolvimento e suporte ao cliente. A Amdocs, fornecedora global de software para comunicações e mídia, usa NeMo Guardrails para aprimorar as interações com os clientes baseadas em IA.

Iniciativas de código aberto e implicações mais amplas

Para apoiar os desenvolvedores nos testes e no aprimoramento da segurança da IA, a Nvidia lançou o Garak, um kit de ferramentas de código aberto para identificar vulnerabilidades em sistemas de IA.

Garak simula cenários adversários, incluindo injeções imediatas e tentativas de jailbreak, permitindo que as organizações fortaleçam seus modelos de IA contra ameaças potenciais.

Os desenvolvedores também podem acessar tutoriais detalhados e projetos de referência para agilizar a implantação de NeMo Guardrails e microsserviços. Esses recursos abrangem uma variedade de casos de uso, desde chatbots de atendimento ao cliente até assistentes automatizados em ambientes de varejo e saúde.