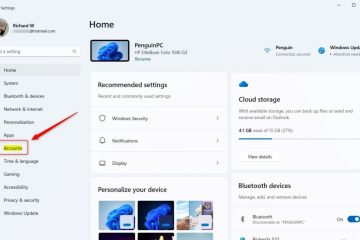

A OpenAI revogou o acesso à API para um desenvolvedor que usou sua API em tempo real para alimentar um sistema de rifle autônomo. O projeto, que envolvia uma torre robótica equipada com um rifle, poderia interpretar comandos verbais e executar ações de tiro simuladas.

O incidente ressalta preocupações crescentes sobre o potencial uso indevido de inteligência artificial no desenvolvimento de armas autônomas, levantando questões éticas e de segurança.

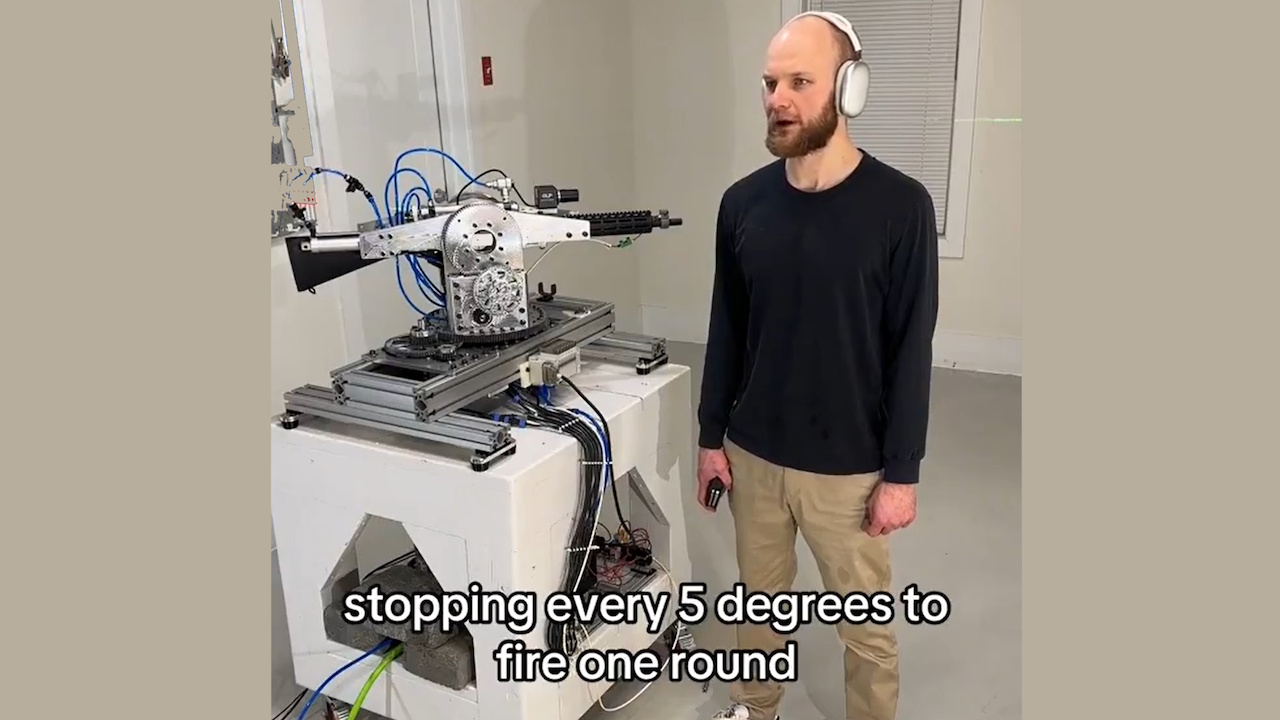

O desenvolvedor, conhecido online como “STS Innovations LLC,” compartilhou vídeos do sistema online, demonstrando sua funcionalidade. Em um clipe, o desenvolvedor emitiu o comando: “ChatGPT, estamos sob ataque do. frente esquerda e frente direita”, para ao que a torre respondeu imediatamente, girando e disparando balas de festim em direções específicas.

Simulação de mira/disparo com laser #robotics #electronics

Uma voz sintetizada acrescentou: “Se precisar de mais ajuda, é só me avisar”. A demonstração arrepiante destacou como as ferramentas de IA para consumidores podem ser facilmente adaptadas para usos potencialmente prejudiciais.

Atualização no sistema de rastreamento #robotics #visão #electronics

Aplicação Rápida de Políticas da OpenAI

A OpenAI, conhecida por suas políticas rígidas contra o uso de sua tecnologia em armamento, respondeu prontamente. Um porta-voz explicou: “Identificamos proativamente esta violação de nossas políticas e notificamos o desenvolvedor para cessar esta atividade antes de receber sua consulta.”

A empresa enfatizou sua proibição de usar suas ferramentas para criar ou operar armas ou automatizar sistemas que possam representar riscos à segurança pessoal.

Sistema de gerenciamento de recuo, demonstração rápida #robotics #electronics #cnc

A API Realtime, uma ferramenta projetada para aplicativos interativos permitiram ao desenvolvedor transformar comandos de linguagem natural em entradas acionáveis para a torre robótica.

Embora a API seja destinada a casos de uso benéficos, como melhorar a acessibilidade ou melhorar as interações com os clientes, esse uso indevido demonstra os desafios da regulamentação de tecnologias de uso duplo.

Relacionado: OpenAI e Anduril forjam parceria para defesa militar de drones dos EUA

Implicações mais amplas para IA e armamento

Este caso reacendeu debates sobre a ética de armas autônomas. Estes sistemas, capazes de selecionar e engajar alvos sem supervisão humana, colocam desafios jurídicos e morais complexos.

As Nações Unidas há muito defendem regulamentações mais rígidas sobre IA na guerra, alertando que os sistemas autônomos podem violar as leis internacionais e diminuir a responsabilidade.

Relacionado: Antrópico Parceria com Palantir, AWS para IA na Inteligência e Forças Armadas dos EUA

Um relatório do Washington Post recentemente detalhou exemplos preocupantes de implantação de IA nas forças armadas operações, incluindo alegações de que Israel usou IA para selecionar alvos de bombardeio.

O relatório observou: “Em certos momentos, a única corroboração necessária era que o alvo fosse um homem”. Esses casos destacam os riscos de confiar na IA em decisões de vida ou morte e o potencial de violência indiscriminada. violência.

Relacionado: Boina Verde usou ChatGPT para explosão de caminhão cibernético, polícia divulga registros de bate-papo

O papel da OpenAI em tecnologias de defesa

Embora a OpenAI aplique políticas que proíbem o armamento, a sua parceria com a Anduril Industries – uma empresa especializada em soluções de defesa baseadas em IA – levanta questões sobre a sua posição

A colaboração visa melhorar a inteligência no campo de batalha e melhorar a defesa dos drones. A OpenAI descreve esses esforços como defensivos, mas os críticos argumentam que eles contribuem para a militarização mais ampla das tecnologias de IA.

O setor de defesa dos EUA, apoiado por um orçamento anual próximo de US$ 1 trilhão, depende cada vez mais de tecnologias avançadas para obter ganhos. uma vantagem estratégica Esta intersecção crescente entre empresas de IA e aplicações militares destaca os desafios de equilibrar a inovação tecnológica com considerações éticas.

Relacionado: Novo Consórcio de IA Palantir-Anduril para Enfrentar a Defesa dos EUA. Lacunas de dados

Riscos de acessibilidade e armamento DIY

A facilidade com que os indivíduos podem usar indevidamente ferramentas de IA e outras tecnologias, como a impressão 3D, agrava o problema. A aplicação da lei já encontrou casos de armamento DIY, como as supostas ações de Luigi Mangione, que supostamente usou peças impressas em 3D para montar armas de fogo. Estas tecnologias reduzem as barreiras para que os indivíduos criem sistemas autónomos com potencial letal.

O projeto do STS 3D demonstra como as ferramentas de IA acessíveis podem ser adaptadas para fins não intencionais. A ação decisiva da OpenAI neste caso demonstra o seu compromisso em prevenir o uso indevido, mas também sublinha a dificuldade de controlar totalmente a forma como as suas tecnologias são implementadas depois de entrarem no domínio público.

O incidente levanta questões mais amplas sobre a governação da OpenAI. Tecnologias de IA. Os defensores da regulamentação enfatizam a necessidade de padrões globais claros para garantir que o desenvolvimento da IA esteja alinhado com os princípios éticos. No entanto, alcançar o consenso entre nações com interesses e prioridades diferentes continua a ser uma tarefa difícil.