A Microsoft lançou o rStar-Math, uma continuação e refinamento de seu anterior estrutura rStar, para ampliar os limites dos modelos de linguagem pequena (SLMs) no raciocínio matemático.

Projetado para rivalizar com sistemas maiores, como o o1-preview da OpenAI, o rStar-Math alcança benchmarks notáveis na solução de problemas, ao mesmo tempo que demonstra como os modelos compactos podem funcionar em níveis competitivos. Este desenvolvimento mostra uma mudança nas prioridades da IA, passando da expansão para a otimização do desempenho para tarefas específicas.

Avançando do rStar para o rStar-Math

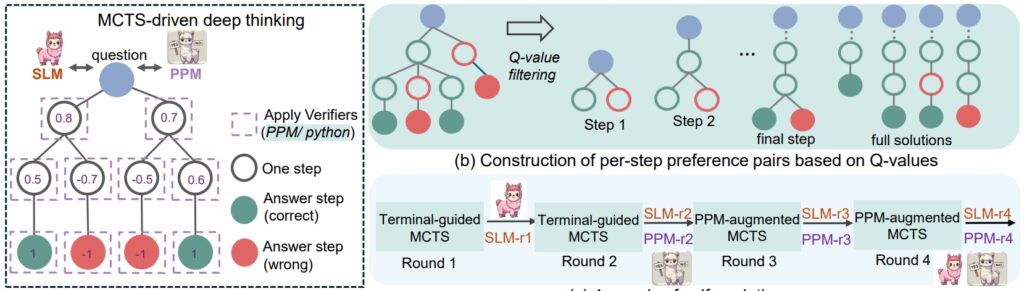

O rStar A estrutura do verão passado lançou as bases para aprimorar o raciocínio de SLM por meio do Monte Carlo Tree Search (MCTS), um algoritmo que refina soluções simulando e validando múltiplos caminhos.

rStar demonstrou que modelos menores podiam lidar com tarefas complexas, mas sua aplicação permaneceu geral. O rStar-Math baseia-se nesta base com inovações direcionadas sob medida para o raciocínio matemático.

O ponto central do sucesso do rStar-Math é sua metodologia de cadeia de pensamento (CoT) aumentada por código, onde o modelo produz soluções em ambos linguagem natural e código Python executável.

Essa estrutura de saída dupla garante que as etapas intermediárias de raciocínio sejam verificáveis, reduzindo erros e mantendo a consistência lógica. Os pesquisadores enfatizaram a importância desta abordagem, afirmando: “A consistência mútua reflete a prática humana comum na ausência de supervisão, onde o acordo entre os pares nas respostas derivadas sugere uma maior probabilidade de correção.”

Relacionado: modelo chinês DeepSeek R1-Lite-Preview visa a liderança da OpenAI em raciocínio automatizado

Além do CoT, rStar-Math apresenta um modelo de preferência de processo (PPM), que avalia e classifica etapas intermediárias com base na qualidade Ao contrário dos sistemas de recompensa tradicionais que muitas vezes dependem de dados ruidosos, o PPM prioriza a coerência lógica e a precisão, aumentando ainda mais a confiabilidade do modelo.

“O PPM aproveita o fato de que. , embora os valores Q ainda não sejam precisos o suficiente para pontuar cada etapa do raciocínio, apesar do uso de implementações extensas do MCTS, os valores Q podem distinguir com segurança as etapas positivas (corretas) das negativas (irrelevantes/incorretas) uns.

Assim, o método de treinamento constrói pares de preferência para cada etapa com base em valores Q e usa uma perda de classificação aos pares para otimizar a previsão de pontuação do PPM para cada etapa de raciocínio, alcançando uma rotulagem confiável. Essa abordagem evita métodos convencionais que usam diretamente valores Q como rótulos de recompensa, que são inerentemente barulhentos e imprecisos na atribuição gradual de recompensas.”

Finalmente, uma receita de autoevolução de quatro rodadas que constrói progressivamente uma fronteira modelo de política e PPM do zero.

procedimento de raciocínio rSTar-Math (Fonte: artigo de pesquisa)

procedimento de raciocínio rSTar-Math (Fonte: artigo de pesquisa)

Desempenho que desafia modelos maiores

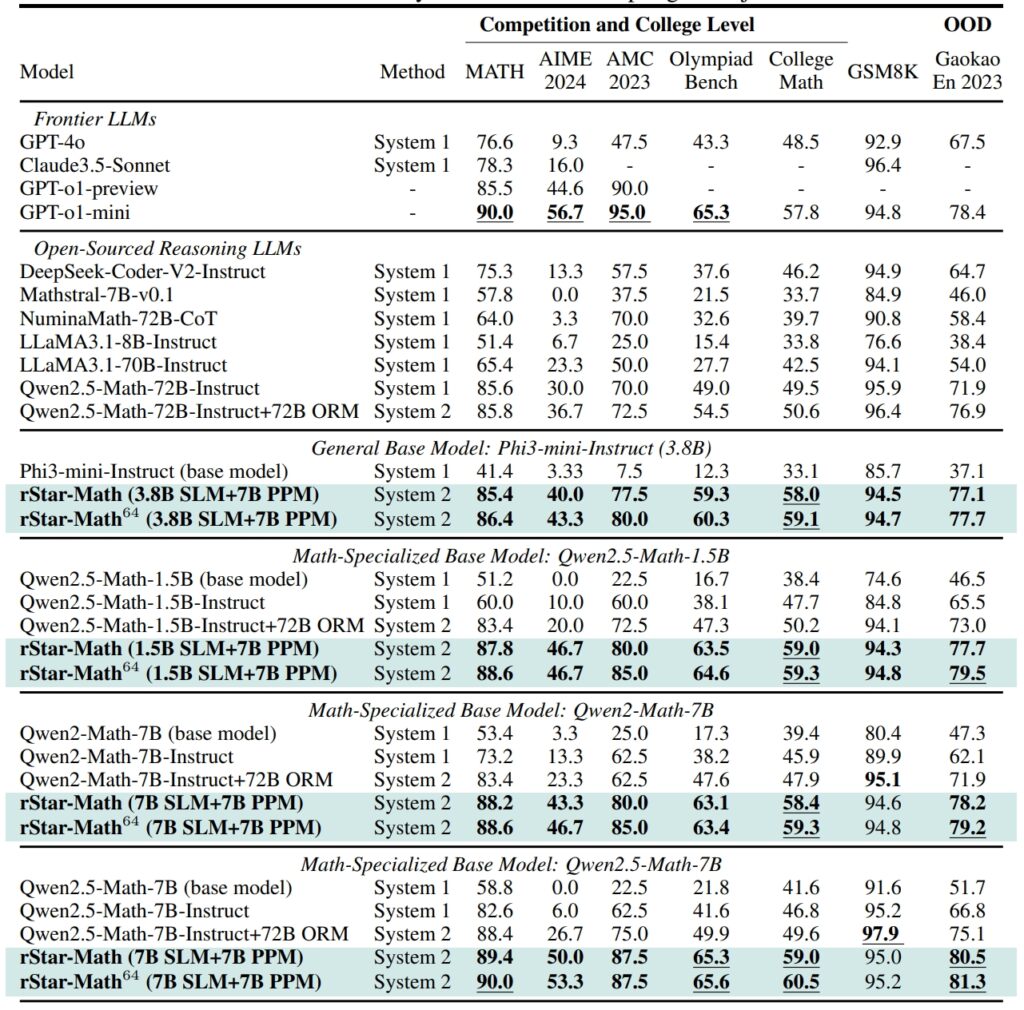

rStar-Math estabelece novos padrões em benchmarks de raciocínio matemático, alcançando resultados que rivalizam e, em alguns casos, superam os de sistemas de IA maiores

No conjunto de dados GSM8K, um teste de raciocínio matemático, a precisão de um modelo de 7 bilhões de parâmetros melhorou de 12,51% para 63,91% após a integração do rStar-Math no

Os resultados do conjunto de dados MATH foram igualmente impressionantes, com o rStar-Math alcançando uma taxa de precisão de 90%, superando o desempenho da visualização o1 da OpenAI.

Desempenho do rStar-Math e outros LLMs de fronteira no benchmarks matemáticos mais desafiadores (Fonte: artigo de pesquisa)

Desempenho do rStar-Math e outros LLMs de fronteira no benchmarks matemáticos mais desafiadores (Fonte: artigo de pesquisa)

Essas conquistas destacam a capacidade da estrutura de permitir que SLMs lidem com tarefas anteriormente dominadas por grandes modelos com uso intensivo de recursos. Ao enfatizar a consistência lógica e etapas intermediárias verificáveis, o rStar-Math aborda um dos desafios mais persistentes da IA: garantir um raciocínio confiável em espaços de problemas complexos.

Inovações técnicas que impulsionam o rStar-Math

A evolução do rStar para o rStar-Math introduz vários avanços importantes. A integração do MCTS continua a ser central para o quadro, permitindo ao modelo explorar diversos caminhos de raciocínio e priorizar os mais promissores.

A adição do raciocínio CoT, com foco na verificação de código, garante que os resultados sejam interpretáveis e precisos.

Relacionado: QwQ-32B do Alibaba-Preview entra na batalha de raciocínio de modelo de IA com OpenAI

Talvez o mais transformador seja o processo de treinamento autoevolutivo do rStar-Math. Ao longo de quatro rondas iterativas, o quadro refina o seu modelo político e o PPM, incorporando dados de raciocínio de maior qualidade em cada etapa.

Essa abordagem iterativa permite que o modelo melhore continuamente seu desempenho, alcançando resultados de última geração sem depender da destilação de modelos maiores.

Comparando o rStar-Math para o1 da OpenAI

Enquanto a Microsoft se concentra na otimização de modelos menores, a OpenAI continua a priorizar a expansão de seus sistemas.

O modo o1 Pro, introduzido em dezembro de 2024 como parte do plano ChatGPT Pro, oferece recursos avançados de raciocínio adaptados para aplicações de alto risco, como codificação e pesquisa científica. A OpenAI informou que o modo o1 Pro alcançou uma taxa de precisão de 86% no AIME e uma taxa de sucesso de 90% em benchmarks de codificação como Codeforces.

rStar-Math representa uma mudança na inovação de IA, desafiando o foco da indústria em modelos maiores como o principal meio de alcançar o raciocínio avançado. Ao aprimorar os SLMs com otimizações específicas de domínio, a Microsoft oferece uma alternativa sustentável que reduz os custos computacionais e o impacto ambiental.

Relacionado: Alinhamento deliberativo: estratégia de segurança da OpenAI para seus modelos de pensamento o1 e o3

O sucesso da estrutura no raciocínio matemático abre portas para aplicações mais amplas, desde a educação para pesquisas científicas.

Os pesquisadores planejam lançar o código e os dados do rStar-Math no GitHub, abrindo caminho para maior colaboração e desenvolvimento. Essa transparência reflete a abordagem da Microsoft para tornar as ferramentas de IA de alto desempenho acessíveis a um público mais amplo, incluindo instituições acadêmicas e organizações de médio porte.

Relacionado: SemiAnálise: Não, AI Scaling Isn Não está desacelerando

À medida que a competição entre a Microsoft e a OpenAI se intensifica, os avanços introduzidos pelo rStar-Math destacam o potencial dos modelos menores para desafiar o domínio de sistemas maiores. Ao priorizar a eficiência e a precisão, o rStar-Math estabelece uma nova referência para o que os sistemas compactos de IA podem alcançar.