Anthropic, o laboratório de IA conhecido por seu chatbot Claude, concordou em aplicar e manter salvaguardas que impedem que seus modelos gerem letras de músicas protegidas por direitos autorais.

Essa decisão faz parte de uma acordo legal com editoras musicais proeminentes, incluindo Universal Music Group e Concord Music Group, que acusaram a empresa de violação de direitos autorais por usar letras de músicas sem autorização em Conjuntos de dados de treinamento de IA.

Aprovado pelos EUA. Juíza distrital Eumi Lee, o acordo resolve partes de uma liminar solicitada pelos editores. Isso obriga a Anthropic a manter suas “proteções” existentes em Claude e modelos semelhantes para evitar a reprodução de material protegido por direitos autorais.

O caso marca um momento crucial na crescente tensão entre a inovação em IA e os direitos de propriedade intelectual.

As Alegações: Uso não licenciado de letras de músicas

O processo, iniciado em outubro de 2023, alega que a Anthropic treinou seus sistemas de IA usando letras de mais de 500 músicas sem obter licenças. Os editores citaram exemplos como Roar, de Katy Perry. e obras dos Rolling Stones e Beyoncé, acusando a ferramenta de IA de gerar reproduções quase literais dessas letras.

Um exemplo fornecido no processo descreveu Claude produzindo um “cópia quase idêntica” de Perry’s Roar. Os editores argumentaram que esse uso não autorizado não apenas viola a lei de direitos autorais, mas também prejudica seus relacionamentos com compositores e outras partes interessadas.

“O uso não licenciado de material protegido por direitos autorais pela Anthropic prejudica irreversivelmente os relacionamentos dos editores com parceiros-compositores atuais e potenciais,”afirma o processo, enfatizando o impacto mais amplo na confiança do setor.

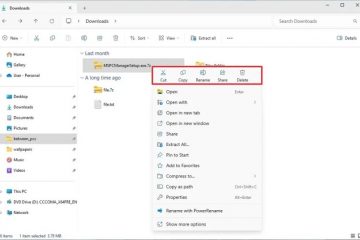

Guardas de proteção: como funcionam e seu papel na conformidade

Guardrails são medidas técnicas projetadas para limitar os resultados da IA, garantindo que modelos como o Claude não reproduzam material protegido por direitos autorais ou prejudicial. Essas proteções podem incluir filtros que bloqueiam resultados específicos, algoritmos projetados para detectar e impedir a reprodução literal de dados de treinamento e mecanismos de supervisão. para interações do usuário com o modelo.

A Antrópica afirma que suas proteções atuais são robustas e capazes de evitar tais resultados. Um porta-voz da empresa declarou: “Temos vários processos em vigor projetados para evitar tais violações. Nossa decisão de entrar nesta estipulação é consistente com essas prioridades.”

De acordo com o acordo, as editoras musicais estão autorizadas a notificar a Anthropic se essas medidas falharem. A empresa é obrigada a investigar e corrigir quaisquer deficiências imediatamente. Embora A Anthropic reserva-se o direito de otimizar seus métodos, não pode diminuir a eficácia de suas salvaguardas.

Uso justo e precedentes legais

A Anthropic defendeu seu uso de material protegido por direitos autorais sob a doutrina do “uso justo”, argumentando que o treinamento de modelos generativos de IA envolve a aplicação transformadora de dados. Os registros legais da empresa declaravam: “Continuamos ansiosos para mostrar que, de acordo com a lei de direitos autorais existente, o uso de material potencialmente protegido por direitos autorais no treinamento de modelos generativos de IA é um uso justo por excelência.”

No entanto, o os editores afirmam que esta prática desvaloriza o seu trabalho e infringe os mercados de licenciamento existentes. Eles argumentam que as empresas de IA contornam os canais estabelecidos para licenciamento, resultando em danos económicos e de reputação para artistas e editores.

Este processo é o primeiro a ser processado. focar em letras em conjuntos de dados de treinamento de IA, mas se alinha com disputas mais amplas, a OpenAI enfrentou acusações semelhantes sobre o uso de artigos de notícias, enquanto o New York Times e outros meios de comunicação levantaram preocupações sobre o conteúdo gerado por IA replicando seu trabalho.

Implicações da indústria e perspectivas futuras

O processo da Antrópico destaca os desafios de equilibrar o avanço tecnológico com as proteções de propriedade intelectual. À medida que a IA generativa se torna cada vez mais parte integrante de indústrias que vão do entretenimento ao jornalismo, as empresas estão sob pressão para navegar nestas complexidades legais e éticas.

Acordos de licenciamento proativos podem oferecer um caminho a seguir. A OpenAI já fez parceria com editoras como a TIME e a Associated Press, enquanto a Microsoft fechou acordos com a HarperCollins para usar seus títulos de não ficção para treinamento em IA.

O acordo da Anthropic com editoras musicais pode servir de modelo para resoluções futuras, demonstrando a importância de mecanismos de conformidade transparentes e aplicáveis. No entanto, como o juiz Lee ainda não se pronunciou sobre a questão mais ampla de saber se o treinamento não licenciado em IA constitui uso justo, o resultado do caso pode abrir um precedente.