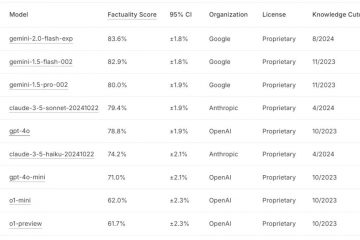

A OpenAI expandiu suas ofertas para desenvolvedores lançando a versão completa de seu modelo o1 por meio de sua API. Este modelo de raciocínio avançado, que se destaca em tarefas complexas e de várias etapas, apresenta novos recursos que prometem remodelar a forma como os desenvolvedores criam aplicativos baseados em IA.

A atualização faz parte da série de anúncios “12 Dias de OpenAI”, em que a empresa lança novos recursos e atualizações para seus principais produtos.

Juntamente com o modelo o1, a OpenAI tem também anunciou melhorias em sua API Realtime para interações de voz e um novo método de ajuste fino de preferências, proporcionando aos desenvolvedores uma flexibilidade sem precedentes.

O modelo o1-2024-12-17 substitui a versão o1-preview lançada no início deste ano. De acordo com a OpenAI, o modelo atualizado oferece “mais abrangente. e respostas precisas, especialmente para questões relacionadas à programação e negócios, e é menos provável que recuse solicitações incorretamente.”

Essas melhorias, juntamente com uma redução de 60% no uso de tokens de raciocínio, tornam o modelo o1 mais rápido, mais eficiente e mais versátil.

[conteúdo incorporado]

Avançar o raciocínio via API com o modelo o1

O modelo o1 da OpenAI foi projetado para lidar com tarefas que exigem consistência lógica e profundidade analítica, superando iterações anteriores em benchmarks como SWE-Bench verificado e AIME.

A OpenAI relata que a precisão das tarefas de programação aumentou de 52,3% para 76,6%, enquanto o desempenho em problemas matemáticos saltou de 42% para quase 80%.

Fonte: OpenAI

Um recurso de destaque é o suporte de saída estruturado, permitindo que os desenvolvedores gerem respostas em formatos predefinidos, como JSON.

Isso garante integração perfeita com sistemas externos, como APIs e bancos de dados, tornando o modelo ideal para aplicações de suporte ao cliente, logística e análise de dados.

O modelo também introduz recursos de raciocínio visual, permitindo a análise de imagens para tarefas como depuração ou pesquisa científica. Por exemplo, os desenvolvedores agora podem inserir dados visuais, como documentos digitalizados ou plantas, e receber respostas sensíveis ao contexto.

Além disso, um novo parâmetro de “esforço de raciocínio” permite que os desenvolvedores controlem quanto tempo o modelo gasta em cada tarefa, equilibrando precisão e eficiência.

A OpenAI explicou em seu blog: “Estamos avançando aumentando o acesso de forma incremental enquanto trabalhamos para expandir o acesso a níveis de uso adicionais e aumentar os limites de taxa.”

Aprimorando as interações de voz com a API em tempo real

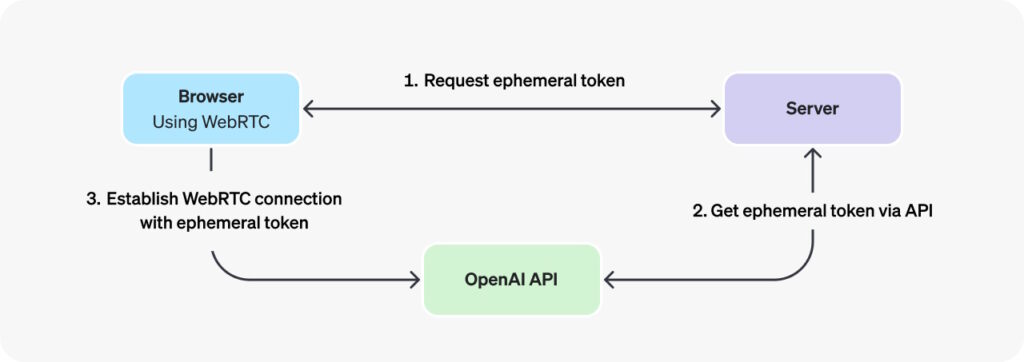

OpenAI também teve um desempenho significativo atualizações em seu API em tempo real, que possibilita interações de voz em tempo real. A adição do WebRTC, Web Real-Time Communication — um protocolo para comunicação de baixa latência — permite que os desenvolvedores criem aplicativos de voz integrados para tutores virtuais, assistentes e ferramentas de tradução. Ele permite conexões ponto a ponto (P2P) sem a necessidade de plug-ins ou software adicionais.

A OpenAI destacou as vantagens do WebRTC, afirmando: “Em cenários em que você gostaria de se conectar a um modelo em tempo real de um cliente inseguro pela rede (como um navegador da web), recomendamos usar o método de conexão WebRTC. O WebRTC está mais bem equipado para lidar com estados de conexão variáveis e fornece uma série de APIs convenientes para capturar entradas de áudio do usuário e reproduzir fluxos de áudio remotos do modelo.“

A implementação do WebRTC usa os chamados tokens efêmeros, chaves de API temporárias projetadas especificamente para autenticar com segurança aplicativos do lado do cliente ao se conectar à API OpenAI Realtime por meio de WebRTC. Seu objetivo é garantir um mecanismo de autenticação seguro e de curta duração que evite a exposição de chaves de API padrão confidenciais diretamente em ambientes de clientes, como navegadores da Web.

Imagem: OpenAI

Imagem: OpenAI

As atualizações da Realtime API simplificam o processo de desenvolvimento, reduzindo o código necessário para aplicações de voz e melhorando a qualidade do áudio e a precisão da resposta. Os desenvolvedores agora podem criar aplicativos que começam a formular respostas enquanto os usuários ainda estão falando, melhorando a capacidade de resposta.

Os ajustes de preços tornam os aplicativos de voz mais acessíveis. O custo dos tokens de áudio GPT-4o foi reduzido em 60%, enquanto os tokens de entrada em cache são agora 87,5% mais baratos. A OpenAI também introduziu o GPT-4o mini, uma opção econômica para desenvolvedores que buscam alternativas acessíveis, ao preço de US$ 10 por milhão de tokens de entrada.

Refinando o comportamento da IA com ajuste fino de preferência

O ajuste fino de preferência é um novo método de personalização que permite aos desenvolvedores refinar o comportamento do modelo com base em comparações emparelhadas de respostas. Ao contrário do ajuste fino tradicional, que depende de pares exatos de entrada-saída, o ajuste fino de preferência ensina o modelo a distinguir entre respostas preferidas e menos desejáveis.

OpenAI descreve este método como particularmente eficaz para tarefas subjetivas, como como adaptar o tom e o estilo na escrita criativa ou garantir a conformidade com requisitos específicos de formatação. De acordo com a OpenAI, os primeiros usuários, como uma empresa de análise financeira, relataram que o ajuste fino de preferência melhorou a precisão da resposta em 5% para consultas complexas e fora de distribuição.

“Começamos a testar o ajuste fino de preferência com parceiros de confiança que obtiveram resultados promissores até agora. Por exemplo, Rogo AI(abre em uma nova janela) está construindo um assistente de IA para analistas financeiros que divide consultas complexas em subconsultas.

Usando seu benchmark desenvolvido por especialistas, Rogo-Golden, eles descobriram que, embora o ajuste fino supervisionado enfrentasse desafios com a expansão de consultas fora da distribuição, como a falta de métricas como ARR para consultas como “quão rápido é empresa X crescendo”—O ajuste fino de preferência resolveu esses problemas, melhorando o desempenho de 75% de precisão no modelo básico para mais de 80%.”

Expandindo as opções do SDK para Desenvolvedores

Para oferecer suporte a uma variedade mais ampla de ambientes de programação, a OpenAI também introduziu SDKs oficiais para Go e Java, junto com eleas bibliotecas existentes para Python, Node.js e.NET. Esses SDKs simplificam a integração, permitindo que os desenvolvedores implantem modelos de IA em sistemas de back-end escalonáveis ou corporativos aplicativos.

O Go SDK foi projetado para aplicativos de servidor leves e eficientes, enquanto o Java SDK atende a soluções de nível empresarial, oferecendo tipagem forte e suporte robusto para projetos de grande escala. A documentação da OpenAI fornece orientações detalhadas para aproveitar essas novas ferramentas.

Anúncios anteriores durante os “12 dias de OpenAI”

Em 16 de dezembro, a OpenAI lançou seu ChatGPT recurso de pesquisa na Web ao vivo disponível para todos os usuários, permitindo que qualquer pessoa recupere informações atualizadas diretamente da Web.

O dia 14 de dezembro trouxe novas opções de personalização para o ChatGPT, permitindo que os usuários simplifiquem tarefas e gerenciem O Projects permite que os usuários agrupem bate-papos, arquivos e instruções personalizadas em pastas dedicadas, criando um espaço de trabalho organizado para gerenciar tarefas e fluxos de trabalho.

Como uma grande melhoria em seu modo de voz avançado para ChatGPT, o OpenAI está ativado. Em 12 de dezembro, foram adicionados recursos de visão, permitindo que os usuários compartilhem vídeos e telas ao vivo para análise e assistência em tempo real.

Em 11 de dezembro, a OpenAI lançou totalmente o Canvas, um espaço de trabalho de edição colaborativa que oferece ferramentas avançadas para texto e refinamento de código inicialmente lançado em versão beta em outubro de 2024, o Canvas substitui a interface padrão do ChatGPT por um design de tela dividida, permitindo que os usuários trabalhem em texto ou código enquanto participam de conversas com a IA.

A adição. A capacidade de execução do Python é um recurso de destaque do Canvas, permitindo que os desenvolvedores escrevam, testem e depurem scripts diretamente na plataforma. OpenAI demonstrou sua utilidade durante um evento ao vivo usando Python para gerar e refinar visualizações de dados. A OpenAI descreveu o recurso como”reduzindo o atrito entre a geração de ideias e a implementação”.

Em 9 de dezembro, a OpenAI lançou oficialmente o Sora, sua ferramenta avançada de IA para gerar vídeos a partir de prompts de texto, sinalizando uma nova era para IA criativa. Integrado a contas ChatGPT pagas, o Sora permite aos usuários animar imagens estáticas, estender vídeos existentes e mesclar cenas em narrativas coesas.

Lançado em 7 de dezembro foi Reinforcement Fine-Tuning como uma nova estrutura projetada para permitir a personalização de modelos de IA para aplicações específicas do setor. É a abordagem mais recente da OpenAI para melhorar os modelos de IA, treinando-os com conjuntos de dados e sistemas de classificação fornecidos pelo desenvolvedor./p>

Em 5 de dezembro, a OpenAI lançou o ChatGPT Pro, um novo nível de assinatura premium com preço de US$ 200 por mês, destinado a profissionais e empresas que buscam recursos avançados de IA para fluxos de trabalho de alta demanda.