Se você usa um PC compartilhado, é óbvio bloquear uma pasta que contém arquivos importantes. Também ajuda você a evitar a exclusão acidental por outras pessoas e mantém intacta a privacidade de todos. Então, como fazer isso?

Bem, este artigo mostra as duas maneiras mais rápidas de bloquear uma pasta com uma senha no seu Windows 10. Continue lendo.

Como fazer Proteja uma pasta com senha no Windows 10

Para bloquear uma pasta com senha no Windows 10, você pode criptografá-la. Para fazer isso, clique com o botão direito na pasta e selecione Propriedades. Em seguida, clique no botão Avançado e marque a caixa Criptografar conteúdo para proteger os dados. Além disso, você também pode usar comandos do Windows para proteger uma pasta com senhas.

Agora, vamos ver as etapas desses métodos para proteger uma pasta com senha.

1. Criptografe uma pasta com proteção por senha

Não existe esse aplicativo integrado de bloqueio de pasta no sistema operacional Windows 10. Em vez disso, você pode criptografar uma pasta com uma senha.

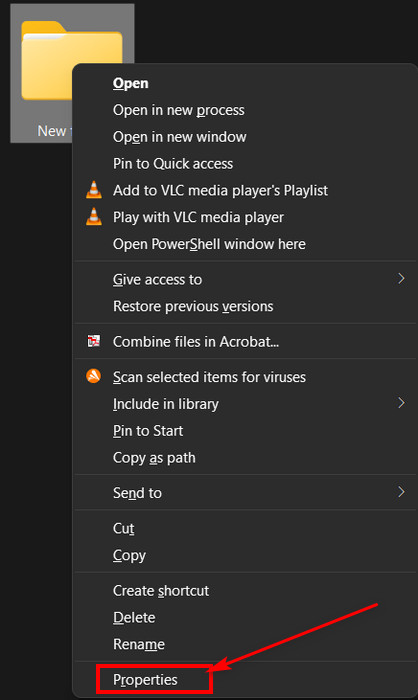

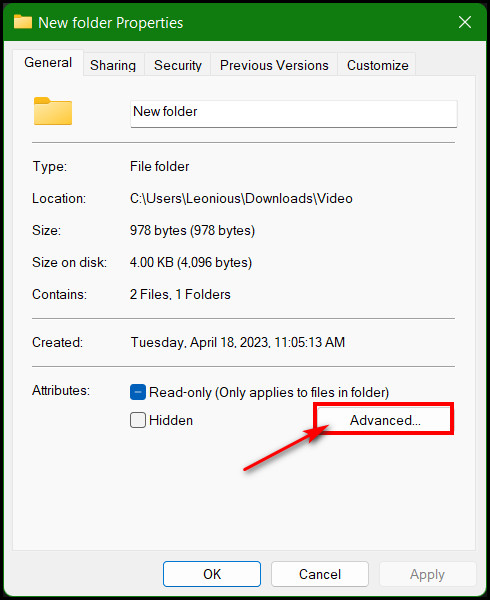

Clique com o botão direito na pasta. Selecione Propriedades no menu de contexto. Clique no botão Avançado.

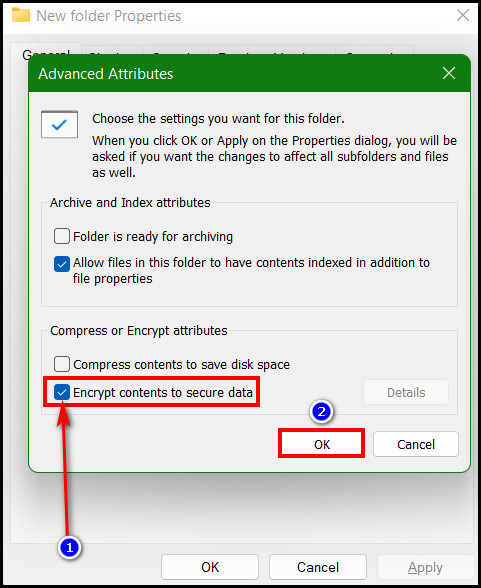

Clique no botão Avançado. Marque a caixa de Criptografar conteúdo para proteger opção de dados.Clique no botãoOK.

Marque a caixa de Criptografar conteúdo para proteger opção de dados.Clique no botãoOK.

Agora, você verá uma solicitação para fazer backup do certificado e da chave de criptografia de arquivo.

2. Use o comando do Windows para proteger uma pasta com senha

Se você não gosta de criptografar a pasta, pode bloqueá-la com o comando em lote do Windows. Nesse caso, você deve criar um novo arquivo de texto dentro da pasta que deseja bloquear. Em seguida, copie as linhas de comando em lote para ele e salve o arquivo com extensão.bat.

Esse arquivo de comando irá bloquear e desbloquear a pasta sempre que você quiser. Para procedimentos detalhados, siga estas etapas:

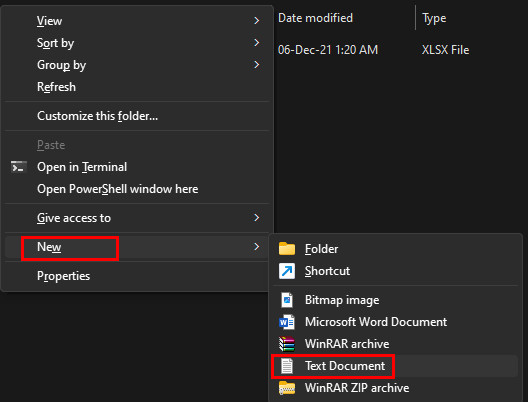

Vá para dentro da pasta onde estão os arquivos. Clique com o botão direito e selecione Novo > Documento de Texto. Clique duas vezes no arquivo de texto recém-criado para abri-lo.Copiar e cole as linhas de comando abaixo no arquivo de texto.

Clique duas vezes no arquivo de texto recém-criado para abri-lo.Copiar e cole as linhas de comando abaixo no arquivo de texto.

cls

@ECHO OFF

title Folder Locker

se EXISTIR “Painel de Controle.{21EC2020-3AEA-1069-A2DD-08002B30309D}”vá para UNLOCK

se NÃO EXISTIR Locker vá para MDLOCKER

:CONFIRME

echo Tem certeza que deseja para bloquear a pasta (S/N)

set/p “cho=>”

se %cho%==Y vá para LOCK

se %cho%==y vá para LOCK

se %cho %==n vá para END

if %cho%==N vá para END

echo Escolha inválida.

vá para CONFIRM

:LOCK

ren Locker “Control Painel.{21EC2020-3AEA-1069-A2DD-08002B30309D}”

attrib +h +s “Painel de Controle.{21EC2020-3AEA-1069-A2DD-08002B30309D}”

echo Pasta bloqueada

ir para Fim

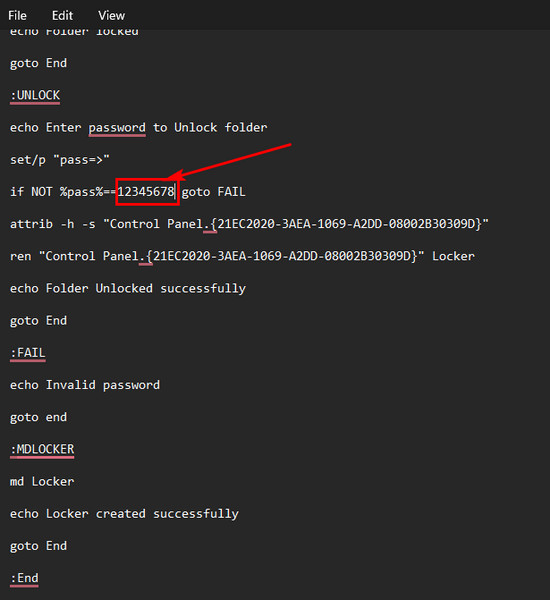

:UNLOCK

echo Digite a senha para desbloquear pasta

set/p “pass=>”

se NÃO %pass%==Sua-senha-aqui vá para FAIL

attrib-h-s “Painel de controle.{21EC2020-3AEA-1069-A2DD-08002B30309D}”

ren “Controle Painel.{21EC2020-3AEA-1069-A2DD-08002B30309D}”Armário

pasta echo desbloqueada com sucesso

goto End

:FAIL

echo Senha inválida

goto end

:MDLOCKER

md Locker

echo Locker criado com sucesso

goto End

:End

Encontrar a linha marcada que diz “Sua senha aqui“.Substitua a linha digitando a senha com a qual deseja bloquear.

Observação importante: Antes de inserir a senha, anote-a em algum lugar seguro. Se você esquecer a senha, você só terá que esquecer os arquivos!

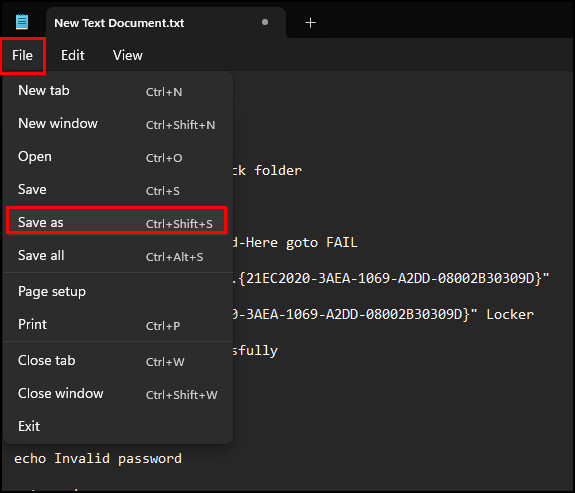

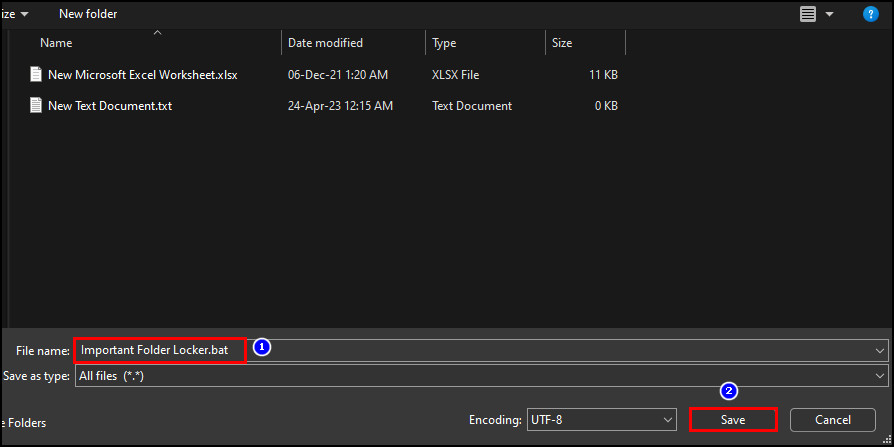

Clique em Arquivo > Salvar como. Renomeie o arquivo no campoNome do arquivo.Tipo.bat no último do nome do arquivo. Por exemplo, “Pasta importante Locker.bat”.Clique no ícone suspenso do campo Salvar como tipo e selecione Todos os arquivos.Clique o botão Salvar.

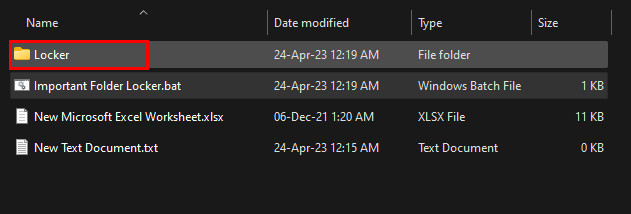

Renomeie o arquivo no campoNome do arquivo.Tipo.bat no último do nome do arquivo. Por exemplo, “Pasta importante Locker.bat”.Clique no ícone suspenso do campo Salvar como tipo e selecione Todos os arquivos.Clique o botão Salvar. Clique duas vezes no arquivo.bat recém-criado e a pasta Locker aparecerá.

Clique duas vezes no arquivo.bat recém-criado e a pasta Locker aparecerá. Mova todos os arquivos essenciais que você deseja bloquear no Pasta Locker.Clique duas vezes no arquivo .bat novamente para iniciar o processo de bloqueio.

Mova todos os arquivos essenciais que você deseja bloquear no Pasta Locker.Clique duas vezes no arquivo .bat novamente para iniciar o processo de bloqueio.

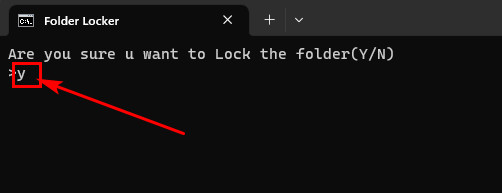

Agora, um console de comando aparecerá para confirmar o processo de bloqueio da pasta.

Digite Y para garantir o bloqueio da pasta e pressione Enter.

Depois disso, o comando o console será fechado e a pasta Locker desaparecerá. Se você deseja desbloquear a pasta:

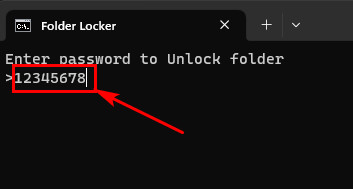

Clique duas vezes no arquivo.bat e um console de comando será aberto. Digite a senha que você forneceu no arquivo em lote de comando.Hit Digite depois.

A pasta Locker aparecerá novamente. Para bloquear a pasta novamente, repita os mesmos passos. Além disso, você pode aplicar os mesmos métodos se quiser bloquear uma pasta no Windows 11. Mesmo se quiser bloquear uma unidade em vez de apenas a pasta, você também pode fazer isso.

Como proteger uma unidade com senha no Windows 10

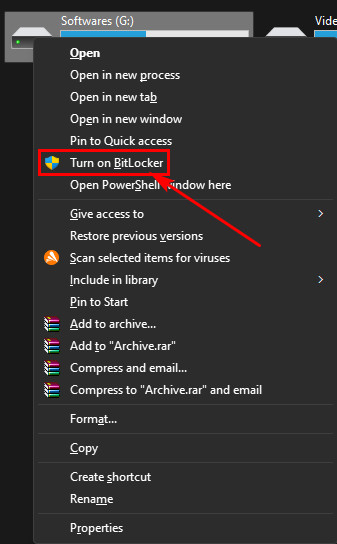

Você pode bloquear ou proteger uma unidade com uma senha ativando o recurso Criptografia de unidade BitLocker no >Painel de controle. Portanto, clique com o botão direito na unidade e selecione Ativar BitLocker. Marque a caixa para usar uma senha para desbloquear a unidade. Em seguida, defina a senha e salve a chave de recuperação de backup. Confira esta versão detalhada:

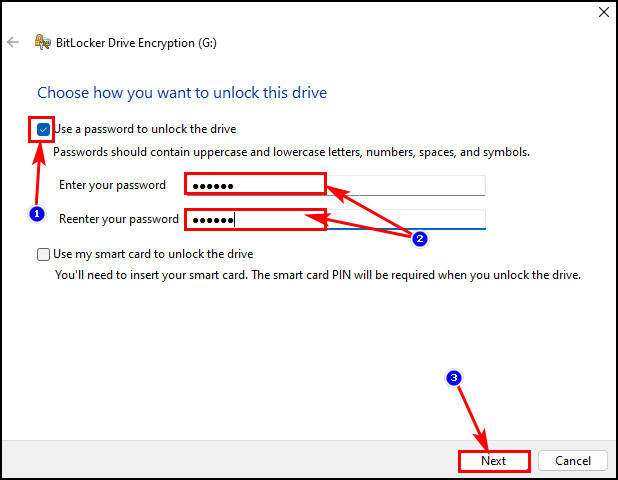

Clique com o botão direito na unidade que deseja bloquear com o BitLocker. Selecione a opção Ativar BitLock no menu de contexto. Marque a caixa para Usar uma senha para desbloquear a opção de unidade.Digite a senha e digite-a novamente para confirmação.Clique no botãoPróximo.

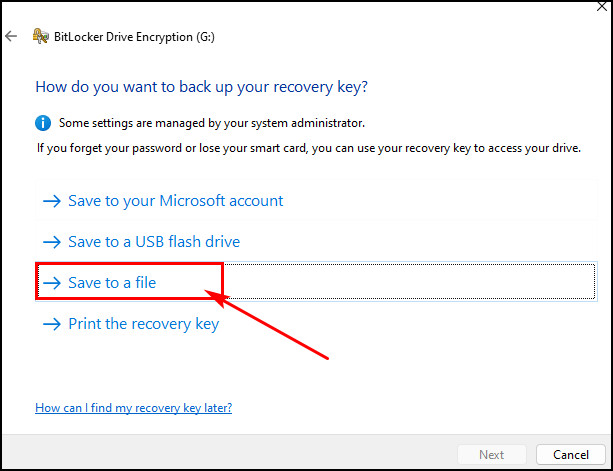

Marque a caixa para Usar uma senha para desbloquear a opção de unidade.Digite a senha e digite-a novamente para confirmação.Clique no botãoPróximo. Escolha a opção Salvar em um arquivo para salvar a chave de recuperação do BitLocker.

Escolha a opção Salvar em um arquivo para salvar a chave de recuperação do BitLocker.

Você pode selecionar a primeira opção para salvar a chave de recuperação na conta da Microsoft. Portanto, quando você esquecer a senha, poderá usar a chave de recuperação acessando sua conta da Microsoft.

Mas recomendo que você salve a chave de recuperação na unidade local, que é a segunda opção. Para que você faça uma cópia e salve onde quiser.

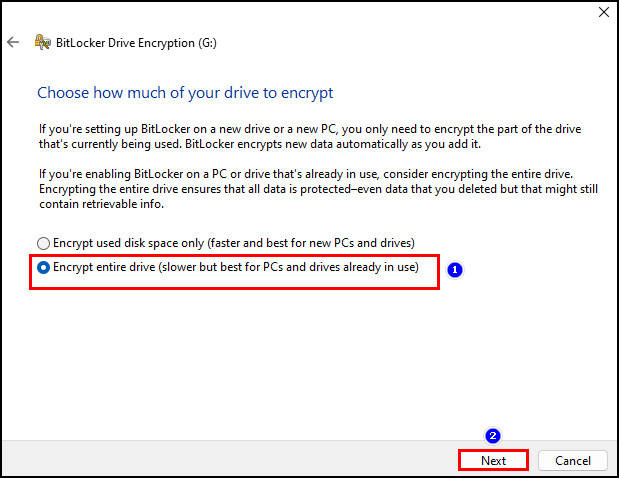

Navegue até o local de salvamento e clique emSalvar > Sim.Clique no botãoAvançarnovamente.Selecione o botão Criptografar a unidade inteira e clique em Avançar. Escolha o Novo modo de criptografia e clique no botão Avançar.

Escolha o Novo modo de criptografia e clique no botão Avançar.

No entanto, você pode selecionar oModo compatível se desejar. deseja.

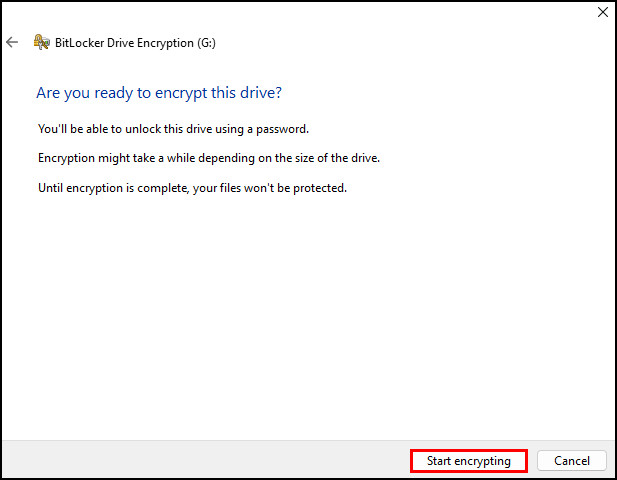

Clique no botão Iniciar criptografia para iniciar o processo de bloqueio da unidade.

Observação: Você deve salvar a chave de recuperação do BitLocker em uma unidade removível. Caso contrário, você não poderá salvá-lo.

Uma janela de status de progresso da criptografia será exibida. Você pode clicar no botãoPausarpara pausar o processo de criptografia ou deixá-lo continuar. Assim que o processo for concluído, selecione o botão Fechar para fechar a janela.

Dica profissional: se você esqueceu a senha do BitLocker, clique no botão Mais opções no campo de senha. Selecione a opçãoInserir chave de recuperação, insira a chave de recuperação de 48 dígitos e clique no botão Desbloquear.

Você também pode marcar outra opção que é a opção Desbloquear automaticamente neste PC se você deseja bloquear uma unidade removível com o BitLocker. No entanto, se quiser desligar o BitLocker:

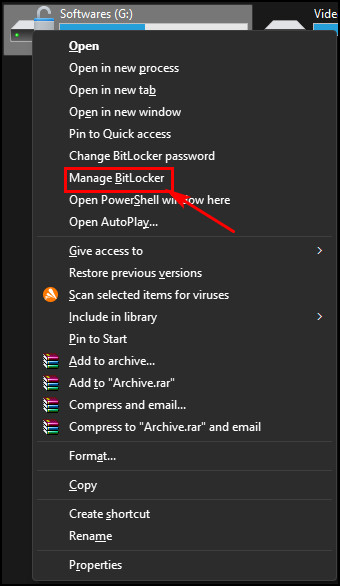

Desbloqueie a unidade bloqueada primeiro e clique com o botão direito nela. Escolha a opçãoGerenciar o BitLocker. Selecione a unidade bloqueada e clique em Desligar Opção BitLocker à direita.

Selecione a unidade bloqueada e clique em Desligar Opção BitLocker à direita.

Por que não consigo proteger uma pasta com senha?

Se você estiver usando o recurso BitLocker integrado do Windows 10 para bloquear a unidade inteira, você não conseguirá bloquear apenas uma pasta. Além disso, a proteção contra acesso não autorizado no dispositivo pode não suportar o bloqueio de uma pasta na unidade. Portanto, esses são os principais motivos pelos quais você não pode bloquear uma pasta no Windows 10.

Agora vamos explorar os motivos em detalhes.

1. BitLocker ativado

Se você já ativou o BitLocker para bloquear e criptografar toda a unidade com uma senha, talvez não bloqueie apenas uma pasta dentro dessa unidade. O fato é que quando você criptografa uma unidade, não será possível bloquear nada dentro dela.

2. Proteção de acesso não autorizado

O sistema operacional Windows 10 vem com um recurso de proteção de acesso não autorizado e pode proteger o PC contra acesso redundante. Portanto, se estiver ativado, bloquear uma pasta não funcionará.

3. Bugs no sistema operacional

Bugs ou falhas no sistema operacional são coisas comuns que podem alterar qualquer coisa dentro do sistema. Se você não conseguir bloquear uma pasta quando o BitLocker não estiver ativado ou outra proteção não estiver bloqueando as pastas bloqueadas, os bugs podem ser os culpados.

Portanto, devido aos fatos acima, você pode Não proteja uma pasta com senha no Windows 10. Da mesma forma, você não pode ativar o BitLocker na versão Windows 10 Home. Mas existem maneiras alternativas de ativar o BitLocker no Windows 10 Home.

Perguntas frequentes

Por que não consigo definir uma senha uma pasta no Windows 10?

Se você não conseguir proteger uma pasta com uma senha no Windows 10, o BitLocker pode estar ativado. No entanto, o Windows 10 não tem nenhum aplicativo específico para bloquear pastas, mas a conta da Microsoft já vem com proteção contra acesso não autorizado, o que também pode ser um motivo.

O que a criptografia de uma pasta faz?

Depois de criptografar um arquivo, documento ou pasta, ninguém poderá descriptografá-lo sem a chave de descriptografia. A descriptografia é como uma senha; sem ele, não faz sentido ter arquivos ou pastas criptografados.

Conclusão

Agora você sabe como bloquear sua pasta importante no Windows 10 com uma senha. Assim, ninguém poderá ver seus arquivos pessoais ou documentos importantes sem a sua permissão a partir de agora.

No entanto, se precisar de mais ajuda em relação ao sistema operacional Windows, acesse nosso site ou comente abaixo.