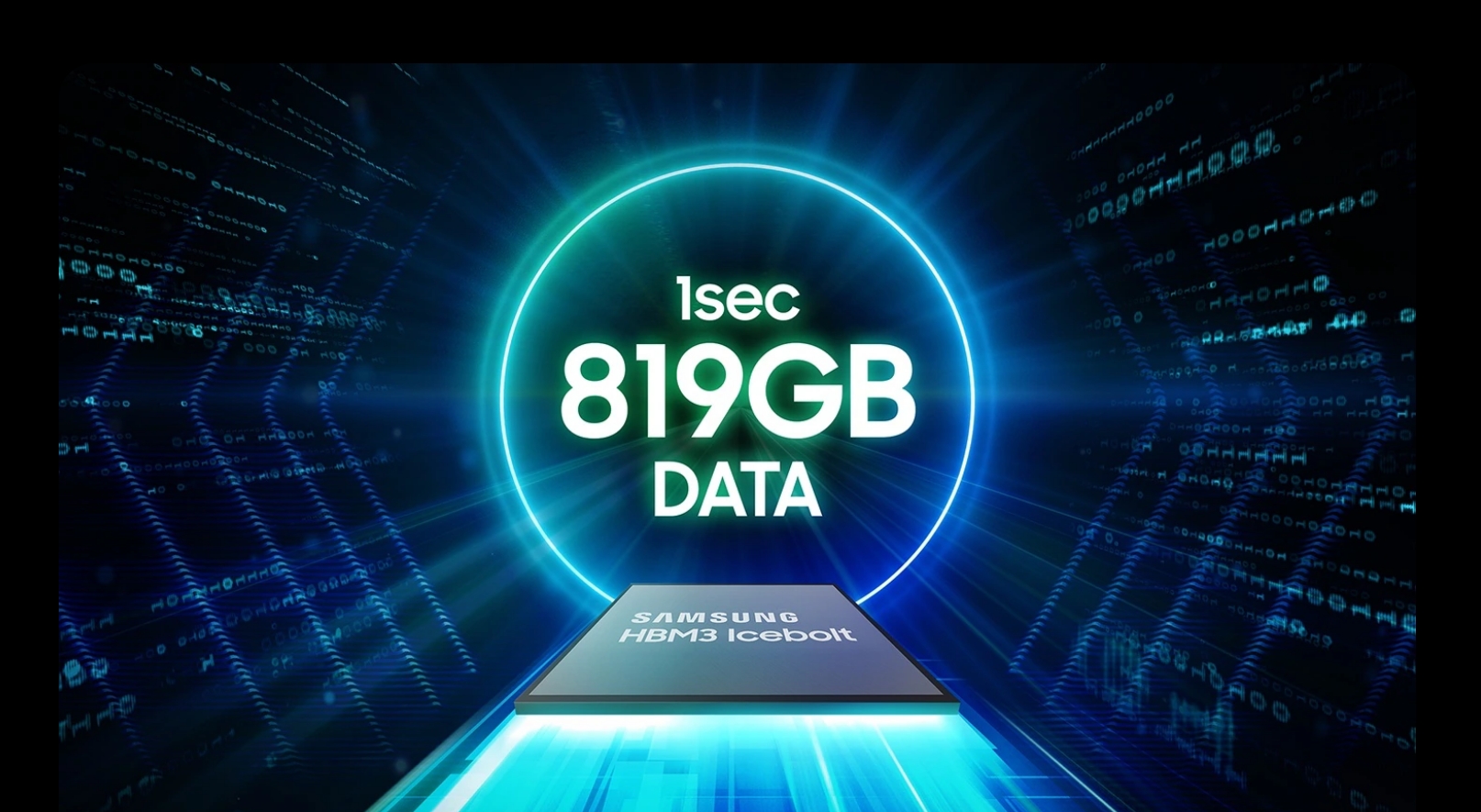

Os chips DRAM HBM3 da Samsung, projetados para uso em aceleradores de IA da Nvidia, encontraram problemas de desempenho durante testando. As principais preocupações giram em torno da geração excessiva de calor e do alto consumo de energia, o que levantou dúvidas sobre sua adequação às necessidades de computação de alto desempenho da Nvidia. HBM significa High Bandwidth Memory, usando um design de chip que fornece maior largura de banda do que os módulos DDR4 ou GDDR5, usando menos energia e em um formato substancialmente menor. Isso é conseguido empilhando até oito DRAM matrizes e uma matriz de base opcional que pode incluir circuito de buffer e lógica de teste.

Preocupações com consumo de calor e energia

Os problemas relatados de consumo de calor e energia não se limitam apenas aos chips HBM3. Os chips HBM3E da Samsung, lançados há alguns meses, também enfrentam problemas semelhantes. Esses problemas ficaram evidentes quando os resultados dos chips HBM3E de 8 e 12 camadas da Samsung foram lançados em abril de 2024.

Em contraste, a SK Hynix começou a fornecer chips HBM3E para a Nvidia em março de 2024, posicionando-se como um player chave no mercado HBM. SK Hynix é atualmente o maior fornecedor de chips HBM da Nvidia, essenciais para o funcionamento de aceleradores de IA. O domínio da Nvidia no mercado de IA, com uma participação de 80%, torna a sua certificação crucial para qualquer fabricante de chips HBM.

Esforços de otimização da Samsung

A Samsung reconheceu a necessidade de otimização em conjunto com os requisitos do cliente. A empresa tem trabalhado em estreita colaboração com os clientes para resolver esses problemas e há mais de um ano se esforça para passar nos rigorosos testes da Nvidia. As recentes mudanças de liderança da Samsung, incluindo a nomeação de um antigo especialista em desenvolvimento de DRAM e NAND flash, sublinham o seu compromisso em resolver estes desafios.

A certificação da Nvidia é vital para as ambições da Samsung no mercado HBM. Os problemas não resolvidos de consumo de calor e energia lançaram uma sombra sobre as perspectivas da Samsung. Permanece incerto se estes problemas podem ser resolvidos rapidamente. O endosso do CEO da Nvidia, Jensen Huang, ao chip de memória HBM3E 12H (12 camadas) da Samsung na conferência GTX AI 2024, onde escreveu “Jensen Approved”no chip, destaca a importância desta parceria.

A capacidade da Samsung de superar esses desafios não é crítica apenas para seus negócios, mas também para a indústria em geral. Tanto a AMD quanto a Nvidia desejam que a Samsung resolva esses problemas para garantir um fornecimento estável de chips HBM de vários fornecedores, o que ajudaria a manter os preços competitivos. A Samsung já está fornecendo chips HBM para a AMD, enfatizando ainda mais a necessidade de soluções de memória confiáveis e eficientes.

A Samsung pretende iniciar a produção em massa de chips HBM3E antes do final do segundo trimestre do ano. os esforços para otimizar seus chips HBM em colaboração com os clientes refletem sua determinação em garantir uma posição no competitivo mercado de hardware de IA. O resultado desses esforços impactará significativamente o cenário futuro de aceleradores de IA e computação de alto desempenho.