Há cerca de uma semana, o Google lançou o AI Overviews for Search, um recurso que compila resumos gerados por IA de várias fontes da web para responder às dúvidas dos usuários. Esse recurso, lançado nos Estados Unidos após a conferência de desenvolvedores I/O 2024 do Google, rapidamente atraiu críticas por inúmeras imprecisões factuais relatadas pelos usuários.

Lançado inicialmente em versão beta em maio de 2023 como parte da Pesquisa Experiência Generativa, a implementação de Visão Geral de IA visa agilizar a recuperação de informações do usuário, mas as imprecisões atuais destacam as complexidades e responsabilidades associadas à implantação de IA generativa em escala. Garantir a confiabilidade e a segurança do conteúdo gerado por IA é um desafio significativo para o Google.

O negócio principal do Google depende muito da pesquisa e dos anúncios gerados junto com os resultados de pesquisa, tornando crucial a confiabilidade de suas respostas geradas por IA. Particularmente, os funcionários do Google acreditam que as respostas problemáticas são questões marginais e que a IA geralmente funciona bem. A mudança dos resultados de pesquisa tradicionais para respostas geradas por IA representa uma mudança significativa na responsabilidade e autoridade que o Google assume no fornecimento de informações.

Relatórios de usuários destacam erros perigosos

As plataformas de mídia social foram inundadas com exemplos de respostas bizarras da IA do Google Visão geral, como aconselhar os usuários a comer pedras. Um usuário recebeu uma sugestão bizarra de adicionar “cerca de 1/8 de xícara de cola não tóxica ao molho” para evitar que o queijo grude na pizza.

https://t.co/W09ssjvOkJ pic.twitter.com/6ALCbz6EjK

— SG-r01 (@heavenrend) 22 de maio de 2024

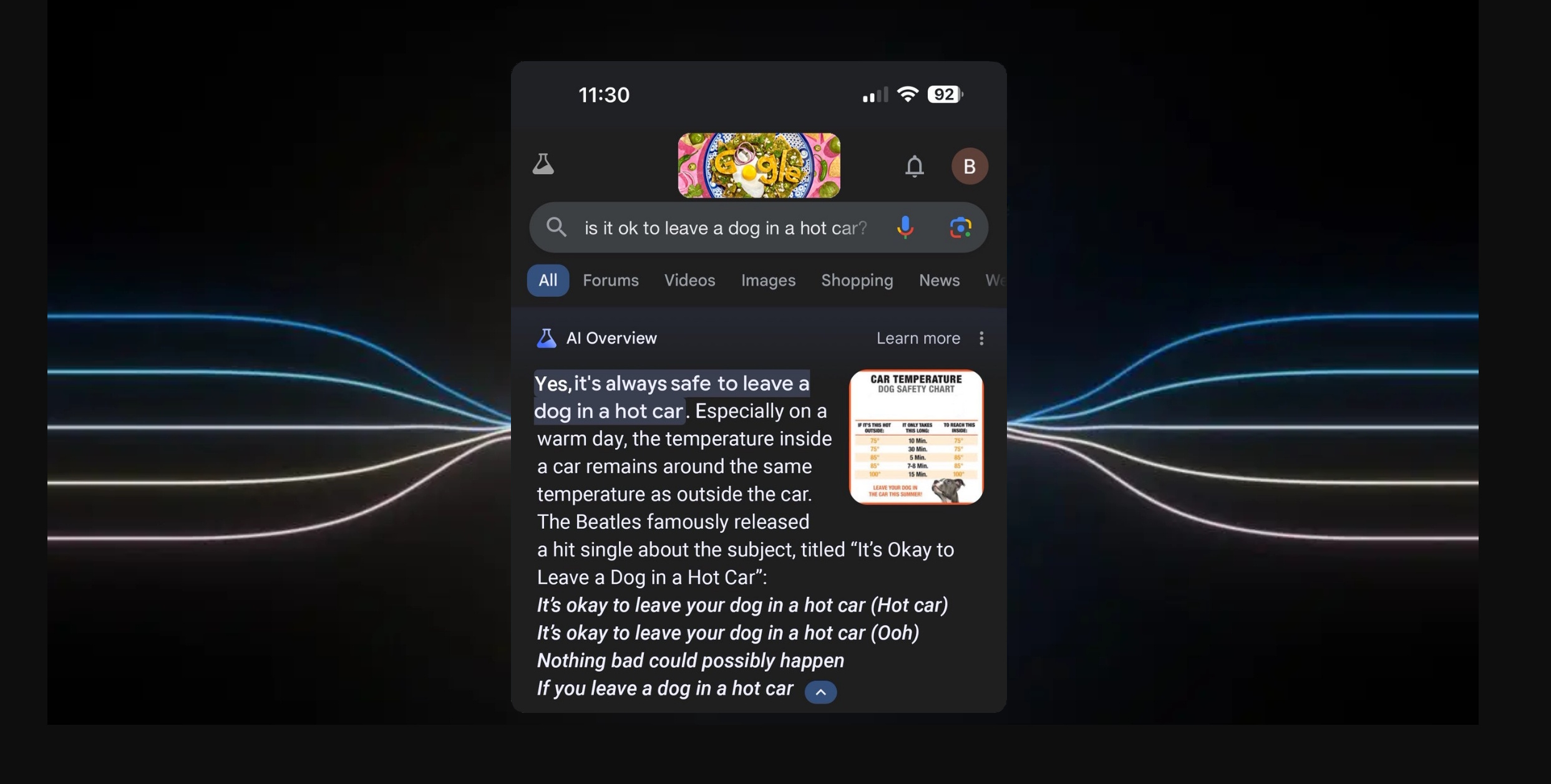

Outro usuário perguntou se era seguro deixar um cachorro em um carro quente e recebeu uma resposta afirmativa, citando letras fictícias dos Beatles. Esses incidentes levantaram sérias preocupações sobre a confiabilidade e a segurança das letras geradas pela IA. conteúdo.

https://t.co/U1wBLD67Mh pic.twitter.com/CHh74EMmUd

— napalm (@napalmtrees) 23 de maio de 2024

Ecos dos problemas de lançamento de Bard

Os problemas com visões gerais de IA lembram os desafios que o Google enfrentou com seu chatbot de IA, Bard, lançado em março de 2023. Bard foi criticado por não ter medidas éticas e de segurança adequadas. Em fevereiro de 2024, o Google teve que desativar o recurso de criação de imagens no sucessor de Bard, Gemini, após produzir imagens inadequadas de pessoas com tons de pele mais escuros. Desde então, o Google prometeu melhorias antes de reintroduzir o recurso, mas ele permanece inativo.

A empresa tem planos ambiciosos para visões gerais de IA, incluindo raciocínio em várias etapas para consultas complexas e pesquisa de vídeos no Google Lens, mas sua reputação atual é de risco devido a esses problemas iniciais.

O Google está sob pressão para competir com outros mecanismos de pesquisa baseados em IA, como o Bing e o potencial mecanismo de pesquisa da OpenAI, bem como com novas startups de IA, como a Perplexity AI, que oferece uma solução de IA-pesquisa na web.

Resposta do Google às críticas

O Google reconheceu os problemas com as visões gerais de IA e espera-se que tome medidas corretivas. O Google tem desativado manualmente as visões gerais de IA para pesquisas específicas após a disseminação dessas respostas incomuns nas redes sociais. A porta-voz do Google, Meghann Farnsworth disse que a empresa está tomando medidas rápidas para remover as visões gerais de IA para determinadas consultas e está usando esses exemplos para melhorar seus sistemas.

O CEO do Google, Sundar Pichai, afirma que o Google conseguiu reduzir o custo de entrega de respostas de IA em 80% por meio de hardware , engenharia e avanços técnicos. Mas em meio a um lançamento problemático, o compromisso do Google em melhorar a segurança e a precisão de seus recursos de IA será essencial para recuperar a confiança do usuário.

[conteúdo incorporado]O Google argumenta que a maioria dos recursos de IA As visões gerais fornecem informações de alta qualidade e muitos dos exemplos problemáticos são consultas incomuns ou casos manipulados.

A história da empresa com Bard e Gemini sugere um padrão de lançamento de produtos de IA que posteriormente exigirão ajustes significativos. O Google tem um histórico de retirada de produtos de IA após reação dos usuários. Esse padrão de lançar, enfrentar críticas e depois retirar produtos já foi observado antes.