Mark Russinovich, diretor de tecnologia do Microsoft Azure, destacou as crescentes preocupações de segurança associadas à IA generativa. Discursando na conferência Microsoft Build 2024 em Seattle, Russinovich ressaltou a diversidade uma série de ameaças que os Diretores de Segurança da Informação (CISOs) e os desenvolvedores devem enfrentar à medida que integram tecnologias generativas de IA. Ele enfatizou a necessidade de uma abordagem multidisciplinar à segurança de IA, que inclui o exame minucioso de ameaças de vários ângulos, como aplicações de IA, código de modelo subjacente, solicitações de API, dados de treinamento e possíveis backdoors.

Envenenamento de dados e classificação incorreta de modelos

Uma das principais preocupações abordadas por Russinovich é o envenenamento de dados. Nesses ataques, os adversários manipulam os conjuntos de dados usados para treinar modelos de IA ou de aprendizado de máquina, levando a resultados corrompidos. Ele ilustrou isso com um exemplo em que o ruído digital adicionado a uma imagem fez com que a IA classificasse erroneamente um panda como um macaco. Esse tipo de ataque pode ser particularmente insidioso porque mesmo uma pequena alteração, como uma inserção de backdoor, pode impactar significativamente o desempenho do modelo.

Russinovich também discutiu a questão de backdoors em modelos de IA. Embora muitas vezes vistos como uma vulnerabilidade, os backdoors também podem servir para verificar a autenticidade e integridade de um modelo. Ele explicou que backdoors poderiam ser usados para imprimir impressões digitais de um modelo, permitindo que o software verificasse sua autenticidade. Isso envolve adicionar perguntas exclusivas ao código que provavelmente não serão feitas por usuários reais, garantindo assim a integridade do modelo.

Técnicas de injeção imediata

Outra ameaça significativa que Russinovich destacou são as técnicas de injeção imediata. Estas envolvem a inserção de textos ocultos em diálogos, o que pode levar a fugas de dados ou influenciar o comportamento da IA para além das operações pretendidas. Vimos como o GPT-4 V da OpenAI é vulnerável a esse tipo de ataque. Ele demonstrou como um pedaço de texto oculto injetado em um diálogo poderia resultar no vazamento de dados privados, semelhante a explorações de scripts entre sites na segurança da web. Isso exige o isolamento de usuários, sessões e conteúdo uns dos outros para evitar tais ataques.

Na vanguarda das preocupações da Microsoft estão questões relacionadas à divulgação de dados confidenciais, técnicas de jailbreak para ultrapassar os modelos de IA e forçar terceiros-aplicativos de terceiros e plug-ins de modelo para contornar filtros de segurança ou produzir conteúdo restrito. Russinovich mencionou um método de ataque específico, o Crescendo, que pode contornar as medidas de segurança de conteúdo para induzir um modelo a gerar conteúdo prejudicial.

Abordagem holística para segurança de IA

Russinovich comparou os modelos de IA a “funcionários realmente inteligentes, mas juniores ou ingênuos” que, apesar de sua inteligência, são vulneráveis à manipulação e podem agir contra as políticas de uma organização sem supervisão estrita. necessidade de barreiras de proteção rigorosas para mitigar essas vulnerabilidades.

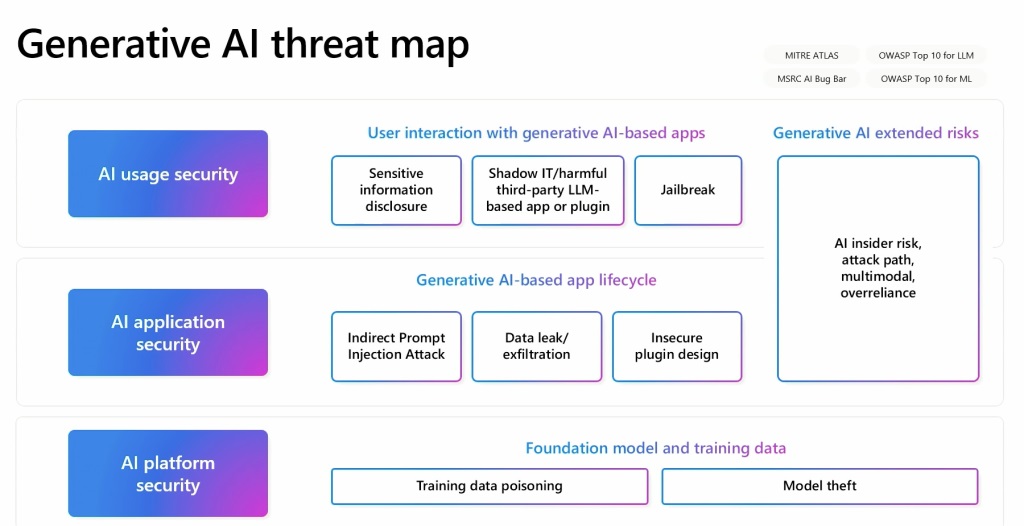

Russinovich desenvolveu um mapa generativo de ameaças de IA que descreve as relações entre esses vários elementos. Este mapa serve como uma ferramenta crucial para compreender e abordar a natureza multifacetada da segurança de IA. Ele forneceu um exemplo de como o plantio de dados envenenados em uma página da Wikipedia, conhecida por ser uma fonte de dados, pode levar a problemas de longo prazo, mesmo que os dados sejam corrigidos posteriormente. existe na fonte original.