O especialista em tecnologia e colunista de TI Mark Pesce identificou uma grande falha que afeta uma ampla gama de grandes modelos de linguagem (LLMs), incluindo aqueles usados em chatbots de IA populares como ChatGPT, Microsoft Copilot e Google Gemini. A falha, desencadeada por um aviso aparentemente simples, faz com que os modelos produzam resultados incoerentes e intermináveis, levantando preocupações sobre a estabilidade e confiabilidade desses sistemas de IA.

Resultados absurdos e contínuos

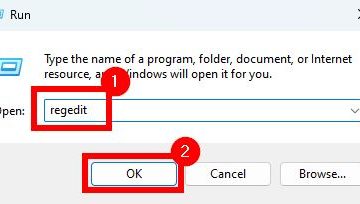

Como Pesce escreve em seu artigo para o The Register, o problema foi descoberto quando ele tentou criar um prompt para um Classificador baseado em IA. O classificador pretendia auxiliar um advogado de propriedade intelectual, automatizando tarefas que exigiam julgamentos subjetivos. Quando testado no Microsoft Copilot Pro, que usa o modelo GPT-4 da OpenAI, o prompt fez com que o chatbot gerasse resultados contínuos e sem sentido. Comportamento semelhante foi observado em outros modelos de IA, incluindo Mixtral e vários outros, com exceção do Claude 3 Sonnet da Anthropic. Pesce escreve:

“Comecei a escrever um prompt para esse classificador, começando com algo muito simples – não muito diferente de um prompt que eu alimentaria em qualquer chatbot. Para testá-lo antes de começar a consumir chamadas de API caras, coloquei-o no Microsoft Copilot Pro. Sob a marca Microsoft, o Copilot Pro está no topo do melhor modelo da OpenAI, GPT-4. Digitei a solicitação e pressione Enter.

O chatbot começou bem, nas primeiras palavras da resposta. Em seguida, tudo se tornou uma loucura balbuciante.”

Resposta e desafios da indústria

Pesce relatou o problema a vários provedores de serviços de IA, incluindo a Microsoft e o xAI de Elon Musk, que estão por trás dos produtos Grok AI e confirmaram a replicação dos produtos xAI da Grok. a falha em vários modelos, indicando um problema fundamental em vez de um bug isolado. No entanto, a resposta de outras empresas foi menos encorajadora. A equipe de segurança da Microsoft descartou o problema como um bug não relacionado à segurança, enquanto outras empresas proeminentes de IA não responderam. de forma adequada ou nenhuma. Algumas empresas não tinham informações de contato direto para relatar esses problemas críticos, destacando uma lacuna significativa em seus processos de suporte e segurança ao cliente.

Implicações para o desenvolvimento de IA

A descoberta ressalta os riscos potenciais associados à rápida implantação de tecnologias de IA sem suporte robusto e mecanismos de feedback. A falta de um canal claro para reportar e resolver bugs nestes sistemas representa uma ameaça à sua fiabilidade e segurança. Os especialistas do setor enfatizam a necessidade de as empresas de IA estabelecerem processos eficientes para lidar com o feedback dos clientes e resolver problemas prontamente. Até que essas medidas sejam implementadas, a segurança e a confiabilidade dos aplicativos baseados em IA permanecem em questão.

A experiência de Pesce aponta para uma questão mais ampla dentro da indústria de IA: a necessidade de testes mais rigorosos e de melhor comunicação entre os desenvolvedores. e usuários. À medida que a IA continua a se integrar em vários aspectos da vida diária e dos negócios, é fundamental garantir que esses sistemas sejam eficazes e seguros.