O CEO da OpenAI, Sam Altman, e Greg Brockman, cofundador e atualmente presidente da OpenAI, abordaram preocupações sobre a segurança da IA após a renúncia de Jan Leike. Eles ressaltaram o compromisso da OpenAI com testes rigorosos, feedback contínuo e colaboração com governos e partes interessadas para garantir protocolos de segurança robustos.

Mudanças de liderança e preocupações de segurança

Janeiro Leike, que co-liderou a equipa de superalinhamento com Ilya Sutskever, demitiu-se depois de expressar preocupações de que a segurança estava a ser deixada de lado em favor de avanços rápidos. As saídas de Leike e Sutskever destacaram divergências internas sobre a priorização da segurança versus inovação. A equipe de superalinhamento, formada há menos de um ano, foi encarregada de explorar maneiras de gerenciar IAs superinteligentes.

Jan Leike, em um tópico no X (antigo Twitter), explicou que discordava da liderança da empresa. sobre suas “prioridades centrais” por “bastante tempo”, levando a um “ponto de ruptura”. Leike afirmou que a “cultura e os processos de segurança da OpenAI ficaram em segundo plano em relação aos produtos brilhantes” nos últimos anos, e sua equipe lutou para obter o necessário recursos para seu trabalho de segurança.

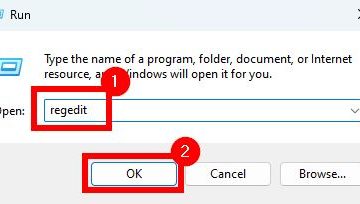

Altman respondeu primeiro com uma resposta curta à postagem de Leike na sexta-feira, reconhecendo que a OpenAI tem “muito mais a fazer” e está “comprometida em fazê-lo”, prometendo que uma postagem mais longa estava por vir. No sábado, Brockman postou uma resposta compartilhada dele e de Altman no X, expressando gratidão pelo trabalho de Leike e respondendo a perguntas após a demissão.

Estamos muito gratos a Jan por tudo que ele fez por OpenAI, e sabemos que ele continuará contribuindo para a missão externamente. À luz das questões que sua saída levantou, gostaríamos de explicar um pouco sobre como pensamos sobre nossa estratégia geral.

Primeiro, temos… https://t.co/djlcqEiLLN

— Greg Brockman (@gdb) 18 de maio de 2024

Brockman e Altman destacaram que a OpenAI “demonstrou repetidamente as incríveis possibilidades de ampliar o aprendizado profundo e analisou suas implicações”e apelaram à governação internacional da Inteligência Geral Artificial (AGI) antes de tais apelos se tornarem populares. Eles citaram o Quadro de Preparação da empresa, que prevê “riscos catastróficos” e procura mitigá-los, como forma de elevar a segurança do trabalho.

Na sua declaração detalhada, Altman e Brockman reconheceram as complexidades de garantir que as novas tecnologias são seguras e delinearam a sua abordagem à segurança da IA. Eles enfatizaram os esforços da OpenAI para aumentar a conscientização sobre os riscos e oportunidades da AGI, defender a governança internacional e desenvolver métodos para avaliar os sistemas de IA quanto a riscos catastróficos. Eles também destacaram o extenso trabalho realizado para implantar o GPT-4 com segurança e as melhorias contínuas com base no feedback dos usuários.

Direções Futuras e Pesquisa de Segurança

Olhando adiante, Altman e Brockman antecipam que os futuros modelos de IA serão mais integrados com aplicações do mundo real e capazes de executar tarefas em nome dos usuários. Eles acreditam que estes sistemas oferecerão benefícios substanciais, mas exigirão trabalho fundamental, incluindo supervisão escalonável e consideração cuidadosa dos dados de formação. Eles enfatizaram a importância de manter um alto padrão de segurança, mesmo que isso signifique atrasar os prazos de liberação.

Altman e Brockman concluíram afirmando que não existe um guia estabelecido para navegar no caminho para a AGI. Eles acreditam que a compreensão empírica guiará o caminho a seguir e estão empenhados em equilibrar os benefícios potenciais com a mitigação de riscos graves. Eles reafirmaram seu compromisso com a pesquisa de segurança em diferentes escalas de tempo e com a colaboração contínua com governos e partes interessadas.