A Hugging Face lançou uma iniciativa para fornecer ao público US$ 10 milhões em computação GPU, com o objetivo de aliviar a pressão financeira sobre equipes menores de desenvolvimento de IA. O programa, denominado ZeroGPU, foi apresentado pelo CEO Clem Delangue no X.

Abordando as disparidades de recursos

Delangue enfatizou a lacuna de recursos entre as grandes empresas de tecnologia e a comunidade de código aberto, que muitas vezes carece da infraestrutura necessária para treinar e implantar modelos de IA. Essa disparidade contribuiu para o domínio de aplicativos como o ChatGPT. ZeroGPU pretende preencher essa lacuna, oferecendo infraestrutura compartilhada para desenvolvedores de IA independentes e acadêmicos executarem demonstrações de IA em Hugging Face Spaces, reduzindo assim seus encargos financeiros.

GPU-Poor no more: super animado para lance oficialmente o ZeroGPU em beta hoje. Parabéns @victormustar e equipe pelo lançamento!

Nos últimos meses, a comunidade de IA de código aberto tem prosperado. Não apenas Meta, mas também Apple, NVIDIA, Bytedance, Snowflake, Databricks, Microsoft,… pic.twitter.com/6UzWvYhmpw

— clem 🤗 (@ClementDelangue) 16 de maio de 2024

Fundada em 2016, a Hugging Face tornou-se um fornecedor líder de modelos de IA de código aberto otimizados para diversas plataformas de hardware, graças a parcerias com gigantes da indústria como Nvidia, Intel e AMD. Delangue vê o código aberto como o futuro da inovação e adoção de IA, e a iniciativa ZeroGPU é um passo para democratizar o acesso a recursos essenciais.

Infraestrutura de GPU compartilhada

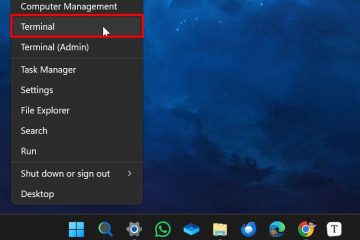

ZeroGPU estará acessível através do serviço de hospedagem de aplicativos da Hugging Face e utilizará os aceleradores A100 mais antigos da Nvidia de forma compartilhada. Ao contrário dos provedores de nuvem tradicionais, que muitas vezes exigem compromissos de longo prazo para aluguel de GPU com boa relação custo-benefício, a abordagem da Hugging Face permite um uso mais flexível, o que é benéfico para desenvolvedores menores que não podem prever antecipadamente o sucesso de seus modelos. Esta infraestrutura compartilhada é inicialmente limitada à inferência de IA em vez de treinamento, devido aos recursos computacionais substanciais necessários para treinar até mesmo modelos pequenos.

A documentação de suporte indica que as funções da GPU são limitadas a 120 segundos, o que é insuficiente para fins de treinamento. Um porta-voz da Hugging Face confirmou que o foco está principalmente na inferência, embora haja planos para explorar outras aplicações no futuro.

Implementação Técnica

A as especificações técnicas de como o Hugging Face consegue compartilhar os recursos da GPU de forma eficiente permanecem um tanto obscuras. Delangue menciona que o sistema pode “manter e liberar GPUs com eficiência conforme necessário”, mas os mecanismos exatos não são detalhados. Os métodos potenciais incluem divisão de tempo para executar várias cargas de trabalho simultaneamente, Tecnologia GPU (MIG) de múltiplas instâncias da Nvidia e Contêineres acelerados por GPU orquestrados pelo Kubernetes. Essas técnicas foram usadas por outros provedores de nuvem para tornar a computação de GPU mais acessível.

As GPUs A100 usadas têm 40 GB de memória capacidade, que pode suportar cargas de trabalho de modelo substanciais, mas limitadas, ZeroGPU estará disponível através do Hugging Face’s Spaces, uma plataforma de hospedagem para publicação de aplicativos, que tem mais de 300.000 demonstrações de IA criadas até agora em CPU ou GPU paga.

Financiamento e Visão

O compromisso da Hugging Face com esta iniciativa é possível graças à sua estabilidade financeira, já que a empresa é “lucrativa, ou quase lucrativa” e recentemente levantou US$ 235 milhões em financiamento, avaliando-o em US$ 4,5 bilhões. Delangue expressou preocupação sobre a capacidade das startups de IA de competir com gigantes da tecnologia, que mantêm avanços significativos em IA proprietária e possuem recursos computacionais substanciais. Hugging Face tem como objetivo tornar as tecnologias avançadas de IA acessíveis a todos, não apenas aos gigantes da tecnologia.

Impacto na comunidade

O acesso à computação representa um desafio significativo para a construção de grandes modelos de linguagem, muitas vezes favorecendo empresas como OpenAI e Anthropic. Andrew Reed, engenheiro de aprendizado de máquina da Hugging Face, criou um aplicativo que visualiza o progresso de LLMs proprietários e de código aberto ao longo do tempo, mostrando a lacuna entre os dois que estão cada vez mais próximos. Mais de 35.000 variações do modelo de IA de código aberto Llama do Meta foram compartilhadas no Hugging Face desde a primeira versão do Meta, há um ano.