O mais recente modelo multimodal da OpenAI, GPT-4o, está enfrentando escrutínio devido a problemas com seus dados de tokens chineses. Os problemas resultam de processos inadequados de limpeza de dados, levando a possíveis problemas de desempenho e uso indevido, de acordo com um pesquisador que examinou mais de perto a biblioteca pública de tokens do GPT-4o.

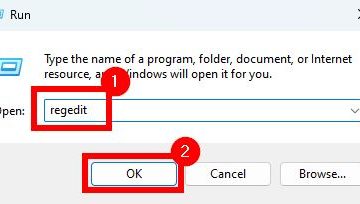

Tokens são as unidades básicas em modelos de linguagem, representando palavras, expressões ou caracteres. Eles permitem que o modelo processe texto com mais eficiência, reconhecendo sequências de caracteres consistentes. O novo tokenizer do GPT-4o inclui 200.000 tokens, sendo 25% em idiomas diferentes do inglês, com o objetivo de melhorar tarefas multilíngues. No entanto, os tokens chineses são predominantemente spam e frases pornográficas, que não são comumente usadas na linguagem cotidiana. Essa discrepância se deve à filtragem insuficiente de dados durante a fase de treinamento.

Impacto no desempenho do modelo

A presença desses tokens inadequados pode fazer com que o modelo gere respostas sem sentido ou não relacionadas. Os investigadores demonstraram que estes tokens também podem ser explorados para contornar os mecanismos de segurança da OpenAI, permitindo ao modelo produzir conteúdo inseguro. Tianle Cai, estudante de doutorado na Universidade de Princeton, identificou o problema analisando os tokens chineses mais longos na biblioteca pública de tokens do GPT-4o, descobrindo que a maioria estavam relacionados a jogos de azar e pornografia.

Acabei de escrever um script para investigar melhor como o corpus usado para treinar o tokenizer gpt4o está poluído por golpes da Internet. Os resultados são bastante interessantes… 🤦♂️🤦♂️🤦♂️https://t.co/Fc2T4rSHix https://t.co/Q1Syh9amJn pic.twitter.com/lQ1u5aQoAs

— Tianle Cai (@tianle_cai) 13 de maio de 2024

Limpeza e soluções de dados

Especialistas sugerem que o problema surge porque os dados de treinamento são poluídos por sites de spam que sequestram conteúdo não relacionado para aumentar sua visibilidade. Este problema não estava presente nas versões anteriores do tokenizer usado no GPT-3.5 e GPT-4. As soluções para esse problema incluem a aplicação de processos rigorosos de limpeza de dados e a garantia de que o tokenizer e o modelo de linguagem sejam treinados em conjuntos de dados consistentes. Técnicas simples, como a tradução automática de palavras-chave detectadas, poderiam reduzir significativamente a prevalência de spam.

A questão ressalta a importância da limpeza completa de dados no desenvolvimento de modelos linguísticos, especialmente para idiomas diferentes do inglês. À medida que a OpenAI continua a refinar seus modelos, resolver esses problemas de qualidade de dados será essencial para melhorar o desempenho e manter a confiança do usuário.