O Google lançou o Project Astra, um novo aplicativo desenvolvido com a IA Gemini do Google e câmeras de smartphones para auxiliar os usuários em suas atividades diárias. Anunciada durante a palestra Google I/O 2024, esta iniciativa destaca os esforços contínuos do Google para desenvolver agentes versáteis de IA capazes de fornecer ajuda prática.

Os recursos são muito semelhantes aos da versão do ChatGPT executada no multimodal GPT-4o modelo, que foi anunciado ontem pela OpenAI. O Projeto Astra faz parte de um conjunto mais amplo de anúncios Gemini no Google I/O 2024. Isso inclui novos modelos como Gemini 1.5 Flash para tarefas mais rápidas, Veo para gerar vídeo a partir de prompts de texto e Gemini Nano para uso de dispositivos locais. A janela de contexto do Gemini Pro está duplicando para 2 milhões de tokens, melhorando sua capacidade de seguir instruções.

Assistência visual alimentada por IA

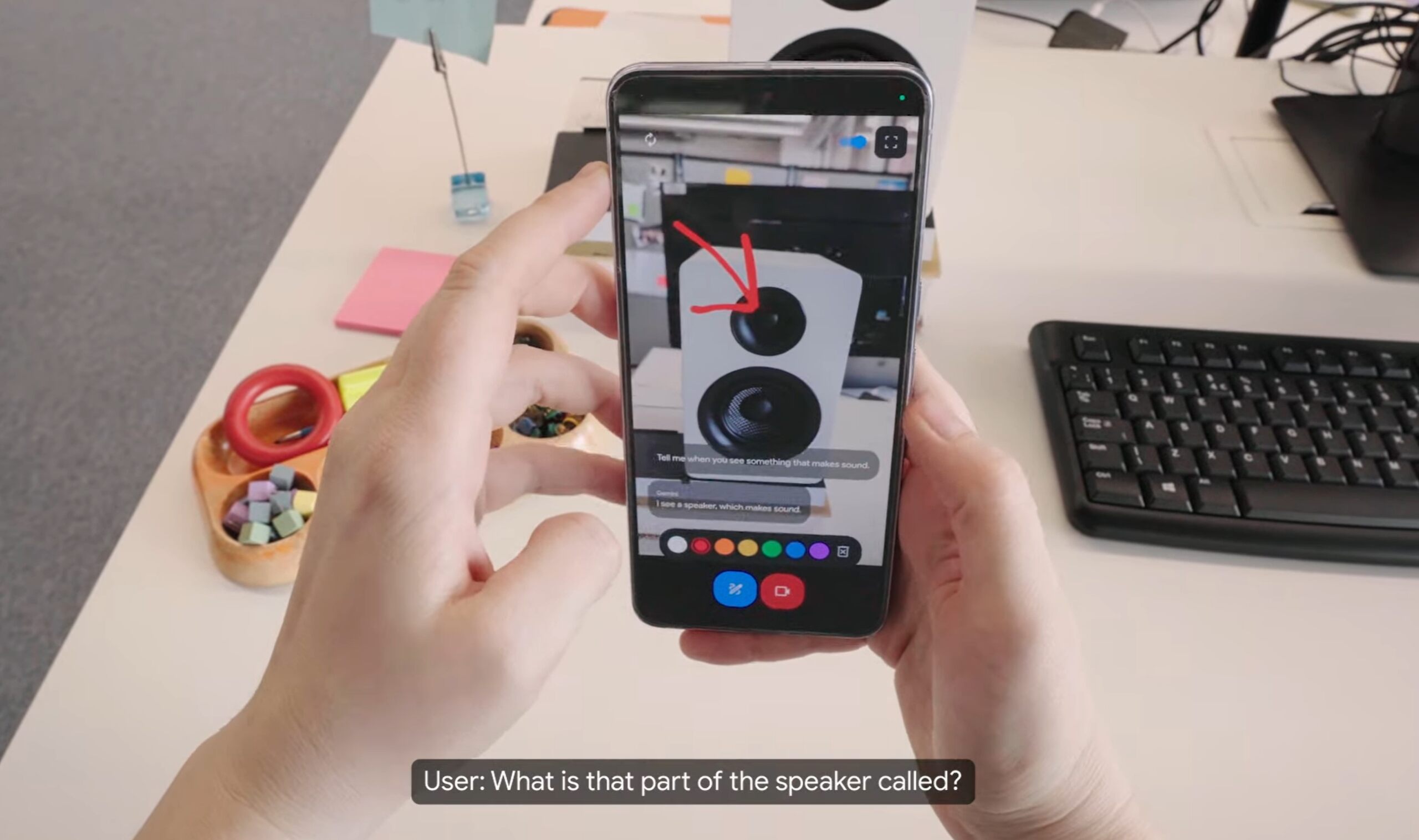

O Projeto Astra funciona como um aplicativo de IA baseado em câmera, usando principalmente um visor como interface. Os usuários podem apontar as câmeras do telefone para vários objetos e interagir verbalmente com a IA, chamada Gemini. Por exemplo, quando um usuário pediu à IA para identificar um objeto que produzia som em um escritório, o Gemini reconheceu um alto-falante e forneceu informações detalhadas sobre seus componentes, como identificar o tweeter e explicar sua função.

O aplicativo também demonstra capacidades criativas. Quando solicitado a criar uma aliteração para uma xícara de giz de cera, Gêmeos respondeu com “Giz de cera criativo colore alegremente. Eles certamente criam criações coloridas.”

Integração de dispositivos vestíveis e recuperação de memória

A demonstração incluiu um segmento em que a IA lembrava a localização de itens que não estavam mais na visão da câmera Quando questionado sobre a localização dos óculos perdidos, Gemini lembrou com precisão que eles estavam em uma mesa perto de uma maçã vermelha. O usuário então usou os óculos, que pareciam ser uma versão avançada do Google Glass, e a perspectiva mudou. à visão do wearable. Os óculos examinavam o ambiente e forneciam informações contextuais, como sugestões de melhorias técnicas para um diagrama do sistema em um quadro branco.

[conteúdo incorporado]

A capacidade da IA de processar dados visuais em tempo real e recuperar observações anteriores é conseguido através da codificação contínua de quadros de vídeo, combinando entradas de vídeo e fala em uma linha do tempo de eventos e armazenando essas informações em cache para uma recuperação eficiente. Este avanço tecnológico permite que a IA responda com rapidez e precisão, melhorando a sua utilidade prática.

Interação multimodal

O Astra foi concebido para ser multimodal, permitindo aos utilizadores interagir conversando, digitando, desenhando, fotografando e filmando. O Google também está lançando o Gemini Live, um assistente somente de voz para conversas de ida e volta, e um novo recurso no Google Lens para pesquisas na web por meio de narração de vídeo.

Atualmente, o Google está trabalhando em aplicativos como planejamento de viagens, onde Gemini pode ajudar a construir e editar itinerários. A equipe da DeepMind ainda está pesquisando a melhor forma de integrar modelos multimodais e equilibrar grandes modelos gerais com modelos menores e focados.

Disponibilidade e melhorias futuras

Durante o projeto O Astra ainda está em seus estágios iniciais, sem data de lançamento específica. O CEO da DeepMind do Google, Demis Hassabis, indicou que alguns recursos da IA seriam integrados aos produtos do Google, como o aplicativo Gemini, no final do ano. A empresa também está trabalhando para melhorar a expressividade vocal de sua IA, visando tornar as interações mais naturais e conversacionais. As possíveis aplicações dessa tecnologia, seja por meio de smartphones ou dispositivos vestíveis avançados, poderiam melhorar significativamente a experiência e a produtividade do usuário.