Se você é fã do DALL·E, o gerador de texto para imagem da OpenAI, deve estar se perguntando o que ele pode fazer com objetos 3D. A OpenAI acaba de responder a isso lançando Shap·E, um novo modelo generativo que pode criar ativos 3D realistas e diversificados a partir de prompts textuais.

Shap·E não é apenas outro gerador de modelo 3D e pode gerar diretamente os parâmetros de funções implícitas que podem ser renderizadas como malhas texturizadas e campos de radiância neural (NeRFs). Isso significa que o Shap·E pode produzir recursos 3D de alta qualidade com texturas refinadas e formas complexas, ao contrário dos modelos anteriores que produzem apenas nuvens de pontos ou voxels.

Recursos 3D de alta qualidade em segundos

Shap·E é treinado em dois estágios: primeiro, um codificador é treinado para mapear de forma determinista ativos 3D nos parâmetros de uma função implícita; segundo, um modelo de difusão condicional é treinado nas saídas do codificador. O codificador garante que os recursos 3D gerados sejam consistentes com o texto de entrada, enquanto o modelo de difusão acrescenta diversidade e realismo à saída.

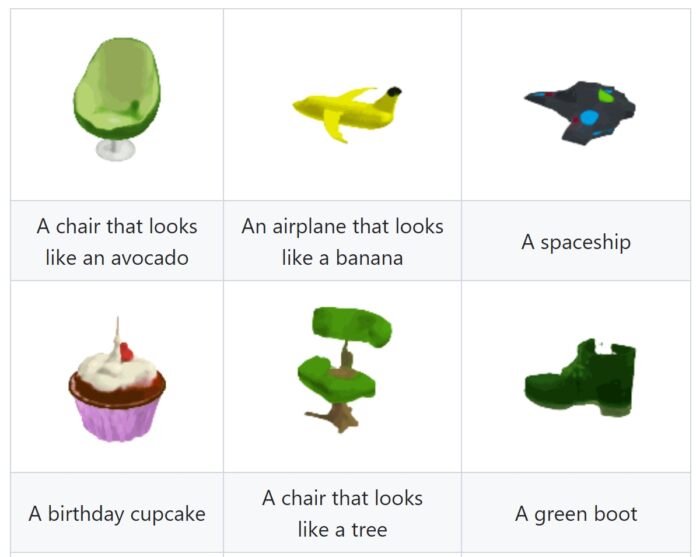

OpenAI apresentou várias instâncias dos resultados do Shap·E, como renderizações 3D baseadas em prompts de texto como uma tigela de comida, um pinguim, um cachorro voxelizado, uma fogueira, um abacate-cadeira em forma, entre outros. Os modelos desenvolvidos com o Shap·E apresentam desempenho excepcional, gerando resultados de alta qualidade em questão de segundos.

Shap·E é capaz de gerar ativos 3D em questão de segundos, mais rápido do que outros modelos como Point·E. Ele também pode lidar com uma ampla variedade de prompts textuais, desde descrições simples até consultas complexas. Por exemplo, você pode pedir ao Shape·E para gerar “um carro vermelho com spoiler e teto solar” ou “um dragão com escamas e asas”. O Shap·E fará o possível para atender à sua solicitação e produzir ativos 3D impressionantes que você pode ver de diferentes ângulos e condições de iluminação.

Shap·E é um avanço na geração de ativos 3D e tem muitas aplicações potenciais em vários domínios, como jogos, animação, educação e comércio eletrônico. Imagine ser capaz de criar seus próprios personagens, cenas e produtos 3D com apenas algumas palavras. O Shap·E torna isso possível e abre novas possibilidades de criatividade e inovação.

Se você quiser experimentar o Shap·E por conta própria, visite o página oficial do GitHub, onde você pode encontrar os pesos do modelo, código de inferência e amostras. O documento de pesquisa relacionado explica mais sobre os detalhes técnicos do Shap·E.

Como o Shap·E usa a difusão Modelos para criar recursos 3D

Shap·E está usando modelos de difusão, que são uma nova classe de modelos generativos profundos que podem produzir dados sintéticos de alta qualidade, como imagens, vídeos e moléculas. Eles se baseiam na ideia de reverter um processo estocástico que gradualmente adiciona ruído aos dados até que se tornem aleatórios. Ao aprender a desfazer esse processo, os modelos de difusão podem gerar amostras realistas de ruído simples.

A ideia básica dos modelos de difusão é modelar a distribuição de dados como a distribuição estacionária de um processo de difusão. Um processo de difusão é um processo estocástico que adiciona ruído gaussiano aos dados em cada etapa, tornando-os cada vez mais aleatórios. O processo reverso, que remove o ruído de amostras aleatórias, pode ser usado para gerar dados.

Para avaliar suas capacidades, Shap·E foi comparado a outro modelo generativo conhecido como Point·E, que cria representações explícitas usando nuvens de pontos. Embora o Shap·E lide com um espaço de saída multi-representacional mais complexo, ele exibiu uma convergência mais rápida e obteve uma qualidade de amostra semelhante ou superior na comparação.

Dica do dia: Cansado da notificação padrão do Windows e de outros sons do sistema? Em nosso tutorial, mostramos como alterar os sons do Windows ou desativar totalmente os sons do sistema.