Em Nas últimas semanas, vimos uma resistência crescente contra os chatbots de inteligência artificial, como o ChatGPT – e, por associação, o Bing Chat da Microsoft. Há preocupação com o desenvolvimento contínuo da IA e até mesmo com a situação regulatória da tecnologia. Em um novo relatório, a Team8 diz que chatbots como o ChatGPT podem estar violando a privacidade do cliente.

A empresa de capital de risco com sede em Israel diz que as soluções de IA que geram conteúdo podem deixar as organizações vulneráveis a ações judiciais e vazamentos de dados. No relatório, que foi dado a Bloomberg, Team8 destaca como os chatbots podem ser alvo de agentes de ameaças.

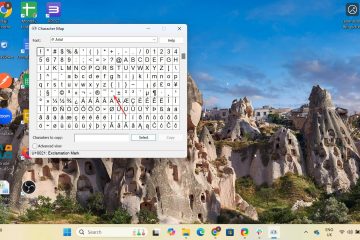

Também existe a possibilidade de os funcionários fornecerem informações confidenciais aos chatbots como parte de seus prompts. AI, como ChatGPT e Bing Chat, dependem do usuário inserir informações como uma consulta. A ferramenta que extrai dados da web para fornecer uma linguagem natural e uma resposta original.

A Microsoft está aproveitando o OpenAI – o desenvolvedor do ChatGPT – em seus serviços. GPT-4, o mecanismo de IA que alimenta o ChatGPT e o Bing Chat. A Microsoft investiu bilhões na OpenAI e agora usa GPT-4 no Office (Microsoft 365 Copilot), Bing (Bing Chat e Bing Image Creator), Microsoft Cloud (Azure OpenAI Service), CRM/ERP (Dynamics 365 Copilot) e programação (GitHub Copilot X).

IA Chatbots podem representar uma ameaça de alto risco

Portanto, a Microsoft se comprometeu de maneira importante com a IA em produtos corporativos e de consumo. Considerando que a Microsoft é a maior empresa de software empresarial do mundo, é provável que a IA se torne parte de organizações em todo o mundo. Team8 diz que o uso de IA generativa apresenta muitos problemas que ainda não foram resolvidos:

“O uso corporativo de GenAI pode resultar em acesso e processamento de informações confidenciais, propriedade intelectual, código-fonte, segredos comerciais e outros dados, por meio de entrada direta do usuário ou da API, incluindo clientes ou informações privadas e informações confidenciais”, diz o relatório, e descreve o risco como”alto”.

“Até o momento, os modelos de linguagem grandes não podem atualizam-se em tempo real e, portanto, não podem retornar as entradas de um para a resposta de outro, desmentindo efetivamente essa preocupação. No entanto, isso não é necessariamente verdade para o treinamento de versões futuras desses modelos”, acrescenta o relatório.

“Do lado do usuário, por exemplo, aplicativos de terceiros que utilizam uma API GenAI, se comprometidos, poderia potencialmente fornecer acesso ao e-mail e ao navegador da Web e permitir que um invasor agisse em nome de um usuário”, diz Team8.

Dica do dia: Para o máximo parte, os aplicativos do Windows são estáveis, mas ainda podem ser prejudicados por atualizações ou problemas de configuração. Muitos inicializam o PC para descobrir que a Microsoft Store não está funcionando ou que os aplicativos do Windows não estão abrindo. Felizmente, o Windows 11 e o Windows 10 têm um recurso de reparo automático para aplicativos que pode resolver esses problemas.